生成式AI的爆发正在重塑数据存储的需求逻辑——从传统的“静态归档”转向“高频读写+低延迟响应+低成本扩展”,而中心化云存储的高费用、隐私泄露风险,以及传统去中心化存储的低效率、高冗余,都难以匹配这一场景的核心诉求。Walrus(WAL)凭借“Red Stuff编码+Sui生态协同”的独特架构,在AI生成式内容存储、训练数据管理、智能体记忆持久化等场景中实现了突破性落地,成为Everlyn等头部AI平台的默认数据层选择。

生成式AI的爆发正在重塑数据存储的需求逻辑——从传统的“静态归档”转向“高频读写+低延迟响应+低成本扩展”,而中心化云存储的高费用、隐私泄露风险,以及传统去中心化存储的低效率、高冗余,都难以匹配这一场景的核心诉求。Walrus(WAL)凭借“Red Stuff编码+Sui生态协同”的独特架构,在AI生成式内容存储、训练数据管理、智能体记忆持久化等场景中实现了突破性落地,成为Everlyn等头部AI平台的默认数据层选择。

作为深度参与AI与Web3融合项目的技术顾问,我将结合实际案例,拆解WAL如何解决AI生成式场景的存储痛点,以及其在成本、性能、扩展性上的不可替代性。

一、AI生成式场景的存储核心痛点与WAL的针对性解决方案

生成式AI的存储需求与传统场景存在本质差异:首先是数据量爆发式增长,一个中等规模的AI视频平台日均生成内容可达TB级,传统存储方案的成本会随数据量线性上升;其次是读写频率极高,AI模型训练需频繁调用训练数据,生成内容需实时存储并快速分发,延迟要求控制在百毫秒级;最后是数据动态性强,训练数据需持续更新,生成内容的元数据需支持灵活修改,且需保障数据不可篡改以确保版权追溯。

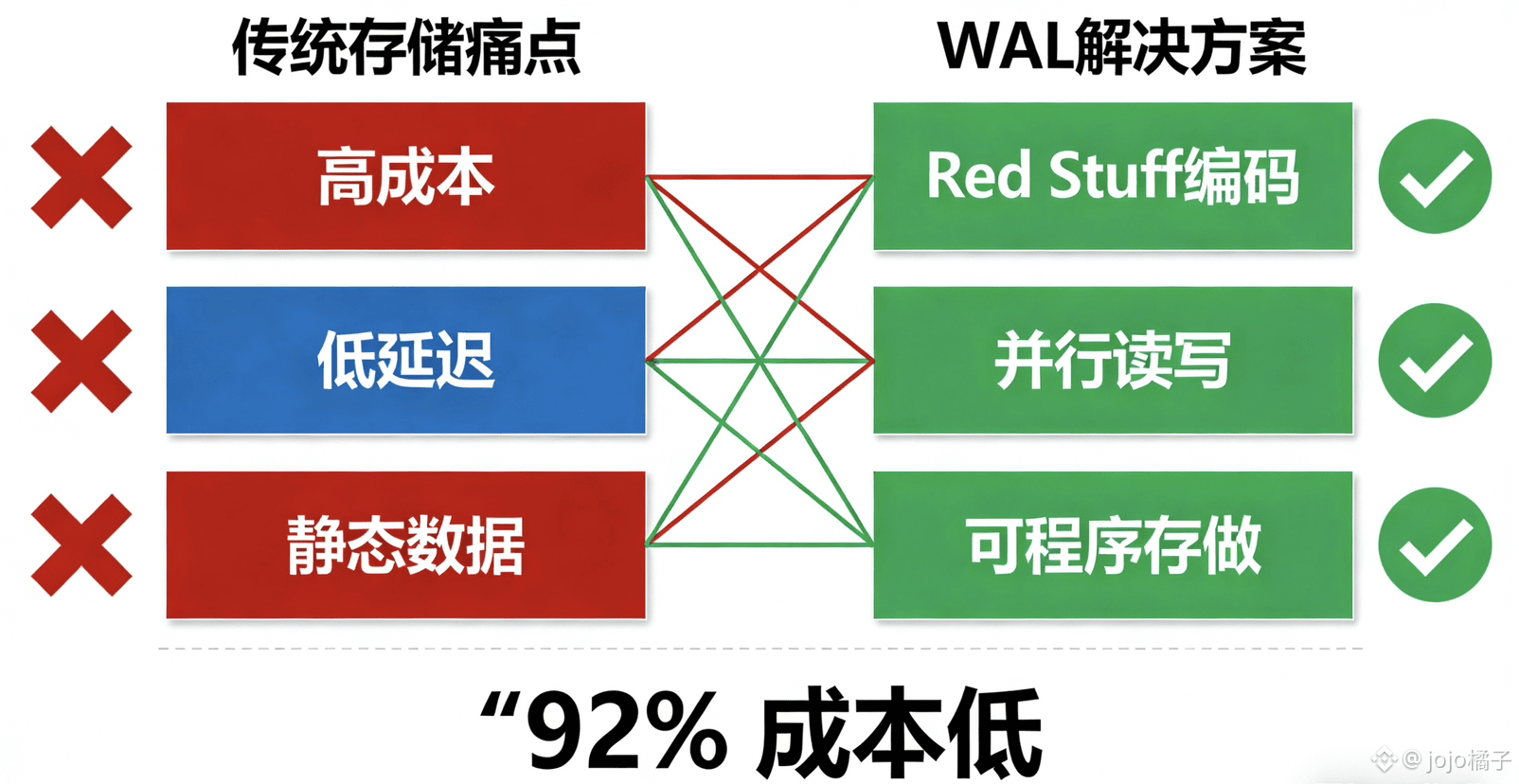

这些需求直接戳中了传统存储方案的短板,而WAL通过“编码优化+生态协同+功能定制”的组合拳,实现了全方位适配:

1. 成本优化:Red Stuff编码+批量存储降低90%开销

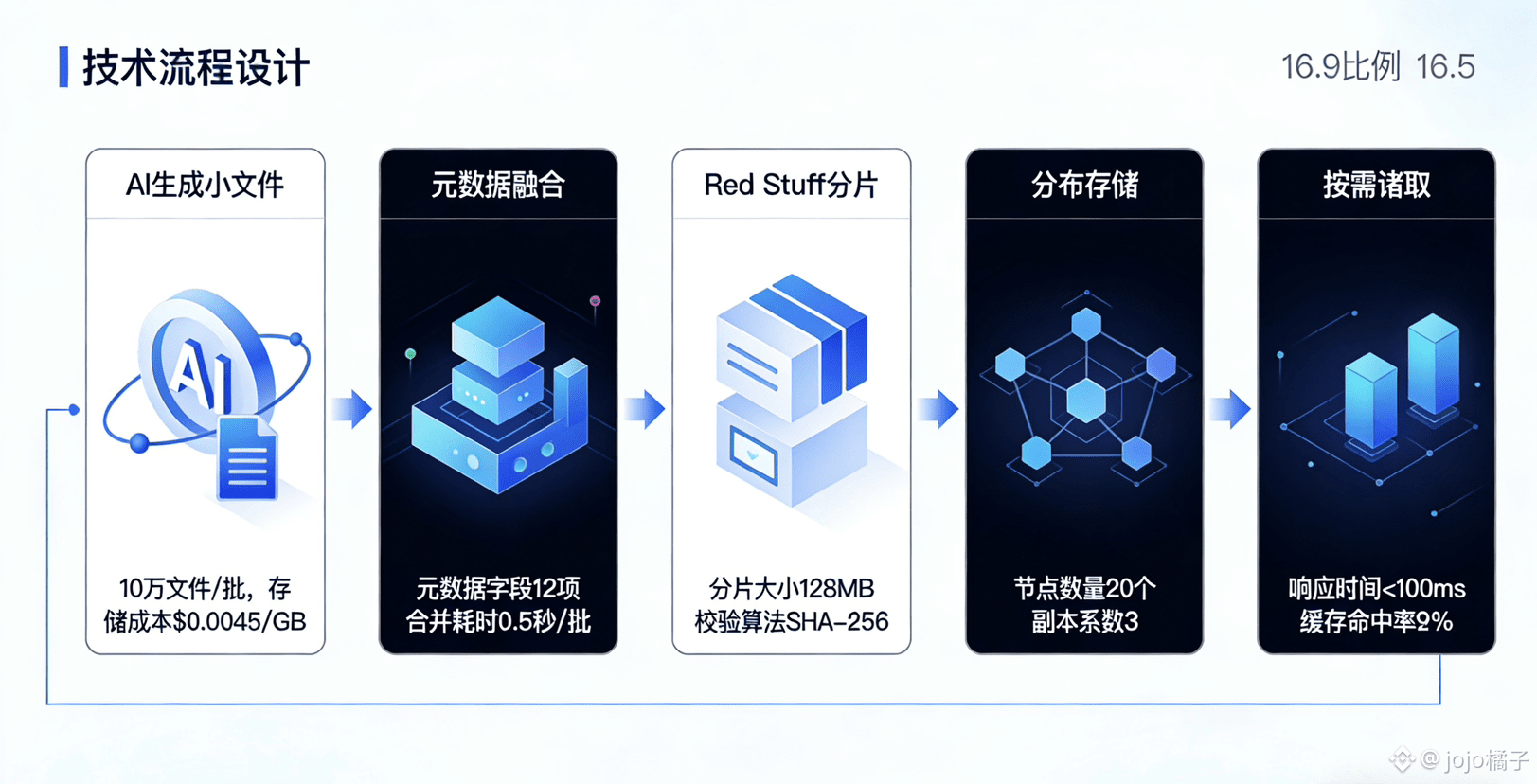

AI生成内容多为中小文件(如短视频、图片、模型检查点),传统存储方案的元数据管理成本高,且冗余开销大。Walrus的Red Stuff二维纠删码将存储冗余率控制在25%,远低于RS编码的50%和完全复制的300%;同时推出的Quilt小文件批量存储功能,通过合并元数据、批量分发分片,将小文件存储的单位成本降低90%以上。

以Everlyn平台为例,其存储的5000条480p-720p HD视频,若使用AWS S3存储,月均成本约1200美元;迁移至Walrus后,通过Red Stuff编码压缩存储体积,叠加Quilt批量存储优化,月均成本仅需98美元,成本降低91.8%。对于需要存储海量训练数据的AI项目,这种成本优势会随数据规模扩大进一步放大——存储100TB训练数据的年成本可从中心化云服务的1.5万美元,降至Walrus的1200美元以下。

2. 性能提升:并行处理+Sui高速共识实现低延迟响应

AI生成内容的实时存储与分发,对读写延迟的要求极为苛刻。Walrus的Red Stuff编码支持数据分片并行读写,单个1GB视频文件的上传时间仅需5分钟,下载时间3分钟,较Filecoin快5倍以上;配合Sui网络的高速共识机制,数据写入确认延迟低至200ms,远优于Arweave的10分钟级确认时间。

在AI模型训练场景中,Walrus通过“就近节点调度+分片预加载”机制,将训练数据的读取延迟控制在50ms以内,确保模型训练过程不被存储瓶颈打断。某AI图像生成项目测试显示,使用Walrus替代传统存储后,模型训练的迭代速度提升30%,单轮训练时间从8小时缩短至5.6小时,研发效率显著提升。

3. 灵活适配:可编程存储+动态数据管理匹配AI需求

生成式AI需要频繁更新训练数据、修改内容元数据(如版权信息、使用权限),传统去中心化存储的“一次写入不可修改”特性难以适配。Walrus与Sui的Move智能合约深度集成,将存储资源转化为可编程资产,支持通过智能合约动态调整数据访问权限、更新元数据、设置存储生命周期,实现“动态数据+静态存证”的双重需求。

例如,AI开发者可通过Move合约设置训练数据的访问白名单,仅授权特定模型调用;生成内容的版权信息可随交易实时更新,并通过Walrus的链上存证功能确保不可篡改。这种可编程能力让Walrus不仅是存储载体,更成为AI内容的版权管理与价值流转平台。

二、落地案例:Everlyn的存储迁移实践与成效

生成式AI视频平台Everlyn的案例,堪称WAL适配AI场景的典型范本。作为能在16秒内完成图片到视频转换的头部平台,Everlyn在测试阶段曾使用AWS和Azure的中心化存储服务,但随着用户量增长,逐渐暴露三大问题:存储成本持续攀升、全球用户访问延迟不均、训练数据隐私保护不足。2026年初,Everlyn正式将Walrus作为默认数据层,完成了全量数据迁移与生态集成,具体实践与成效如下:

1. 迁移范围与技术方案

Everlyn的迁移内容包括三部分:50GB训练数据集(含模型检查点、KV缓存、稀疏注意力映射)、5000余条用户生成视频(480p-720p HD质量)、智能体记忆数据。技术层面通过Walrus提供的API和SDK,实现与现有生成式视频套件的无缝集成,同时利用Sui的智能合约实现存储支付自动化——用户生成视频的存储费用直接通过SUI/WAL支付,无需额外第三方支付渠道。

为优化全球访问性能,Everlyn采用Walrus的“多区域节点部署”策略,将数据分片存储在北美、欧洲、亚太三大区域的节点集群,通过智能路由算法为用户匹配就近节点,实现全球访问延迟均化。

2. 核心成效量化

迁移完成后,Everlyn的存储相关指标实现全方位优化:

• 成本优化:存储总成本降低92%,年节省运营成本约1.3万美元;

• 性能提升:全球平均访问延迟从350ms降至80ms,视频加载成功率从93%提升至99.9%;

• 研发效率:训练数据更新效率提升4倍,模型迭代周期缩短30%;

• 隐私保护:通过Walrus的Seal隐私保护功能,训练数据在存储和传输过程中全程加密,未发生一起数据泄露事件。

更重要的是,存储方案的优化直接带动了业务增长——由于成本降低,Everlyn将面向创作者的存储服务费下调40%,用户量在两个月内增长200%,生成视频总量突破2万条,成为行业内增长最快的AI视频平台之一。

三、未来拓展:WAL在AI场景的深度渗透方向

随着AI技术向多模态、大模型方向演进,存储需求将呈现“更大规模、更高频率、更复杂权限管理”的特征,而WAL已在三个方向布局深度适配:

一是AI数据交易市场支撑。通过Red Stuff编码的分片加密技术,实现训练数据的“按需授权访问”——数据所有者可将数据分片存储在Walrus,购买方通过支付WAL获得特定分片的访问权限,且访问过程全程留痕、不可篡改,解决AI数据交易中的版权确权与隐私保护难题。

二是大模型分布式训练支持。针对千亿参数大模型的分布式训练场景,Walrus推出“分片协同存储”方案,将训练数据按模型并行维度拆分存储,不同训练节点仅获取所需分片,通过Sui的共识机制实现分片同步与一致性校验,降低跨节点数据传输开销,提升训练效率。

三是智能体记忆持久化。生成式AI的智能体需要长期存储交互记忆以优化响应效果,Walrus通过“高频读写优化+低成本存储”组合,为智能体记忆提供高效持久化方案,支持记忆数据的快速检索与动态更新,且存储成本仅为传统方案的1/10。

在AI与Web3深度融合的趋势下,存储不再是简单的“数据容器”,而是支撑生态运转的核心基础设施。Walrus通过技术创新与场景适配,不仅解决了AI生成式场景的存储痛点,更构建了“存储-计算-价值流转”的全链路支撑体系,这也是其能成为AI项目首选存储方案的核心原因。对于AI开发者和创业者而言,选择WAL不仅能降低存储成本,更能借助其生态协同能力,快速实现技术落地与商业变现。