La première fois que j'ai entendu quelqu'un dire « L'IA a besoin de mémoire sur la chaîne », j'ai presque rejeté cela comme une autre vague narrative. Nous avons entendu parler de chaînes plus rapides, de frais moins élevés, de contrats plus intelligents. La mémoire semblait abstraite. Mais plus je regardais VanarChain, plus je réalisais que ce n'est pas une question de stockage au sens habituel. Il s'agit de donner à l'IA un endroit où se souvenir d'une manière qui peut être vérifiée.

La plupart des IA aujourd'hui ont une mémoire à court terme. Un chatbot se souvient de vos derniers messages, peut-être d'une session, puis il oublie. Sous cette commodité se cache un problème. Si l'IA doit gérer des actifs, automatiser des paiements ou exécuter des accords, elle ne peut pas compter sur une mémoire qui disparaît ou qui reste dans une base de données privée. Elle a besoin d'une fondation stable. C'est là que VanarChain se positionne, non pas comme une autre couche 1, mais comme une infrastructure où l'intelligence maintient le contexte.

En surface, VanarChain semble familier. Il fonctionne comme une chaîne compatible EVM. Les transactions se règlent comme tout autre réseau. Les frais sont payés en VANRY. Mais en dessous, il y a un accent sur des couches de mémoire persistantes comme myNeutron, qui est conçu pour stocker le contexte sémantique plutôt que de simples octets bruts. En termes simples, cela signifie qu'au lieu de sauvegarder uniquement des données, la chaîne peut ancrer le sens et les relations. Si un agent d'IA interagit avec un portefeuille, signe un contrat ou exécute un flux, ce contexte peut être écrit d'une manière traçable.

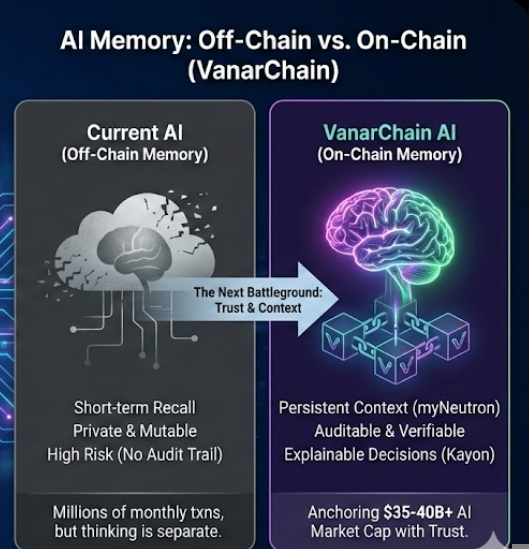

Ce détail compte plus qu'il n'y paraît. En janvier 2026, la capitalisation boursière des tokens du secteur de l'IA se maintient autour de 35 à 40 milliards de dollars, selon le jour, et la volatilité reste élevée. Pendant ce temps, les transactions d'agents d'IA en chaîne à travers plusieurs réseaux ont franchi les millions mensuellement. La croissance de surface semble impressionnante, mais la plupart de ces agents dépendent encore de la mémoire hors chaîne. Ils agissent en chaîne, mais pensent ailleurs. Cette séparation crée un risque.

VanarChain parie que cet écart devient le prochain champ de bataille de la crypto. Pas la vitesse. Pas le seul débit. La mémoire.

Comprendre cela aide à expliquer pourquoi leur récente poussée vers la disponibilité inter-chaînes, commençant par Base, est significative. Base traite actuellement des centaines de milliers de transactions quotidiennes, avec des adresses actives dépassant fréquemment 300 000 par jour pendant les cycles de pointe. Si la couche de mémoire de Vanar peut s'intégrer dans cet environnement, elle n'est plus une expérience de niche. Elle devient intégrée là où la liquidité et les utilisateurs existent déjà.

Lorsque j'ai d'abord examiné le système Flows de Vanar, ce qui m'a frappé, c'est à quel point cela semblait ordinaire. Vous définissez des conditions, connectez des déclencheurs, automatisez des résultats. Cela ressemble à Zapier pour la blockchain. Mais en dessous, cela se lie à Kayon, leur moteur de raisonnement, qui vise à rendre les décisions de l'IA explicables. Ce n'est pas un petit détail. En finance, l'explicabilité n'est pas un luxe. Si une IA liquide une position ou réalloue des fonds, les utilisateurs demanderont pourquoi.

En surface, vous voyez une action automatisée. En dessous, il y a de la logique stockée, de la mémoire référencée, un raisonnement enregistré. Cette superposition est subtile mais puissante. Elle permet quelque chose de nouveau : une IA qui n'agit pas seulement, mais peut montrer sa trace de pensée. Les premiers signes suggèrent qu'à mesure que les régulateurs aux États-Unis et en Europe examinent de plus près les systèmes financiers automatisés en 2026, ce type de transparence pourrait devenir moins optionnel et plus attendu.

Bien sûr, il y a des contre-arguments. Certains développeurs soutiennent que la mémoire devrait rester hors chaîne car elle est moins chère et plus rapide. Stocker des données en chaîne a toujours été coûteux. Même avec des conceptions optimisées, chaque octet a un coût. Cela reste vrai. Si VanarChain évolue vers des applications gourmandes en mémoire, la pression sur les frais pourrait augmenter. Et si l'utilisation ne se matérialise pas, le récit de la mémoire pourrait s'estomper comme d'autres avant lui.

Mais le compromis concerne la confiance. La mémoire hors chaîne est privée et mutable. La mémoire en chaîne est plus lente mais auditable. Si l'IA va gérer des milliards de valeur, quel environnement semble plus stable ? Nous voyons déjà des institutions tester des actifs du monde réel tokenisés nécessitant des pistes d'audit s'étendant sur des années, pas des jours. Une chaîne qui ancre à la fois les transactions et la mémoire contextuelle commence à ressembler moins à une expérience et plus à une infrastructure.

Pendant ce temps, le comportement du marché de VANRY reflète cette tension. Au cours de l'année écoulée, il a connu des cycles d'accumulation pendant les pics de narration sur l'IA et des retraits lors des corrections du marché plus larges. Au début de 2026, les volumes de trading quotidiens ont fréquemment varié dans les dizaines de millions de dollars. Cette liquidité vous dit qu'il y a de l'attention, mais l'attention seule n'est pas de la durabilité. Le vrai test est de savoir si les développeurs construisent des applications durables au-dessus de cette couche de mémoire.

Cet élan crée un autre effet. Si un réseau prouve que la mémoire IA ancrée en chaîne réduit la fraude, améliore la fiabilité de l'automatisation ou simplifie la conformité, d'autres chaînes répondront. Nous avons déjà vu ce schéma auparavant. Lorsque les protocoles DeFi ont prouvé que les teneurs de marché automatisés pouvaient remplacer les livres de commandes pour certains cas d'utilisation, la conception s'est répandue. Lorsque les rollups ont montré que le scalabilité via Layer 2 pouvait fonctionner, l'écosystème a suivi.

La mémoire peut suivre le même chemin. Silencieuse au début. Sous-estimée. Puis standard.

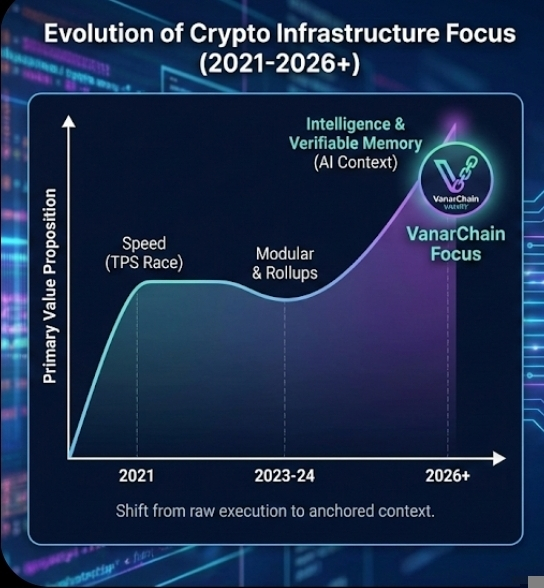

Il y a aussi un changement plus profond qui se produit sous les marchés crypto en ce moment. La conversation passe d'une infrastructure axée sur la vitesse à une infrastructure axée sur l'intelligence. En 2021, la course concernait les transactions par seconde. En 2023 et 2024, il s'agissait de conception modulaire et de rollups. En 2026, alors que les agents d'IA commencent à exécuter des transactions, à rééquilibrer des portefeuilles et à gérer des trésoreries de DAO, la question devient différente. Où vit l'intelligence, et qui peut la vérifier ?

VanarChain n'est pas le seul projet à explorer cet espace, mais c'est l'un des rares à faire de la mémoire un thème central plutôt qu'une caractéristique secondaire. Cet accent lui donne de la texture. Cela semble mérité plutôt que réactif. Si cela tient, cela pourrait redéfinir notre manière de penser aux contrats intelligents. Ils pourraient évoluer d'ensembles de règles statiques à des agents dynamiques avec un contexte à long terme.

Pourtant, l'incertitude demeure. L'adoption par les développeurs est inégale. Des chaînes d'IA concurrentes émergent. Les cycles du marché plus larges peuvent étouffer les récits d'infrastructure nuancés. Et les utilisateurs peuvent ne pas se soucier immédiatement de l'endroit où se trouve la mémoire de l'IA tant que les applications semblent fluides.

Mais l'histoire suggère que ce qui semble invisible au début devient souvent fondamental. Le DNS était invisible. Le stockage cloud était invisible. Même l'espace de bloc lui-même était invisible jusqu'à ce que les frais augmentent.

La mémoire est comme ça. Silencieuse. En dessous. Tenant tout ensemble.

Si l'IA doit gérer des capitaux à grande échelle, le réseau qui contrôle non seulement l'exécution mais aussi le contexte mémorisé pourrait contrôler discrètement l'avenir de la crypto.