Penulis: 0xjacobzhao | https://linktr.ee/0xjacobzhao

Laporan penelitian independen ini didukung oleh IOSG Ventures, proses penelitian dan penulisan terinspirasi oleh laporan penelitian reinforcement learning Sam Lehman (Pantera Capital), terima kasih kepada Ben Fielding (Gensyn.ai), Gao Yuan (Gradient), Samuel Dare & Erfan Miahi (Covenant AI), Shashank Yadav (Fraction AI), Chao Wang atas saran berharga yang diberikan untuk artikel ini. Artikel ini berusaha untuk menyajikan konten yang objektif dan akurat, beberapa pandangan melibatkan penilaian subjektif, tidak dapat dihindari adanya bias, mohon pemahaman dari pembaca.

Artificial intelligence is moving from being primarily focused on 'pattern fitting' statistical learning to a capability system centered on 'structured reasoning', with the importance of post-training rising rapidly. The emergence of DeepSeek-R1 marks a paradigm shift for reinforcement learning in the era of large models, forming an industry consensus: pre-training builds the general capability foundation of models, and reinforcement learning is no longer just a value alignment tool, but has been proven to systematically enhance the quality of reasoning chains and complex decision-making capabilities, gradually evolving into a technological path for continuously improving intelligence levels.

Sementara itu, Web3 sedang membangun kembali hubungan produksi AI melalui jaringan daya terdesentralisasi dan sistem insentif kripto, sementara pembelajaran penguatan memiliki kebutuhan struktural untuk sampling rollout, sinyal hadiah, dan pelatihan yang dapat diverifikasi, yang secara alami cocok dengan kolaborasi daya blockchain, distribusi insentif, dan eksekusi yang dapat diverifikasi. Laporan ini akan membongkar sistematis paradigma pelatihan AI dan prinsip teknis pembelajaran penguatan, membuktikan keunggulan struktural pembelajaran penguatan × Web3, dan menganalisis proyek-proyek seperti Prime Intellect, Gensyn, Nous Research, Gradient, Grail, dan Fraction AI.

1. Tiga tahap pelatihan AI: pra-pelatihan, penyesuaian instruksi, dan penyelarasan pasca-pelatihan

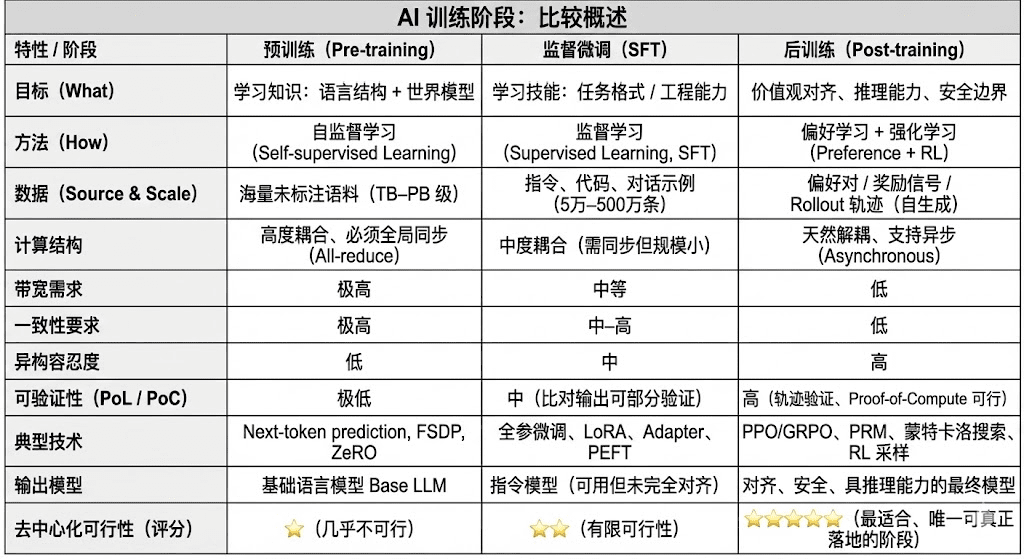

Siklus hidup pelatihan model bahasa besar modern (LLM) biasanya dibagi menjadi tiga tahap inti: pra-pelatihan (Pre-training), fine-tuning yang diawasi (SFT), dan pasca-pelatihan (Post-training/RL). Ketiga tahap tersebut masing-masing menjalankan fungsi “membangun model dunia—menyuntikkan kemampuan tugas—membentuk penalaran dan nilai-nilai”, struktur komputasi mereka, persyaratan data, dan tingkat kesulitan verifikasi menentukan tingkat kecocokan dengan desentralisasi.

Pra-pelatihan (Pre-training) membangun struktur statistik bahasa model dan model dunia lintas moda melalui pembelajaran mandiri skala besar (Self-supervised Learning), merupakan dasar dari kemampuan LLM. Tahap ini memerlukan pelatihan di atas korpus triliunan dengan cara sinkron global, tergantung pada ribuan hingga puluhan ribu kluster H100 yang homogen, dengan biaya mencapai 80–95%, sangat sensitif terhadap bandwidth dan hak cipta data, sehingga harus diselesaikan di lingkungan yang sangat terpusat.

Fine-tuning (Supervised Fine-tuning) digunakan untuk menyuntikkan kemampuan tugas dan format instruksi, dengan volume data kecil, biaya sekitar 5–15%, fine-tuning dapat dilakukan dengan pelatihan parameter penuh atau menggunakan metode fine-tuning yang efisien parameter (PEFT), di mana LoRA, Q-LoRA, dan Adapter adalah arus utama di industri. Namun, tetap memerlukan sinkronisasi gradien, sehingga potensi desentralisasinya terbatas.

Pasca-pelatihan (Post-training) terdiri dari beberapa sub-tahap iteratif yang menentukan kemampuan penalaran, nilai, dan batas keamanan model, metodenya mencakup sistem pembelajaran penguatan (RLHF, RLAIF, GRPO) serta metode optimisasi preferensi non-RL (DPO), dan model hadiah proses (PRM) lainnya. Tahap ini memiliki volume data dan biaya yang lebih rendah (5–10%), terutama terfokus pada Rollout dan pembaruan kebijakan; mendukung secara alami eksekusi asinkron dan terdistribusi, node tidak perlu memiliki bobot lengkap, dengan menggabungkan komputasi yang dapat diverifikasi dan insentif berbasis rantai dapat membentuk jaringan pelatihan terdesentralisasi yang terbuka, adalah bagian yang paling sesuai dengan Web3.

2. Teknologi pembelajaran penguatan panorama: Arsitektur, kerangka, dan aplikasi

2.1 Arsitektur sistem dan elemen inti dari pembelajaran penguatan

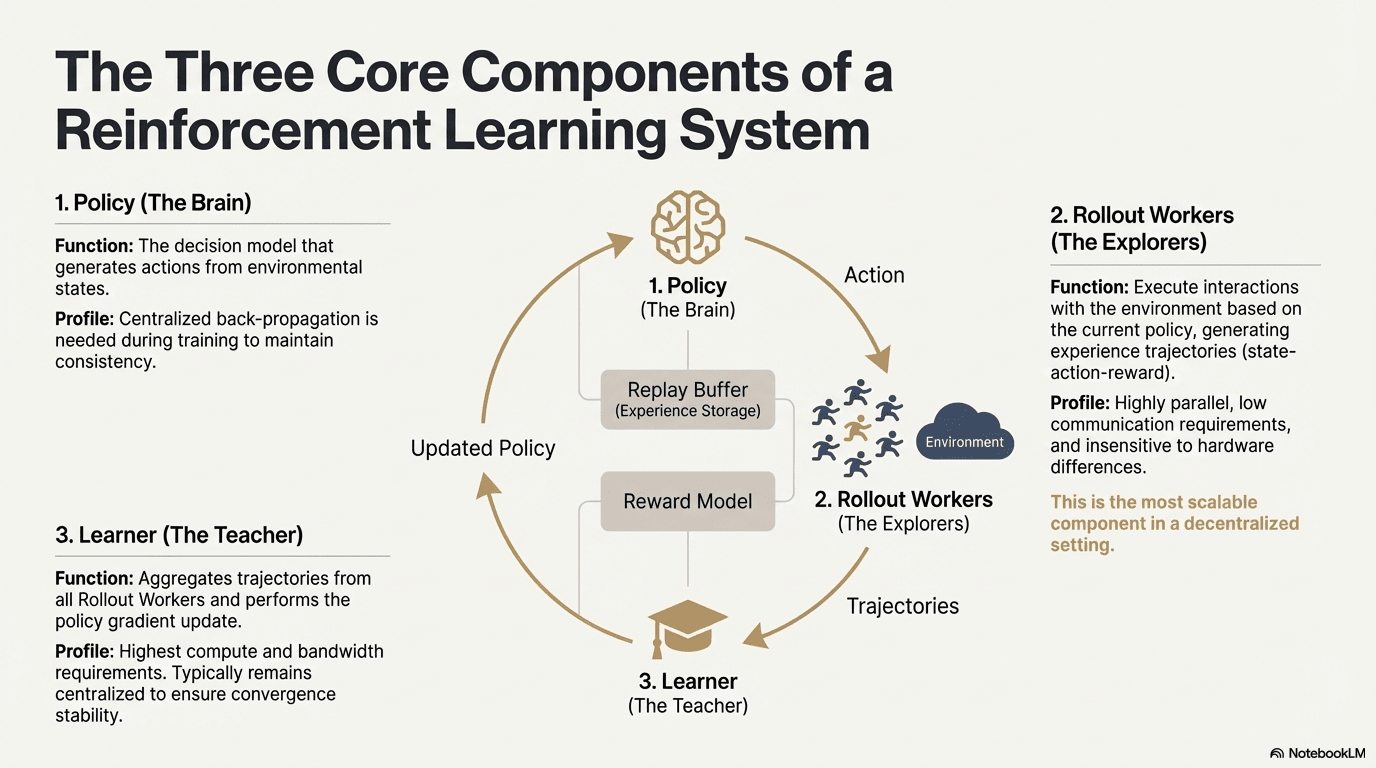

Pembelajaran penguatan (Reinforcement Learning, RL) mendorong model untuk secara mandiri meningkatkan kemampuan pengambilan keputusan melalui “interaksi lingkungan—umpan balik hadiah—pembaruan kebijakan”, struktur intinya dapat dilihat sebagai umpan balik tertutup yang terdiri dari status, tindakan, hadiah, dan kebijakan. Sistem RL yang lengkap biasanya terdiri dari tiga jenis komponen: Kebijakan (Policy), Pengambilan sampel (Rollout), dan Pembelajar (Learner). Kebijakan dan interaksi lingkungan menghasilkan jalur, Pembelajar memperbarui kebijakan berdasarkan sinyal hadiah, sehingga membentuk proses pembelajaran yang terus menerus iteratif dan dioptimalkan.

Jaringan kebijakan (Policy): Menghasilkan tindakan dari status lingkungan, adalah inti keputusan sistem. Selama pelatihan, perlu pembalikan terpusat untuk menjaga konsistensi; saat penalaran dapat didistribusikan ke berbagai node untuk berjalan secara paralel.

Pengambilan sampel pengalaman (Rollout): Node berinteraksi dengan lingkungan berdasarkan kebijakan, menghasilkan status—tindakan—hadiah, dan jalur lainnya. Proses ini sangat paralel, dengan komunikasi yang sangat rendah, dan tidak sensitif terhadap perbedaan perangkat keras, merupakan langkah yang paling cocok untuk diperluas dalam desentralisasi.

Pembelajar (Learner): Menggabungkan semua jalur Rollout dan melakukan pembaruan gradien kebijakan, adalah modul yang memiliki permintaan tertinggi untuk kekuatan komputasi dan bandwidth, sehingga biasanya tetap terpusat atau disebarkan secara ringan untuk memastikan stabilitas konvergensi.

2.2 Kerangka tahap pembelajaran penguatan (RLHF → RLAIF → PRM → GRPO)

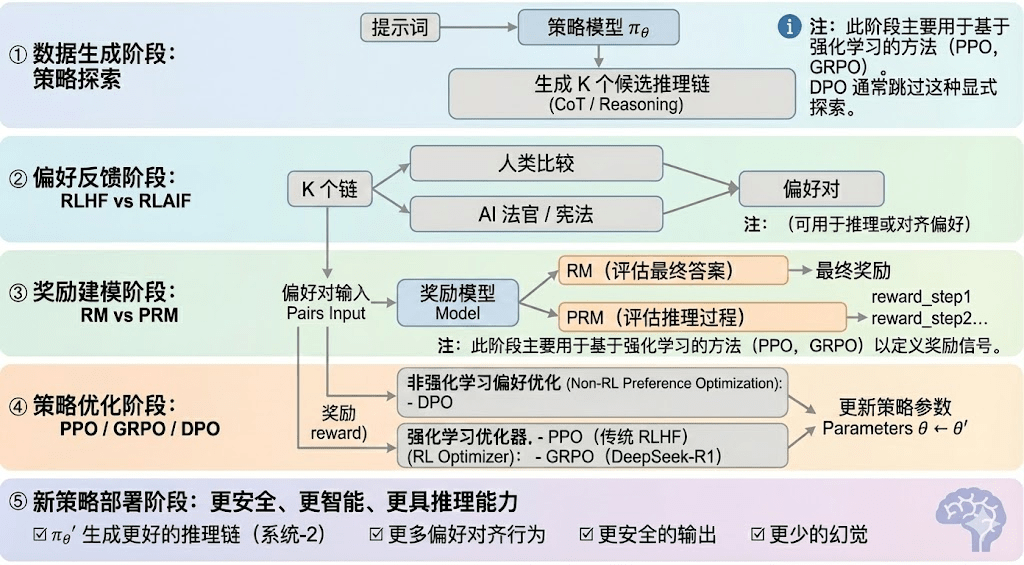

Pembelajaran penguatan biasanya dapat dibagi menjadi lima tahap, alur keseluruhannya dijelaskan sebagai berikut:

Tahap pembuatan data (Policy Exploration): Di bawah kondisi prompt input yang diberikan, model kebijakan πθ menghasilkan beberapa rantai penalaran kandidat atau jalur lengkap, menyediakan dasar sampel untuk evaluasi preferensi dan pemodelan hadiah di masa depan, menentukan kedalaman eksplorasi kebijakan.

Tahap umpan balik preferensi (RLHF / RLAIF):

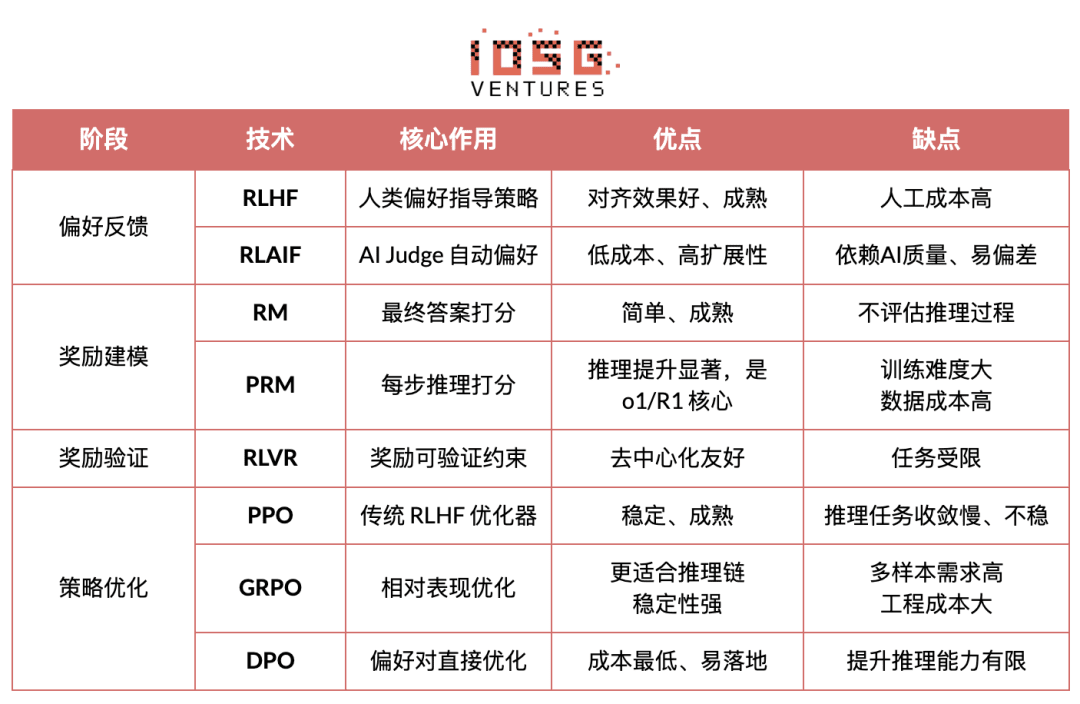

RLHF (Reinforcement Learning from Human Feedback) melalui beberapa jawaban kandidat, anotasi preferensi manual, pelatihan model hadiah (RM), dan menggunakan PPO untuk mengoptimalkan kebijakan, membuat keluaran model lebih sesuai dengan nilai-nilai manusia, merupakan bagian kunci dari transisi GPT-3.5 → GPT-4.

RLAIF (Reinforcement Learning from AI Feedback) menggunakan AI Judge atau aturan konstitusi untuk menggantikan anotasi manual, mewujudkan otomatisasi pengambilan preferensi, secara signifikan mengurangi biaya dan memiliki karakteristik yang dapat diskalakan, telah menjadi paradigma penyelarasan arus utama di Anthropic, OpenAI, DeepSeek, dan lainnya.

Tahap pemodelan hadiah (Reward Modeling): Preferensi terhadap model hadiah input, mempelajari bagaimana mengonversi keluaran menjadi hadiah. RM mengajarkan model “apa jawaban yang benar”, PRM mengajarkan model “bagaimana melakukan penalaran yang benar”.

RM (Reward Model) digunakan untuk menilai kualitas jawaban akhir, hanya memberikan skor terhadap keluaran:

Model hadiah proses PRM (Process Reward Model) tidak hanya menilai jawaban akhir, tetapi juga memberikan skor untuk setiap langkah penalaran, setiap token, setiap segmen logika, juga merupakan teknologi kunci dari OpenAI o1 dan DeepSeek-R1, pada dasarnya “mengajarkan model bagaimana berpikir”.

Tahap verifikasi hadiah (RLVR / Reward Verifiability): Memperkenalkan “keterikatan yang dapat diverifikasi” selama proses pembuatan dan penggunaan sinyal hadiah, agar hadiah sebisa mungkin berasal dari aturan, fakta, atau konsensus yang dapat direproduksi, sehingga mengurangi risiko reward hacking dan bias, serta meningkatkan auditabilitas dan skalabilitas di lingkungan terbuka.

Tahap optimisasi kebijakan (Policy Optimization): Memperbarui parameter kebijakan θ berdasarkan sinyal yang diberikan oleh model hadiah untuk mendapatkan kebijakan πθ′ yang memiliki kemampuan penalaran yang lebih kuat, keamanan yang lebih tinggi, dan pola perilaku yang lebih stabil. Metode optimisasi arus utama termasuk:

PPO (Proximal Policy Optimization): Optimizer tradisional RLHF, terkenal dengan stabilitas, tetapi sering menghadapi batasan seperti konvergensi lambat dan stabilitas yang tidak memadai dalam tugas penalaran yang kompleks.

GRPO (Group Relative Policy Optimization): Inovasi inti dari DeepSeek-R1, dengan memodelkan distribusi keuntungan dalam kelompok kandidat untuk memperkirakan nilai yang diharapkan, bukan hanya peringkat sederhana. Metode ini mempertahankan informasi tentang amplitudo hadiah, lebih cocok untuk optimasi rantai penalaran, proses pelatihan lebih stabil, dianggap sebagai kerangka optimisasi pembelajaran penguatan penting untuk skenario penalaran mendalam setelah PPO.

DPO (Direct Preference Optimization): Metode pasca-pelatihan non-pembelajaran penguatan: tidak menghasilkan jalur, tidak membangun model hadiah, tetapi langsung mengoptimalkan di atas preferensi, biaya rendah, hasil stabil, sehingga banyak digunakan untuk penyelarasan model open-source seperti Llama, Gemma, tetapi tidak meningkatkan kemampuan penalaran.

Tahap penerapan kebijakan baru (New Policy Deployment): Model yang telah dioptimalkan ditampilkan sebagai: kemampuan generasi rantai penalaran yang lebih kuat (System-2 Reasoning), perilaku yang lebih sesuai dengan preferensi manusia atau AI, tingkat ilusi yang lebih rendah, keamanan yang lebih tinggi. Model terus-menerus belajar preferensi, mengoptimalkan proses, dan meningkatkan kualitas keputusan dalam iterasi berkelanjutan, membentuk siklus tertutup.

2.3 Lima kategori aplikasi industri pembelajaran penguatan

Pembelajaran penguatan (Reinforcement Learning) telah berevolusi dari kecerdasan permainan awal menjadi kerangka keputusan mandiri lintas industri, dengan skenario aplikatif yang dapat diringkas ke dalam lima kategori berdasarkan tingkat kematangan teknologi dan penerapan industri, serta mendorong terobosan kunci di masing-masing arah.

Sistem permainan dan strategi (Game & Strategy): Adalah arah pembelajaran penguatan yang pertama kali divalidasi, dalam lingkungan “informasi sempurna + hadiah yang jelas” seperti AlphaGo, AlphaZero, AlphaStar, OpenAI Five, RL menunjukkan kecerdasan pengambilan keputusan yang dapat bersaing bahkan melampaui pakar manusia, meletakkan dasar untuk algoritma RL modern.

Robotika dan kecerdasan terwujud (Embodied AI): RL melalui kontrol berkelanjutan, pemodelan dinamika, dan interaksi lingkungan, memungkinkan robot untuk belajar mengendalikan, kontrol gerakan, dan tugas lintas moda (seperti RT-2, RT-X), sedang dengan cepat menuju industrialisasi, merupakan jalur teknologi kunci untuk penerapan robot di dunia nyata.

Penalaran digital (Digital Reasoning / LLM System-2): RL + PRM mendorong model besar dari “imitasi bahasa” menuju “penalaran terstruktur”, hasil yang diwakili mencakup DeepSeek-R1, OpenAI o1/o3, Anthropic Claude dan AlphaGeometry, pada dasarnya melakukan optimisasi hadiah di tingkat rantai penalaran, bukan hanya menilai jawaban akhir.

Penemuan ilmiah otomatis dan optimasi matematika (Scientific Discovery): RL mencari struktur atau strategi optimal dalam ruang pencarian yang kompleks dengan penghargaan yang tidak berlabel, telah mencapai terobosan dasar seperti AlphaTensor, AlphaDev, Fusion RL, menunjukkan kemampuan eksplorasi yang melampaui intuisi manusia.

Sistem pengambilan keputusan ekonomi dan perdagangan (Economic Decision-making & Trading): RL digunakan untuk optimisasi strategi, kontrol risiko dimensi tinggi, dan menghasilkan sistem perdagangan adaptif, dapat terus belajar dalam lingkungan yang tidak pasti dibandingkan dengan model kuantitatif tradisional, merupakan bagian penting dari keuangan cerdas.

3. Kecocokan alami antara pembelajaran penguatan dan Web3

Kecocokan tinggi antara pembelajaran penguatan (RL) dan Web3 berasal dari keduanya yang pada dasarnya adalah “sistem yang didorong oleh insentif”. RL bergantung pada sinyal hadiah untuk mengoptimalkan kebijakan, sedangkan blockchain mengandalkan insentif ekonomi untuk mengoordinasikan perilaku peserta, sehingga keduanya secara mekanis alami konsisten. Kebutuhan inti RL—Rollout heterogen berskala besar, distribusi hadiah, dan verifikasi keaslian—adalah keunggulan struktural dari Web3.

Pemisahan penalaran dan pelatihan: Proses pelatihan pembelajaran penguatan dapat dipisahkan jelas menjadi dua tahap:

Rollout (sampling eksplorasi): model menghasilkan banyak data berdasarkan strategi saat ini, tugas yang padat secara komputasi tetapi jarang dalam komunikasi. Ini tidak memerlukan komunikasi frekuensi tinggi antar node, cocok untuk pembuatan paralel di GPU konsumer yang tersebar di seluruh dunia.

Pembaruan (parameter update): berdasarkan data yang dikumpulkan untuk memperbarui bobot model, memerlukan node terpusat dengan bandwidth tinggi untuk menyelesaikannya.

“Decoupling penalaran-pelatihan” secara alami cocok dengan struktur daya heterogen terdesentralisasi: Rollout dapat dialihdayakan ke jaringan terbuka, diselesaikan berdasarkan kontribusi melalui mekanisme token, sedangkan pembaruan model tetap terpusat untuk memastikan stabilitas.

Verifiabilitas (Verifiability): ZK dan Proof-of-Learning memberikan cara untuk memverifikasi apakah node benar-benar mengeksekusi penalaran, menyelesaikan masalah kejujuran dalam jaringan terbuka. Dalam tugas-tugas tertentu seperti kode, penalaran matematis, dan lainnya, verifier hanya perlu memeriksa jawaban untuk mengonfirmasi jumlah kerja, secara signifikan meningkatkan kepercayaan sistem RL terdesentralisasi.

Lapisan insentif, mekanisme produksi umpan balik berbasis ekonomi token: Mekanisme token Web3 dapat secara langsung memberi penghargaan kepada kontributor umpan balik preferensi RLHF/RLAIF, sehingga pembuatan data preferensi memiliki struktur insentif yang transparan, dapat diselesaikan, dan tidak memerlukan izin; staking dan slashing lebih lanjut membatasi kualitas umpan balik, membentuk pasar umpan balik yang lebih efisien dan terkoordinasi dibandingkan crowdsourcing tradisional.

Potensi pembelajaran penguatan multi-agen (MARL): Blockchain pada dasarnya adalah lingkungan multi-agen yang terbuka, transparan, dan terus berkembang, di mana akun, kontrak, dan agen terus menyesuaikan strategi di bawah dorongan insentif, membuatnya secara alami cocok untuk membangun eksperimen MARL berskala besar. Meskipun masih berada di tahap awal, sifatnya yang terbuka, dapat dieksekusi secara terverifikasi, dan insentif yang dapat diprogram memberikan keuntungan prinsipil untuk perkembangan MARL di masa depan.

4. Analisis proyek klasik Web3 + pembelajaran penguatan

Berdasarkan kerangka teori di atas, kami akan melakukan analisis singkat terhadap proyek-proyek yang paling representatif dalam ekosistem saat ini:

Prime Intellect: Paradigma pembelajaran penguatan asinkron prime-rl

Prime Intellect berkomitmen untuk membangun pasar daya komputasi terbuka global, menurunkan ambang pelatihan, mendorong pelatihan terdesentralisasi yang kolaboratif, dan mengembangkan tumpukan teknologi super pintar open-source yang lengkap. Sistemnya mencakup: Prime Compute (lingkungan komputasi cloud/distribusi yang terpadu), keluarga model INTELLECT (10B–100B+), pusat lingkungan pembelajaran penguatan terbuka (Environments Hub), dan mesin data sintetis berskala besar (SYNTHETIC-1/2).

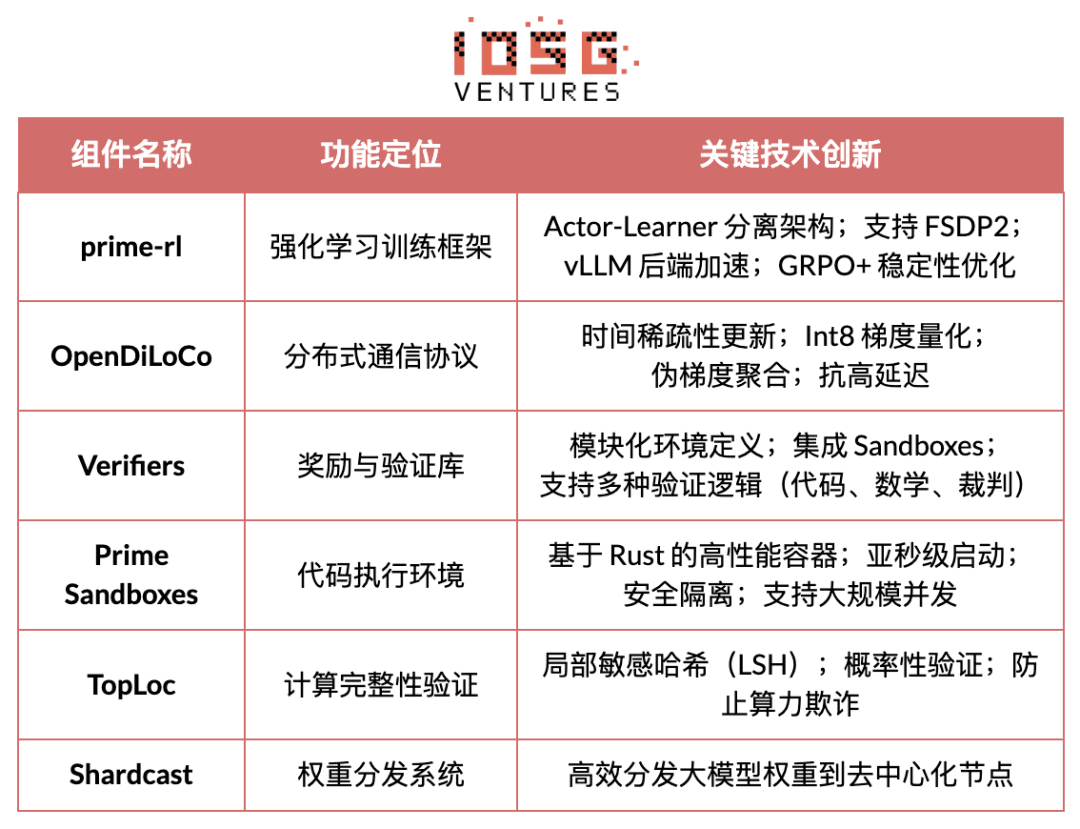

Komponen infrastruktur inti Prime Intellect kerangka prime-rl dirancang khusus untuk lingkungan terdistribusi asinkron dan sangat terkait dengan pembelajaran penguatan, yang lainnya termasuk protokol komunikasi OpenDiLoCo yang memecahkan batasan bandwidth, mekanisme verifikasi TopLoc yang menjamin integritas komputasi, dan sebagainya.

Ikhtisar komponen infrastruktur inti Prime Intellect

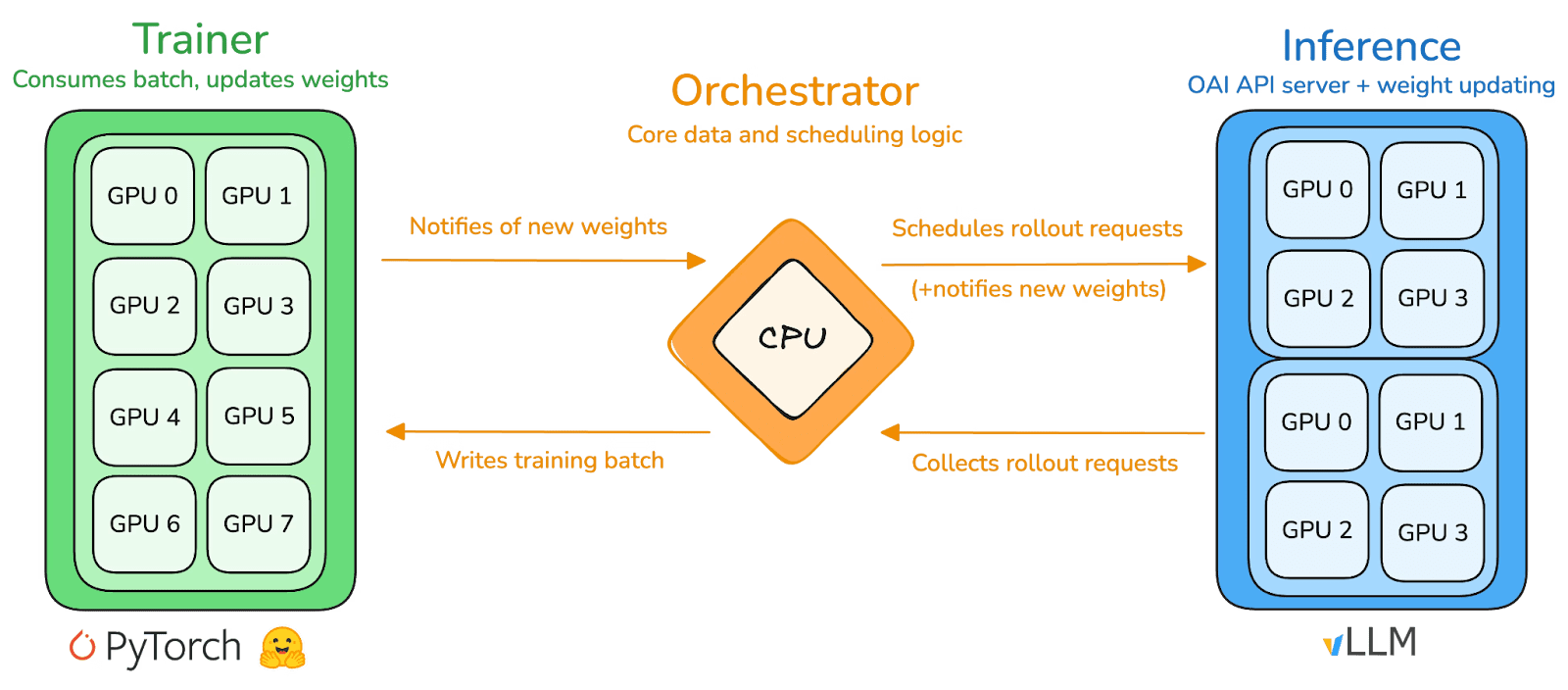

Fondasi teknis: kerangka pembelajaran penguatan prime-rl yang asinkron

prime-rl adalah mesin pelatihan inti Prime Intellect, dirancang khusus untuk lingkungan terdesentralisasi asinkron berskala besar, sepenuhnya memisahkan pelatihan tinggi throughput dan pembaruan yang stabil. Pelaksana (Rollout Worker) dan Pembelajar (Trainer) tidak lagi saling memblokir, node dapat bergabung atau keluar kapan saja, cukup terus menarik strategi terbaru dan mengunggah data yang dihasilkan.

Pelaksana Actor (Rollout Workers): Bertanggung jawab atas penalaran model dan pembuatan data. Prime Intellect secara inovatif mengintegrasikan mesin penalaran vLLM di sisi Aktor. Teknologi PagedAttention dari vLLM dan kemampuan pemrosesan batch berkelanjutan (Continuous Batching) memungkinkan Aktor menghasilkan jalur penalaran dengan throughput yang sangat tinggi.

Pembelajar Learner (Trainer): Bertanggung jawab untuk optimisasi kebijakan. Pembelajar secara asinkron menarik data dari buffer pengalaman yang dibagikan (Experience Buffer) untuk pembaruan gradien, tanpa menunggu semua Aktor menyelesaikan batch saat ini.

Koordinator (Orchestrator): Bertanggung jawab untuk menjadwalkan bobot model dan aliran data.

Inovasi kunci dari prime-rl:

Sepenuhnya asinkron (True Asynchrony): prime-rl mengesampingkan paradigma sinkron tradisional PPO, tidak menunggu node lambat, tidak memerlukan penyelarasan batch, sehingga jumlah dan kinerja GPU yang tidak terbatas dapat terhubung kapan saja, mendasari kelayakan RL terdesentralisasi.

Integrasi mendalam FSDP2 dan MoE: Melalui pemotongan parameter FSDP2 dan aktivasi jarang MoE, prime-rl memungkinkan model tingkat ratusan miliar untuk dilatih secara efisien dalam lingkungan terdistribusi, Aktor hanya menjalankan pakar aktif, secara signifikan mengurangi penggunaan memori dan biaya penalaran.

GRPO+ (Group Relative Policy Optimization): GRPO menghilangkan jaringan Kritikus, secara signifikan mengurangi biaya komputasi dan memori, secara alami cocok untuk lingkungan asinkron, GRPO+ prime-rl lebih memastikan konvergensi yang dapat diandalkan di bawah kondisi latensi tinggi melalui mekanisme stabilisasi.

Keluarga model INTELLECT: Tanda kematangan teknologi RL terdesentralisasi

INTELLECT-1 (10B, Oktober 2024) pertama kali membuktikan bahwa OpenDiLoCo dapat melatih dengan efisien dalam jaringan heterogen yang melintasi tiga benua (komunikasi <2%, pemanfaatan daya 98%), memecahkan batasan kognisi pelatihan lintas wilayah;

INTELLECT-2 (32B, April 2025) sebagai model RL pertama yang tidak memerlukan izin, membuktikan stabilitas konvergensi prime-rl dan GRPO+ dalam lingkungan asinkron dan dengan keterlambatan multi-langkah, mewujudkan RL terdesentralisasi yang melibatkan partisipasi daya terbuka global;

INTELLECT-3 (106B MoE, November 2025) mengadopsi arsitektur jarang yang hanya mengaktifkan 12B parameter, dilatih pada 512×H200 dan mencapai kinerja penalaran tingkat flagship (AIME 90.8%, GPQA 74.4%, MMLU-Pro 81.9%, dll.), kinerja keseluruhan sudah mendekati atau bahkan melampaui model tertutup terpusat yang jauh lebih besar dari dirinya sendiri.

Prime Intellect juga membangun beberapa infrastruktur pendukung: OpenDiLoCo mengurangi jumlah komunikasi pelatihan lintas wilayah hingga ratusan kali dengan komunikasi yang jarang dan perbedaan bobot kuantitas, sehingga INTELLECT-1 tetap mempertahankan 98% penggunaan dalam jaringan lintas tiga benua; TopLoc + Verifiers membentuk lapisan eksekusi terdesentralisasi yang dapat dipercaya untuk memastikan keaslian penalaran dan data hadiah dengan mengaktifkan sidik jari dan verifikasi sandbox; Mesin data SYNTHETIC menghasilkan rantai penalaran berkualitas tinggi dalam skala besar dan memungkinkan model 671B berjalan secara efisien di kumpulan GPU konsumer melalui pemrosesan paralel. Komponen ini menyediakan fondasi rekayasa yang penting untuk pembuatan data terdesentralisasi, verifikasi, dan throughput penalaran. Seri INTELLECT membuktikan bahwa tumpukan teknologi ini dapat menghasilkan model kelas dunia yang matang, menandai bahwa sistem pelatihan terdesentralisasi telah memasuki tahap praktis dari tahap konseptual.

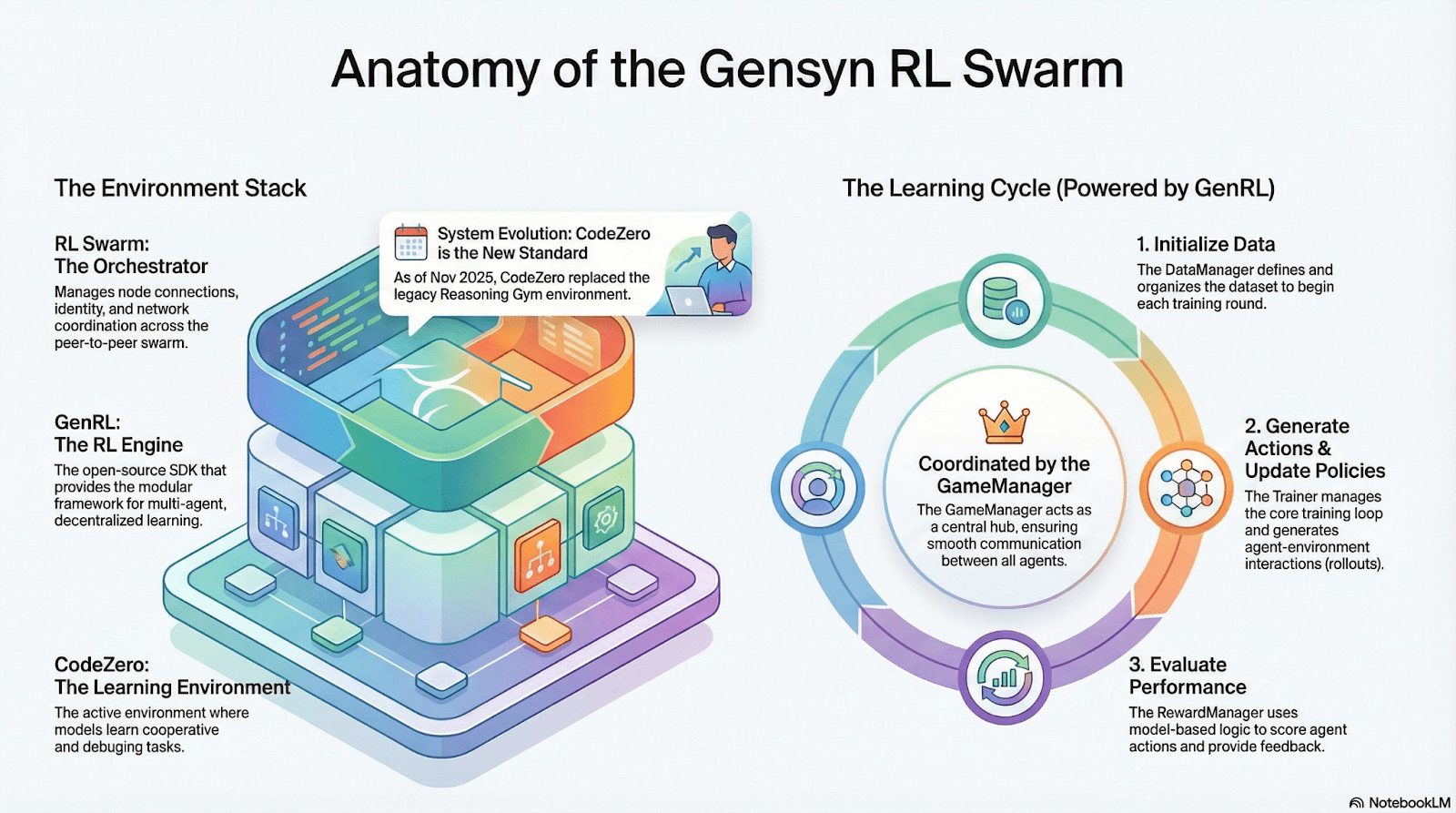

Gensyn: Inti tumpukan pembelajaran penguatan RL Swarm dan SAPO

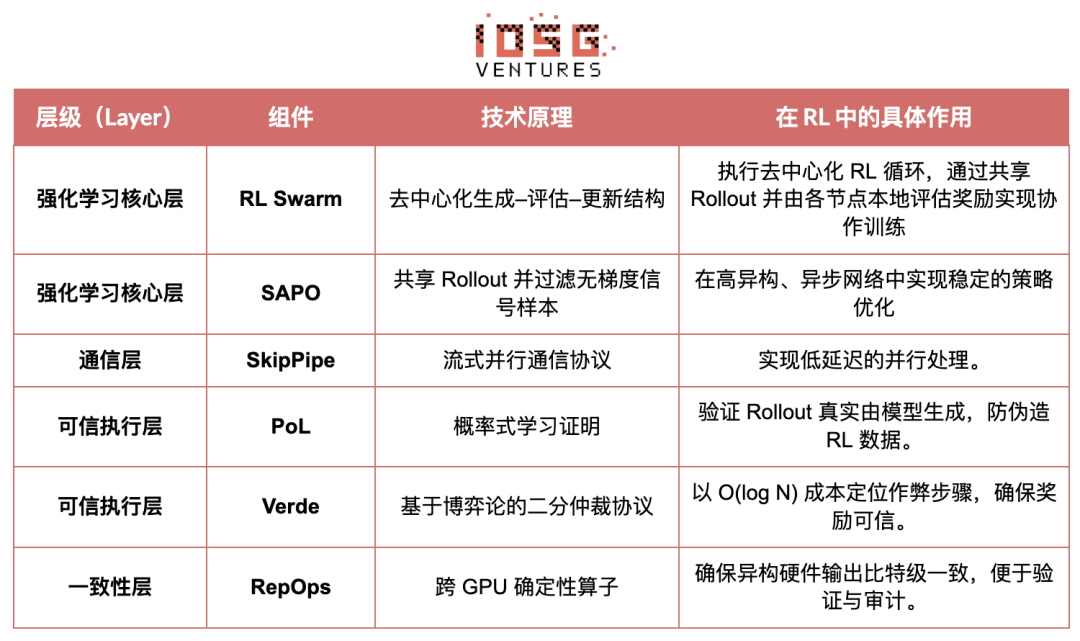

Tujuan Gensyn adalah mengumpulkan daya komputasi global yang tidak terpakai menjadi infrastruktur pelatihan AI yang terbuka, tidak memerlukan kepercayaan, dan dapat diperluas tanpa batas. Intinya mencakup lapisan eksekusi standar lintas perangkat, jaringan koordinasi peer-to-peer, dan sistem verifikasi tugas yang tidak memerlukan kepercayaan, serta secara otomatis membagikan tugas dan insentif melalui kontrak pintar. Dengan mempertimbangkan karakteristik pembelajaran penguatan, Gensyn memperkenalkan mekanisme inti seperti RL Swarm, SAPO, dan SkipPipe, yang memisahkan tiga langkah pembuatan, evaluasi, dan pembaruan, memanfaatkan “kawanan” yang terdiri dari GPU heterogen global untuk mewujudkan evolusi kolektif. Apa yang akhirnya disampaikan bukan sekadar daya komputasi, tetapi kecerdasan yang dapat diverifikasi (Verifiable Intelligence).

Aplikasi pembelajaran penguatan tumpukan Gensyn

RL Swarm: Mesin pembelajaran penguatan kolaboratif terdesentralisasi

RL Swarm menunjukkan mode kolaborasi baru yang sepenuhnya. Ini bukan hanya tentang distribusi tugas yang sederhana, tetapi siklus “generasi-evaluasi-pembaruan” terdesentralisasi yang mensimulasikan pembelajaran masyarakat manusia, mirip dengan proses pembelajaran kolaboratif, berulang tanpa akhir:

Solvers (pelaksana): Bertanggung jawab atas penalaran model lokal dan pembuatan Rollout, heterogenitas node tidak menjadi masalah. Gensyn secara lokal mengintegrasikan mesin penalaran throughput tinggi (seperti CodeZero), dapat menghasilkan jalur lengkap dan bukan hanya jawaban.

Proposers (pembuat soal): Menghasilkan tugas secara dinamis (soal matematika, masalah kode, dll.), mendukung keragaman tugas dan adaptasi kesulitan mirip dengan Pembelajaran Kurikulum.

Evaluators (penilai): Menggunakan “model wasit” atau aturan yang dibekukan untuk mengevaluasi Rollout lokal, menghasilkan sinyal hadiah lokal. Proses evaluasi dapat diaudit, mengurangi ruang untuk berbuat curang.

Ketiga elemen ini bersama-sama membentuk struktur organisasi RL P2P, yang dapat menyelesaikan pembelajaran kolaboratif berskala besar tanpa penjadwalan terpusat.

SAPO: Algoritma optimisasi strategi yang direkonstruksi untuk desentralisasi: SAPO (Swarm Sampling Policy Optimization) berfokus pada “pembagian Rollout dan penyaringan sampel sinyal tanpa gradien, bukan berbagi gradien”, melalui pengambilan sampel Rollout yang terdesentralisasi secara besar-besaran, dan memperlakukan Rollout yang diterima sebagai yang dihasilkan secara lokal, sehingga menjaga konvergensi yang stabil dalam lingkungan tanpa koordinasi pusat dan perbedaan latensi node yang signifikan. Dibandingkan dengan PPO yang bergantung pada jaringan Kritikus dan memiliki biaya komputasi yang lebih tinggi, atau GRPO yang berbasis pada estimasi keuntungan dalam kelompok, SAPO memungkinkan GPU konsumer berpartisipasi secara efektif dalam optimisasi pembelajaran penguatan berskala besar dengan bandwidth yang sangat rendah.

Melalui RL Swarm dan SAPO, Gensyn telah membuktikan bahwa pembelajaran penguatan (terutama RLVR pada tahap pasca-pelatihan) secara alami cocok dengan arsitektur terdesentralisasi—karena lebih bergantung pada eksplorasi yang besar dan beragam (Rollout), daripada sinkronisasi parameter yang berkualitas tinggi. Dengan menggabungkan sistem verifikasi PoL dan Verde, Gensyn menyediakan jalur alternatif untuk pelatihan model dengan triliunan parameter yang tidak lagi bergantung pada satu raksasa teknologi: jaringan super pintar yang terdiri dari jutaan GPU heterogen di seluruh dunia yang secara mandiri berevolusi.

Nous Research: Lingkungan pembelajaran penguatan yang dapat diverifikasi Atropos

Nous Research sedang membangun infrastruktur kognitif yang terdesentralisasi dan dapat berevolusi sendiri. Komponen inti—Hermes, Atropos, DisTrO, Psyche, dan World Sim—disusun menjadi sistem evolusi cerdas yang terus menerus tertutup. Berbeda dengan proses linier “pra-pelatihan—pasca-pelatihan—penalaran” yang tradisional, Nous menggunakan teknologi pembelajaran penguatan seperti DPO, GRPO, dan pengambilan sampel yang ditolak untuk menyatukan pembuatan data, verifikasi, pembelajaran, dan penalaran menjadi umpan balik yang berkelanjutan, menciptakan ekosistem AI yang terus-menerus memperbaiki diri.

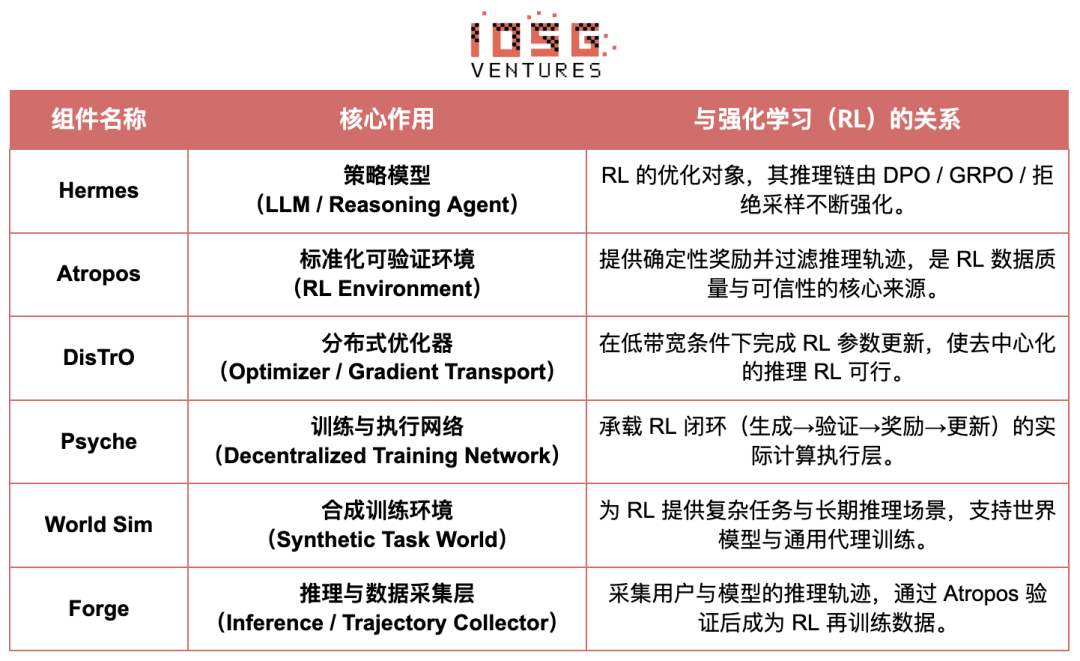

Ikhtisar komponen Nous Research

Tingkat model: Evolusi Hermes dan kemampuan penalaran

Seri Hermes adalah antarmuka model utama Nous Research untuk pengguna, evolusinya menunjukkan dengan jelas jalur industri dari penyelarasan SFT/DPO tradisional menuju pembelajaran penguatan penalaran (Reasoning RL):

Hermes 1–3: Penyelarasan instruksi dan kemampuan agen awal: Hermes 1–3 menyelesaikan penyelarasan instruksi yang kuat melalui DPO biaya rendah, dan di Hermes 3 mengambil keuntungan dari data sintetis dan mekanisme verifikasi Atropos yang baru pertama kali diperkenalkan.

Hermes 4 / DeepHermes: Dengan mengintegrasikan rantai pemikiran ke dalam bobot, meningkatkan kinerja matematika dan kode dengan Test-Time Scaling, dan bergantung pada “pengambilan sampel yang ditolak + verifikasi Atropos” untuk membangun data penalaran murni yang tinggi.

DeepHermes lebih lanjut menggunakan GRPO sebagai pengganti PPO yang sulit diterapkan secara terdistribusi, memungkinkan penerapan RL penalaran di jaringan GPU Psyche yang terdesentralisasi, meletakkan dasar teknik untuk skalabilitas RL penalaran open-source.

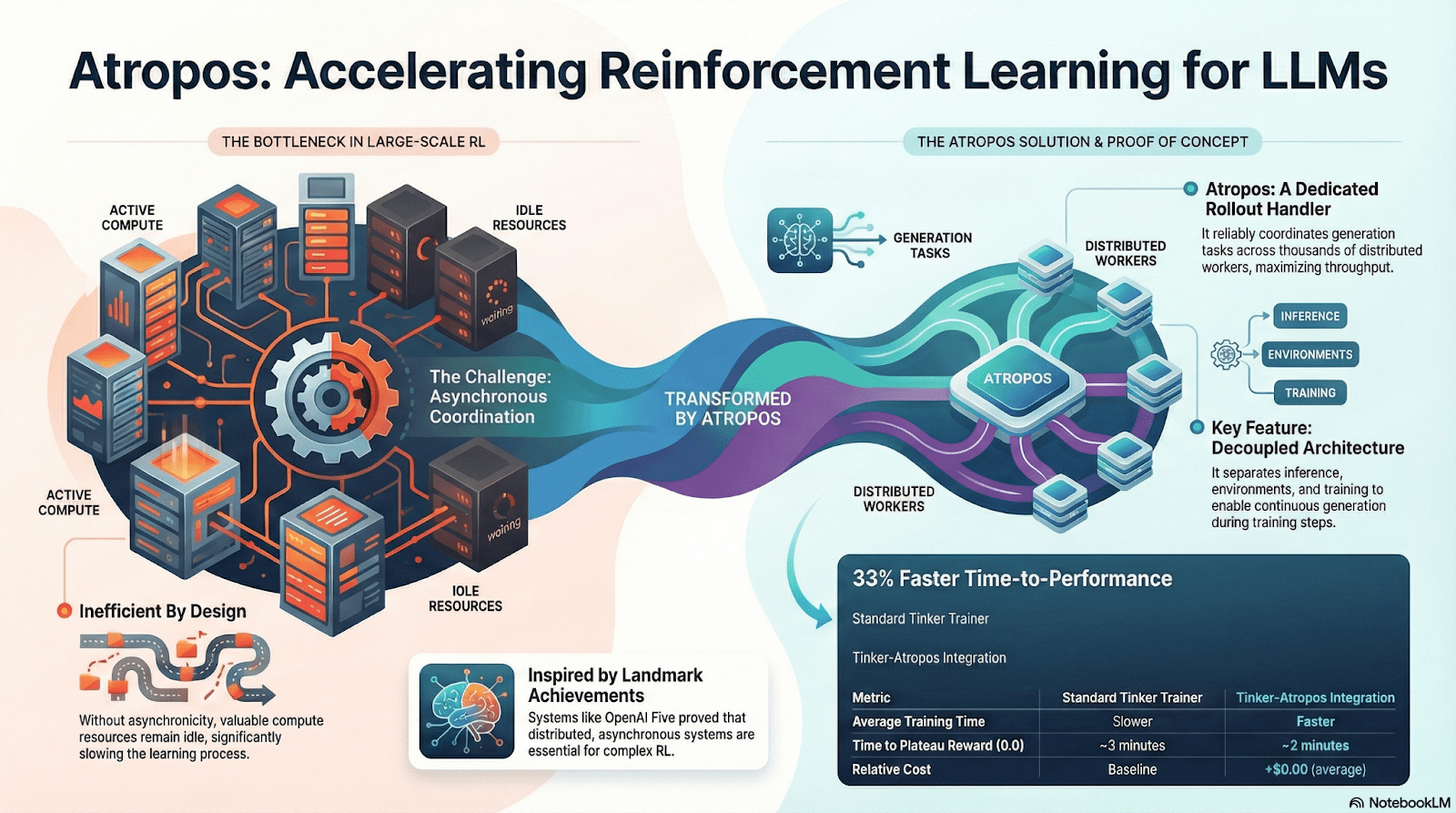

Atropos: Lingkungan pembelajaran penguatan yang didorong oleh hadiah yang dapat diverifikasi

Atropos adalah pusat sebenarnya dari sistem RL Nous. Ini membungkus petunjuk, pemanggilan alat, eksekusi kode, dan interaksi multi-putaran menjadi lingkungan RL yang distandarisasi, dapat diverifikasi secara langsung apakah keluaran benar, sehingga memberikan sinyal hadiah yang pasti, menggantikan anotasi manusia yang mahal dan tidak dapat diperluas. Yang lebih penting, dalam jaringan pelatihan terdesentralisasi Psyche, Atropos bertindak sebagai “wasit”, digunakan untuk memverifikasi apakah node benar-benar meningkatkan strategi, mendukung Proof-of-Learning yang dapat diaudit, secara fundamental memecahkan masalah kepercayaan hadiah dalam RL terdistribusi.

DisTrO dan Psyche: Lapisan pengoptimal untuk pembelajaran penguatan terdesentralisasi

Pelatihan RLF tradisional (RLHF/RLAIF) bergantung pada kluster pusat dengan bandwidth tinggi, ini adalah penghalang inti yang tidak dapat direplikasi oleh sumber terbuka. DisTrO menurunkan biaya komunikasi RL beberapa tingkat melalui pemisahan momentum dan kompresi gradien, memungkinkan pelatihan dijalankan di bandwidth internet; Psyche menerapkan mekanisme pelatihan ini di jaringan berbasis rantai, memungkinkan node untuk melakukan penalaran lokal, verifikasi, evaluasi hadiah, dan pembaruan bobot, membentuk siklus RL yang lengkap.

Dalam sistem Nous, Atropos memverifikasi rantai pemikiran; DisTrO mengompresi komunikasi pelatihan; Psyche menjalankan siklus RL; World Sim menyediakan lingkungan yang kompleks; Forge mengumpulkan penalaran yang nyata; Hermes menuliskan semua pembelajaran ke dalam bobot. Pembelajaran penguatan bukan hanya sebuah tahap pelatihan, tetapi merupakan protokol inti dalam arsitektur Nous yang menghubungkan data, lingkungan, model, dan infrastruktur, menjadikan Hermes sistem hidup yang dapat terus-menerus memperbaiki diri di jaringan daya open-source.

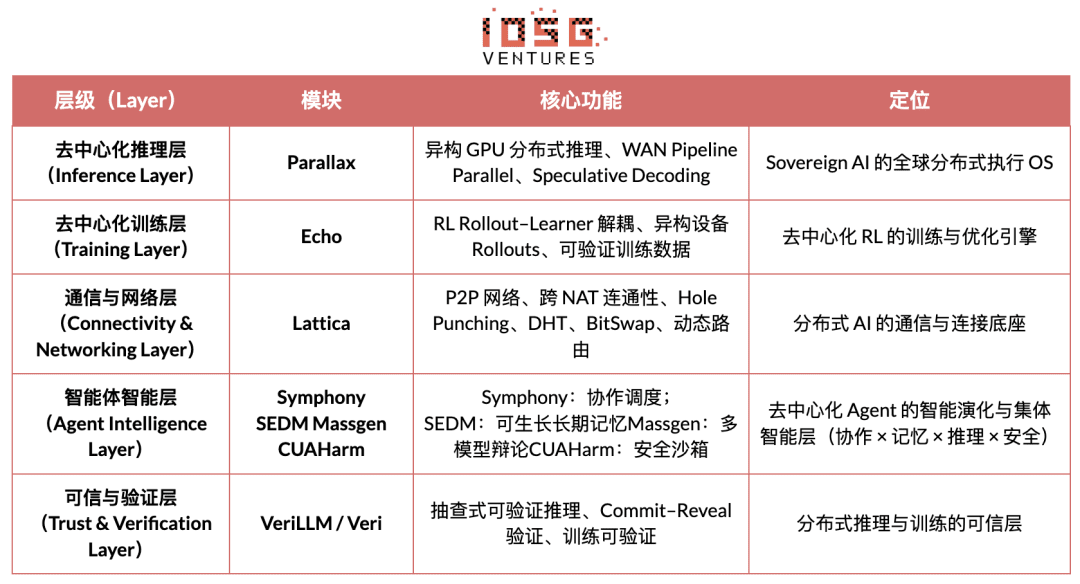

Jaringan Gradien: Arsitektur pembelajaran penguatan Echo

Visi inti Jaringan Gradien adalah merekonstruksi paradigma komputasi AI melalui “tumpukan protokol kecerdasan terbuka” (Open Intelligence Stack). Tumpukan teknologi Gradient terdiri dari serangkaian protokol inti yang dapat berevolusi secara independen dan berkolaborasi secara heterogen. Sistemnya mencakup dari komunikasi dasar hingga kolaborasi cerdas tingkat atas: Parallax (penalaran terdistribusi), Echo (pelatihan RL terdesentralisasi), Lattica (jaringan P2P), SEDM / Massgen / Symphony / CUAHarm (memori, kolaborasi, keamanan), VeriLLM (verifikasi yang dapat dipercaya), Mirage (simulasi berkualitas tinggi), bersama-sama membentuk infrastruktur kecerdasan terdesentralisasi yang terus berkembang.

Echo — Arsitektur pelatihan pembelajaran penguatan

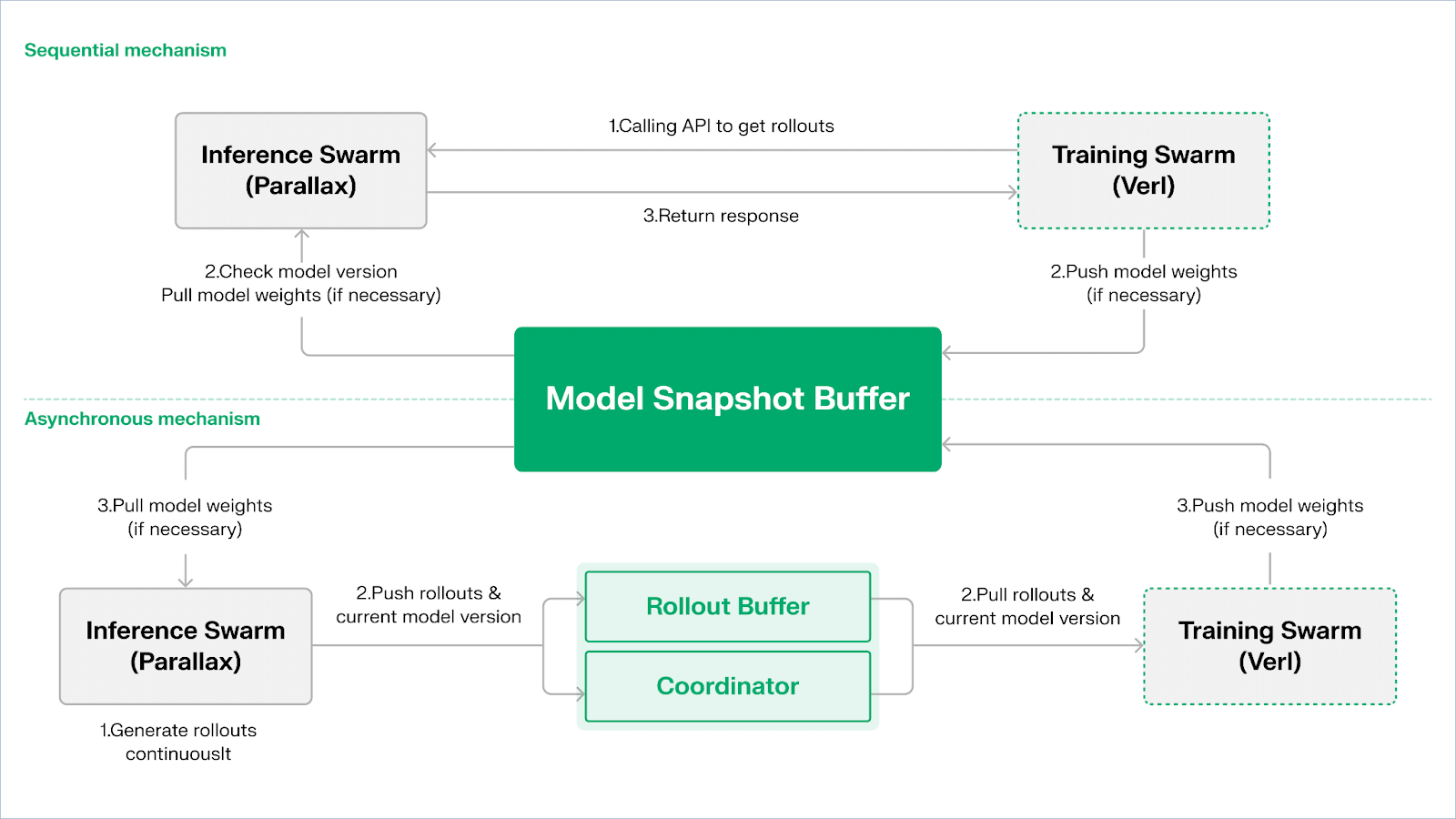

Echo adalah kerangka pembelajaran penguatan dari Gradient, dengan desain inti yang bertujuan untuk memisahkan jalur pelatihan, penalaran, dan data (hadiah) dalam pembelajaran penguatan, sehingga pembuatan Rollout, optimisasi kebijakan, dan evaluasi hadiah dapat berkembang dan dijadwalkan secara independen di lingkungan heterogen. Beroperasi secara bersamaan dalam jaringan heterogen yang terdiri dari node sisi penalaran dan sisi pelatihan, menggunakan mekanisme sinkronisasi ringan untuk mempertahankan stabilitas pelatihan di lingkungan heterogen yang luas, secara efektif meredakan kegagalan SPMD dan bottleneck pemanfaatan GPU yang diakibatkan oleh pencampuran pelatihan dan penalaran tradisional dalam DeepSpeed RLHF / VERL.

Echo menggunakan arsitektur dua kelompok penalaran-pelatihan untuk memaksimalkan pemanfaatan daya, dua kelompok beroperasi secara independen, tidak saling menghalangi:

Maksimalkan throughput sampling: Pengelompokan penalaran Inference Swarm terdiri dari GPU konsumer dan perangkat tepi, membangun sampler throughput tinggi melalui Parallax dalam pipeline-paralel, fokus pada pembuatan jalur;

Maksimalkan kekuatan gradien: Pengelompokan pelatihan Training Swarm terdiri dari jaringan GPU konsumer yang dapat berjalan di kluster terpusat atau di banyak lokasi global, bertanggung jawab untuk pembaruan gradien, sinkronisasi parameter, dan penyesuaian LoRA, fokus pada proses pembelajaran.

Untuk menjaga konsistensi antara strategi dan data, Echo menyediakan dua jenis protokol sinkronisasi ringan: sekuensial (Sequential) dan asinkron (Asynchronous), untuk mencapai manajemen konsistensi dua arah antara bobot strategi dan jalur:

Model penarikan urutan (Pull) | Prioritas akurasi: Sisi pelatihan memaksa node penalaran menyegarkan versi model sebelum menarik jalur baru, untuk memastikan kesegaran jalur, cocok untuk tugas yang sangat sensitif terhadap strategi yang sudah usang;

Model dorong-tarik (Push–Pull) | Prioritas efisiensi: Sisi penalaran terus-menerus menghasilkan jalur dengan label versi, sisi pelatihan mengkonsumsi sesuai ritme mereka sendiri, koordinator memantau deviasi versi dan memicu penyegaran bobot, memaksimalkan penggunaan perangkat.

Di tingkat dasar, Echo dibangun di atas Parallax (penalaran heterogen di bawah bandwidth rendah) dan komponen pelatihan terdistribusi ringan (seperti VERL), bergantung pada LoRA untuk mengurangi biaya sinkronisasi antar node, sehingga pembelajaran penguatan dapat berjalan stabil di jaringan heterogen global.

Grail: Pembelajaran penguatan dalam ekosistem Bittensor

Bittensor melalui mekanisme konsensus Yuma yang unik, membangun jaringan fungsi hadiah yang besar, jarang, dan non-stasioner.

Ekosistem Bittensor Covenant AI membangun jalur terintegrasi vertikal dari pra-pelatihan hingga pasca-pelatihan RL melalui SN3 Templar, SN39 Basilica, dan SN81 Grail. Di antara mereka, SN3 Templar bertanggung jawab atas pra-pelatihan model dasar, SN39 Basilica menyediakan pasar daya terdistribusi, dan SN81 Grail berfungsi sebagai “lapisan penalaran yang dapat diverifikasi” yang ditujukan untuk pasca-pelatihan RL, menyelesaikan optimasi siklus tertutup dari model dasar ke strategi yang selaras.

Tujuan GRAIL adalah untuk membuktikan secara kriptografis keaslian setiap rollout pembelajaran penguatan dan mengikat identitas model, memastikan bahwa RLHF dapat dieksekusi dengan aman di lingkungan tanpa kepercayaan. Protokol membangun rantai terpercaya melalui tiga lapisan mekanisme:

Generasi tantangan deterministik: Menggunakan beacon acak drand dan hash blok untuk menghasilkan tugas tantangan yang tidak dapat diprediksi tetapi dapat direproduksi (seperti SAT, GSM8K), mencegah kecurangan pra-hitung;

Melalui pengambilan sampel indeks PRF dan komitmen sketsa, memungkinkan verifier untuk melakukan pemeriksaan token-level logprob dan rantai penalaran dengan biaya yang sangat rendah, menegaskan bahwa rollout dihasilkan oleh model yang dinyatakan;

Ikatan identitas model: Mengaitkan proses penalaran dengan sidik jari bobot model dan tanda tangan struktural dari distribusi token, memastikan bahwa penggantian model atau replay hasil akan segera terdeteksi. Dengan demikian, memberikan dasar keaslian untuk jalur penalaran (rollout) dalam RL.

Dalam mekanisme ini, subnet Grail telah menerapkan proses pasca-pelatihan yang dapat diverifikasi ala GRPO: penambang menghasilkan beberapa jalur penalaran untuk satu masalah, dan verifier menilai berdasarkan akurasi, kualitas rantai penalaran, dan skor kepuasan SAT, dan menulis hasil yang dinormalisasi ke dalam rantai sebagai bobot TAO. Eksperimen publik menunjukkan bahwa kerangka ini telah meningkatkan akurasi MATH dari Qwen2.5-1.5B dari 12.7% menjadi 47.6%, membuktikan bahwa ia dapat mencegah kecurangan dan secara signifikan memperkuat kemampuan model. Dalam tumpukan pelatihan Covenant AI, Grail adalah fondasi kepercayaan dan eksekusi untuk RLVR/RLAIF terdesentralisasi, dan saat ini belum resmi diluncurkan di mainnet.

Fraction AI: Pembelajaran penguatan berbasis kompetisi RLFC

Arsitektur Fraction AI berfokus pada pembelajaran penguatan kompetisi (Reinforcement Learning from Competition, RLFC) dan anotasi data yang gamified, menggantikan hadiah statis RLHF tradisional dan anotasi manual dengan lingkungan kompetisi terbuka dan dinamis. Agen bersaing di berbagai Spaces, peringkat relatif mereka dan penilaian oleh wasit AI bersama-sama membentuk hadiah waktu nyata, sehingga proses penyelarasan berevolusi menjadi sistem permainan multi-agen yang terus-menerus online.

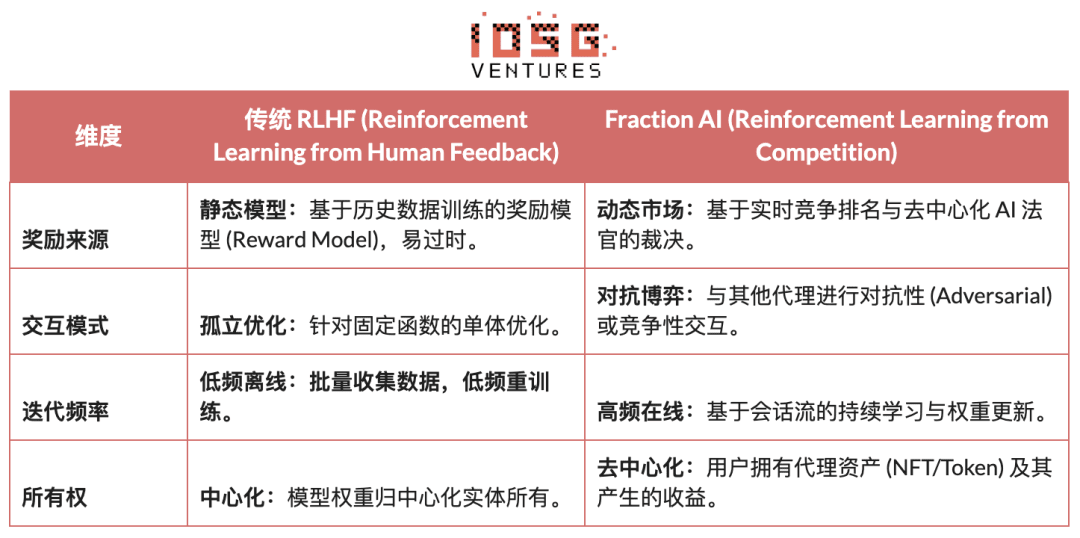

Perbedaan inti antara RLHF tradisional dan RLFC Fraction AI:

Nilai inti RLFC terletak pada hadiah yang tidak lagi berasal dari satu model, tetapi dari lawan dan penilai yang terus berevolusi, mencegah model hadiah dari manipulasi, dan melalui keragaman strategi mencegah ekosistem terjebak dalam optimasi lokal. Struktur Spaces menentukan sifat permainan (zero-sum atau positive-sum), mendorong munculnya perilaku kompleks dalam perlawanan dan kerja sama.

Dalam arsitektur sistem, Fraction AI memecah proses pelatihan menjadi empat komponen kunci:

Agen: Unit strategi ringan berbasis LLM open-source, diperluas dengan bobot diferensial melalui QLoRA, memperbarui dengan biaya rendah;

Spaces: Lingkungan domain tugas terisolasi, agen membayar untuk masuk dan mendapatkan hadiah berdasarkan kemenangan atau kekalahan;

Hakim AI: Lapisan hadiah instan yang dibangun dengan RLAIF, menyediakan evaluasi yang dapat diskalakan dan terdesentralisasi;

Proof-of-Learning: Mengikat pembaruan strategi pada hasil kompetisi tertentu, memastikan bahwa proses pelatihan dapat diverifikasi dan mencegah kecurangan.

Esensi Fraction AI adalah membangun mesin evolusi kolaboratif manusia dan mesin”. Pengguna sebagai “meta pengoptimal” (Meta-optimizer) di tingkat strategi, mengarahkan arah eksplorasi melalui rekayasa petunjuk (Prompt Engineering) dan konfigurasi hyperparameter; sementara agen secara otomatis menghasilkan data preferensi berkualitas tinggi dalam kompetisi mikroskopis. Pola ini memungkinkan anotasi data melalui “penyesuaian tanpa kepercayaan” (Trustless Fine-tuning) untuk mewujudkan siklus bisnis.

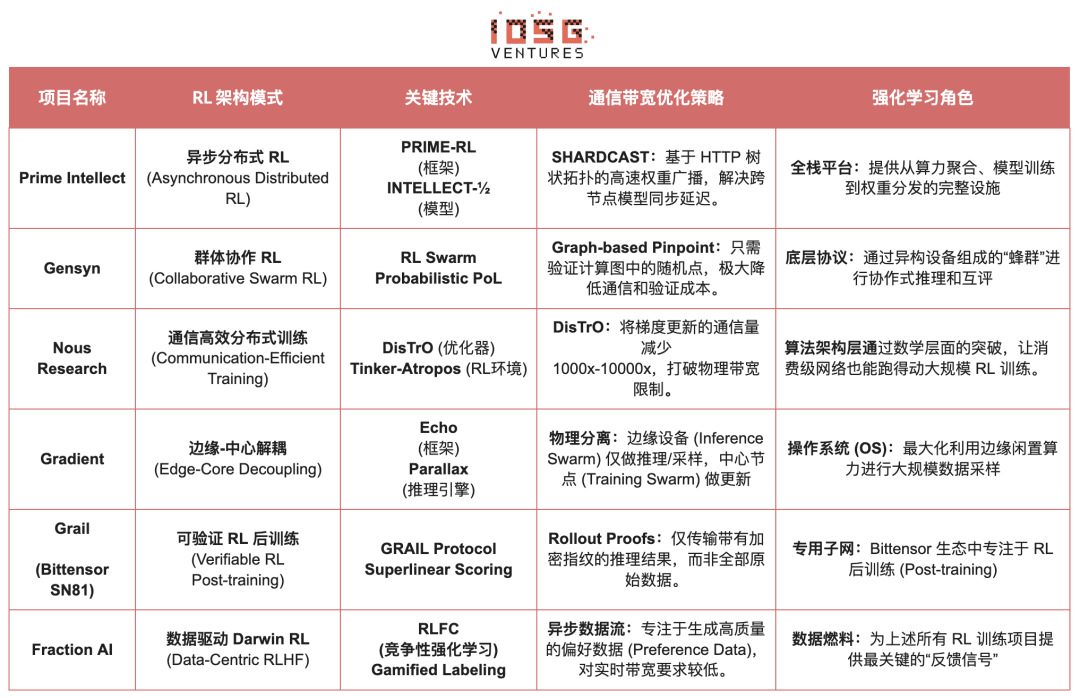

Perbandingan arsitektur proyek Web3 pembelajaran penguatan

5. Ringkasan dan prospek: Jalur dan peluang pembelajaran penguatan × Web3

Berdasarkan analisis dekonstruksi proyek-proyek terdepan di atas, kami mengamati: meskipun titik masuk masing-masing tim (algoritma, rekayasa, atau pasar) beragam, ketika pembelajaran penguatan (RL) digabungkan dengan Web3, logika arsitektur dasarnya berkonvergensi menjadi satu paradigma “decoupling-verifikasi-insentif” yang sangat konsisten. Ini bukan hanya kebetulan teknis, tetapi juga hasil yang tak terhindarkan dari penyesuaian sifat unik pembelajaran penguatan ke jaringan terdesentralisasi.

Karakteristik arsitektur umum pembelajaran penguatan: Mengatasi batasan fisik dan masalah kepercayaan inti

Pemisahan fisik pelatihan (Decoupling of Rollouts & Learning) — Topologi perhitungan default

Pengambilan sampel Rollout yang jarang, dapat diparalelkan, diserahkan kepada GPU konsumer global, pembaruan parameter yang berkualitas tinggi terpusat pada sejumlah kecil node pelatihan, dari Aktor Asinkron Prime Intellect hingga arsitektur dua kelompok Gradient Echo.

Lapisan kepercayaan yang didorong oleh verifikasi (Verification-Driven Trust) — Infrastruktur

Di jaringan tanpa izin, keaslian komputasi harus dipastikan melalui desain matematis dan mekanisme, mencakup implementasi termasuk PoL Gensyn, TOPLOC Prime Intellect, dan verifikasi kriptografi Grail.

Lingkaran insentif yang ditokenisasi (Tokenized Incentive Loop) — Pasar menyesuaikan diri sendiri

Penyediaan daya, pembuatan data, verifikasi urutan dan distribusi hadiah membentuk siklus tertutup, mendorong partisipasi melalui insentif, menekan kecurangan melalui Slash, sehingga jaringan tetap stabil dan terus berkembang dalam lingkungan terbuka.

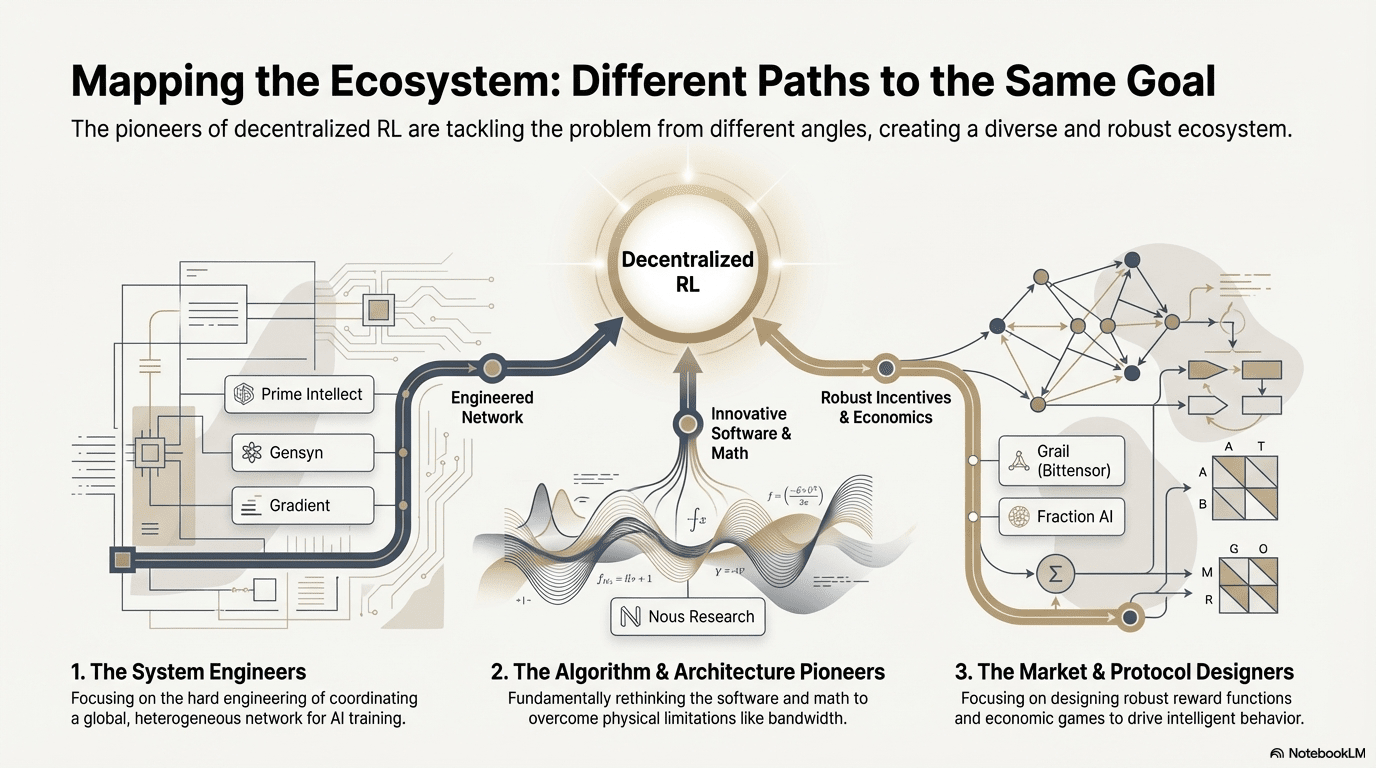

Jalur teknologi yang berbeda: berbagai “titik terobosan” di bawah arsitektur yang konsisten

Meskipun arsitektur cenderung serupa, setiap proyek memilih parit teknis yang berbeda berdasarkan gen mereka sendiri:

Kelompok terobosan algoritma (Nous Research): Mencoba menyelesaikan kontradiksi mendasar pelatihan terdistribusi (bottle neck bandwidth) dari dasar matematika. Optimizer DisTrO bertujuan untuk mengompres jumlah komunikasi gradien hingga ribuan kali, dengan tujuan agar bandwidth rumah dapat menjalankan pelatihan model besar, ini adalah “serangan dimensi” terhadap batasan fisik.

Kelompok rekayasa sistem (Prime Intellect, Gensyn, Gradient): Fokus pada membangun generasi berikutnya dari “sistem runtime AI”. ShardCast Prime Intellect dan Parallax Gradient dirancang untuk memaksimalkan efisiensi kluster heterogen yang ada melalui teknik rekayasa yang ekstrem.

Kelompok permainan pasar (Bittensor, Fraction AI): Fokus pada desain fungsi hadiah (Reward Function). Dengan merancang mekanisme penilaian yang canggih, mendorong penambang untuk secara sukarela mencari strategi terbaik, untuk mempercepat munculnya kecerdasan.

Keunggulan, tantangan, dan prospek akhir

Dalam paradigma penggabungan pembelajaran penguatan dan Web3, keunggulan sistemik pertama kali terwujud dalam restrukturisasi biaya dan struktur pemerintahan.

Restrukturisasi biaya: Kebutuhan Rollout dalam pasca-pelatihan RL tidak terbatas, Web3 dapat memobilisasi daya lembut global dengan biaya sangat rendah, keuntungan biaya ini sulit ditandingi oleh penyedia cloud terpusat.

Penyelarasan berdaulat (Sovereign Alignment): Memecahkan monopoli perusahaan besar atas nilai-nilai AI (Alignment), komunitas dapat memutuskan melalui pemungutan suara Token tentang “apa jawaban yang baik”, mewujudkan demokratisasi pemerintahan AI.

Sementara itu, sistem ini juga menghadapi dua batasan struktural yang besar.

Bandwidth Wall: Meskipun ada inovasi seperti DisTrO, latensi fisik tetap membatasi pelatihan model dengan parameter yang sangat besar (70B+), saat ini Web3 AI lebih terbatas pada fine-tuning dan penalaran.

Hukum Goodhart (Reward Hacking): Dalam jaringan yang sangat terinsentif, penambang sangat mudah “overfit” pada aturan hadiah (memanipulasi poin) daripada meningkatkan kecerdasan yang nyata. Merancang fungsi hadiah yang tangguh untuk mencegah kecurangan adalah permainan abadi.

Serangan node Byzantine yang jahat (BYZANTINE worker): Dengan memanipulasi dan meracuni sinyal pelatihan secara aktif, merusak konvergensi model. Intinya bukan pada mendesain fungsi hadiah yang dapat mencegah kecurangan, tetapi pada membangun mekanisme yang memiliki ketahanan terhadap serangan.

Kombinasi pembelajaran penguatan dan Web3, pada dasarnya adalah penulisan ulang mekanisme “bagaimana kecerdasan diproduksi, diselaraskan, dan didistribusikan nilai”. Jalur evolusinya dapat diringkas dalam tiga arah yang saling melengkapi:

Jaringan pelatihan desentralisasi: Dari mesin penambangan hingga jaringan kebijakan, mengalihdayakan Rollout yang paralel dan dapat diverifikasi kepada GPU panjang ekor global, fokus jangka pendek pada pasar penalaran yang dapat diverifikasi, jangka menengah berevolusi menjadi subnet pembelajaran penguatan yang dikelompokkan berdasarkan tugas;

Asetisasi preferensi dan hadiah: Dari tenaga kerja anotasi menjadi ekuitas data. Mewujudkan asetisasi preferensi dan hadiah, mengubah umpan balik berkualitas tinggi dan Model Hadiah menjadi aset data yang dapat dikelola dan didistribusikan, dari “tenaga kerja anotasi” menjadi “ekuitas data”.

Evolusi “kecil tapi kuat” di bidang vertikal: Menghasilkan agen RL khusus yang kecil tetapi kuat dalam skenario vertikal yang hasilnya dapat diverifikasi dan dapat diukur, seperti pelaksanaan strategi DeFi, pembuatan kode, mengikat perbaikan strategi dan penangkapan nilai secara langsung, dan memiliki potensi untuk mengalahkan model tertutup umum.

Secara keseluruhan, peluang nyata pembelajaran penguatan × Web3 tidak terletak pada penggandaan versi terdesentralisasi dari OpenAI, tetapi pada penulisan ulang “hubungan produksi kecerdasan”: membuat eksekusi pelatihan menjadi pasar daya terbuka, membuat hadiah dan preferensi menjadi aset di rantai yang dapat dikelola, sehingga nilai yang dibawa oleh kecerdasan tidak lagi terpusat pada platform, tetapi didistribusikan kembali antara pelatih, penyelarasan, dan pengguna.

Pernyataan: Artikel ini dalam proses penulisannya dibantu oleh alat AI ChatGPT-5 dan Gemini 3, penulis telah berusaha untuk memeriksa dan memastikan bahwa informasi tersebut nyata dan akurat, tetapi masih tidak dapat dihindari adanya kelalaian, mohon pengertian. Perlu dicatat khusus bahwa pasar aset kripto umumnya memiliki penyimpangan antara fundamental proyek dan kinerja harga di pasar sekunder. Konten artikel ini hanya untuk pengumpulan informasi dan komunikasi akademis/penelitian, tidak dianggap sebagai saran investasi, juga tidak boleh dianggap sebagai rekomendasi untuk membeli atau menjual token apapun.