Autore: 0xjacobzhao | https://linktr.ee/0xjacobzhao

Questo rapporto di ricerca indipendente è supportato da IOSG Ventures. L'autore ringrazia Hans (RoboCup Asia-Pacific), Nichanan Kesonpat(1kx), Robert Koschig (1kx), Amanda Young (Collab+Currency), Jonathan Victor (Ansa Research), Lex Sokolin (Generative Ventures), Jay Yu (Pantera Capital), Jeffrey Hu (Hashkey Capital) per i loro preziosi commenti, così come i collaboratori di OpenMind, BitRobot, peaq, Auki Labs, XMAQUINA, GAIB, Vader, Gradient, Tashi Network e CodecFlow per il loro feedback costruttivo. Sebbene sia stato fatto ogni sforzo per garantire obiettività e accuratezza, alcune intuizioni riflettono inevitabilmente un'interpretazione soggettiva, e i lettori sono incoraggiati a interagire con il contenuto in modo critico.

I. Robotica: Da Automazione Industriale a Intelligenza Umanoide

L'industria della robotica tradizionale ha sviluppato una catena del valore verticalmente integrata, composta da quattro strati principali: componenti core, sistemi di controllo, macchine complete e integrazione di sistemi & applicazioni.

I componenti core (controller, servomotori, riduttori, sensori, batterie, ecc.) hanno le barriere tecniche più elevate, definendo sia i limiti di prestazione che i pavimenti di costo.

I sistemi di controllo agiscono come il "cervello e il cervelletto" del robot, responsabili del processo decisionale e della pianificazione del movimento.

La produzione di macchine complete riflette la capacità di integrare catene di approvvigionamento complesse.

L'integrazione di sistemi e lo sviluppo di applicazioni determinano la profondità della commercializzazione e stanno diventando le principali fonti di creazione di valore.

A livello globale, la robotica sta evolvendo lungo una traiettoria chiara — da automazione industriale → intelligenza specifica per scenari → intelligenza a scopo generale — formando cinque categorie principali: robot industriali, robot mobili, robot di servizio, robot a scopo speciale e robot umanoidi.

Robot Industriali: Attualmente il solo segmento completamente maturo, i robot industriali sono ampiamente utilizzati in saldatura, assemblaggio, verniciatura e processi di movimentazione nelle linee di produzione. L'industria presenta catene di approvvigionamento standardizzate, margini stabili e ROI ben definiti. All'interno di questa categoria, robot collaborativi (cobots)—progettati per una collaborazione sicura uomo-robot, operazione leggera e dispiegamento rapido.

Aziende rappresentative: ABB, Fanuc, Yaskawa, KUKA, Universal Robots, JAKA e AUBORobot Mobili: Inclusi AGV (Veicoli Guidati Automaticamente) e AMR (Robot Mobili Autonomi), questa categoria è ampiamente adottata nella logistica, nell'evasione degli ordini e nel trasporto in fabbrica. È il segmento più maturo per le applicazioni B2B.

Aziende rappresentative: Amazon Robotics, Geek+, Quicktron, Locus Robotics.Robot di Servizio: Destinati ai settori consumer e commerciale—come pulizia, ristorazione e istruzione—questa è la categoria in più rapida crescita dal lato consumer. I robot per la pulizia ora seguono una logica di elettronica di consumo, mentre i robot medici e di consegna stanno rapidamente commercializzando. Una nuova ondata di manipolatori più generali (ad es., sistemi a due braccia come Dyna) sta emergendo—più flessibili rispetto ai prodotti specifici per compiti, ma non così generali come gli umanoidi.

Aziende rappresentative: Ecovacs, Roborock, Pudu Robotics, KEENON Robotics, iRobot, Dyna.

Robot Specializzati: Progettati per applicazioni ad alto rischio o di nicchia—sanità, militare, costruzione, marittimo e aerospaziale—questi robot servono mercati piccoli ma redditizi con forti barriere all'ingresso, tipicamente facendo affidamento su contratti governativi o aziendali.

Aziende rappresentative: Intuitive Surgical, Boston Dynamics, ANYbotics, NASA Valkyrie, Honeybee RoboticsRobot Umanoidi: Considerati come la futura "piattaforma di lavoro universale", i robot umanoidi stanno attirando la maggior parte dell'attenzione all'avanguardia dell'intelligenza incarnata.

Aziende rappresentative: Tesla (Optimus), Figure AI (Figure 01), Sanctuary AI (Phoenix), Agility Robotics (Digit), Apptronik (Apollo), 1X Robotics, Neura Robotics, Unitree, UBTECH, Agibot

Il valore centrale dei robot umanoidi risiede nella loro morfologia simile agli esseri umani, permettendo loro di operare all'interno di ambienti sociali e fisici esistenti senza modifiche all'infrastruttura. A differenza dei robot industriali che perseguono la massima efficienza, i robot umanoidi enfatizzano l'adattabilità generale e la trasferibilità dei compiti, consentendo un dispiegamento senza soluzione di continuità tra fabbriche, case e spazi pubblici.

La maggior parte dei robot umanoidi rimane nella fase di dimostrazione tecnica, focalizzandosi sulla validazione dell'equilibrio dinamico, della locomozione e delle capacità di manipolazione. Sebbene alcuni dispiegamenti limitati abbiano iniziato ad apparire in ambienti di fabbrica altamente controllati (ad es., Figure × BMW, Agility Digit), e ulteriori fornitori come 1X siano attesi per entrare nella distribuzione precoce a partire dal 2026, questi sono ancora applicazioni a scopo ristretto e a compito singolo—non una vera integrazione del lavoro a scopo generale. Una commercializzazione significativa su larga scala è ancora lontana.

I colli di bottiglia centrali si estendono su diversi strati:

La coordinazione Multi-DOF e l'equilibrio dinamico in tempo reale rimangono sfide;

Energia e resistenza sono vincolate dalla densità della batteria e dall'efficienza dell'attuatore;

I pipeline di percezione-decisione spesso si destabilizzano in ambienti aperti e non riescono a generalizzare;

Un significativo divario di dati limita l'addestramento di politiche generalizzate;

Il trasferimento cross-embodiment non è ancora risolto;

Le catene di approvvigionamento hardware e le curve di costo—soprattutto al di fuori della Cina—rimangono barriere sostanziali, rendendo difficile il dispiegamento a basso costo e su larga scala.

La commercializzazione della robotica umanoide avanzerà in tre fasi: Demo-as-a-Service nel breve termine, guidata da piloti e sovvenzioni; Robotics-as-a-Service (RaaS) nel medio termine, poiché emergono ecosistemi di compiti e abilità; e un modello di Labor Cloud a lungo termine, dove il valore si sposta dall'hardware al software e ai servizi in rete. Complessivamente, la robotica umanoide sta entrando in una transizione cruciale da dimostrazione a auto-apprendimento. Se l'industria può superare le barriere intrecciate di controllo, costo e intelligenza determinerà se l'intelligenza incarnata può veramente diventare una forza economica scalabile.

II. AI × Robotica: L'Alba dell'Era dell'Intelligenza Incarnata

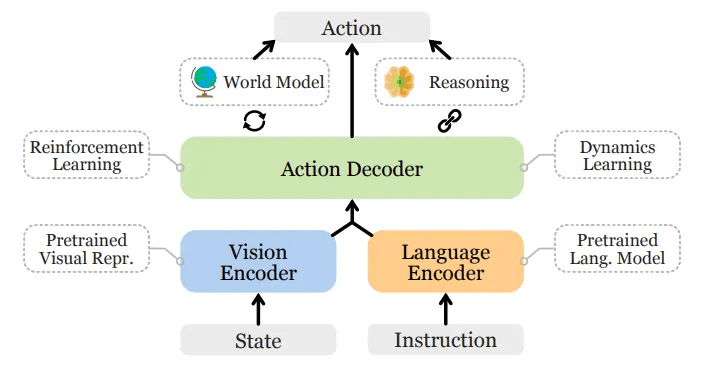

L'automazione tradizionale si basa fortemente su logiche pre-programmate e architetture di controllo basate su pipeline—come il paradigma DSOP (percezione-pianificazione-controllo)—che funzionano in modo affidabile solo in ambienti strutturati. Il mondo reale, tuttavia, è molto più complesso e imprevedibile. La nuova generazione di AI incarnata segue un paradigma completamente diverso: sfruttare grandi modelli e apprendimento di rappresentazioni unificate per dare ai robot capacità trans-scena per comprensione, previsione e azione. L'intelligenza incarnata enfatizza il accoppiamento dinamico del corpo (hardware), del cervello (modelli) e dell'ambiente (interazione). Il robot è solo il veicolo—l'intelligenza è il vero nucleo.

L'AI generativa rappresenta l'intelligenza nel mondo simbolico e linguistico—eccelle nella comprensione del linguaggio e delle semantiche. L'AI incarnata, al contrario, rappresenta l'intelligenza nel mondo fisico—domina la percezione e l'azione. I due corrispondono al "cervello" e al "corpo" dell'evoluzione dell'AI, formando due frontiere parallele ma convergenti.

Da una prospettiva gerarchica dell'intelligenza, l'AI incarnata è una capacità di ordine superiore rispetto all'AI generativa, ma la sua maturità è molto indietro. Gli LLM beneficiano di dati abbondanti a scala internet e di un ciclo ben definito "dati → calcolo → dispiegamento". L'intelligenza robotica, tuttavia, richiede dati egocentrici, multimodali e ancorati all'azione—traiettorie di teleoperazione, video in prima persona, mappe spaziali, sequenze di manipolazione—che non esistono per default e devono essere generate attraverso interazione reale o simulazione ad alta fedeltà. Questo rende i dati molto più scarsi, costosi e difficili da scalare. Anche se i dati simulati e sintetici aiutano, non possono sostituire completamente l'esperienza sensori-motoria reale. Questo è il motivo per cui aziende come Tesla e Figure devono gestire fabbriche di teleoperazione, e perché sono emerse fattorie di raccolta dati nel SEA. In breve, gli LLM apprendono da dati esistenti; i robot devono crearne di propri tramite interazione fisica.

Nei prossimi 5–10 anni, entrambi si convergeranno profondamente attraverso modelli Vision-Language-Action (VLA) e architetture di Agenti Incarnati—gli LLM gestiranno la cognizione e la pianificazione ad alto livello, mentre i robot eseguiranno azioni nel mondo reale, formando un ciclo bidirezionale tra dati ed embodiment, spingendo così l'AI dall'intelligenza linguistica verso la vera intelligenza generale (AGI).

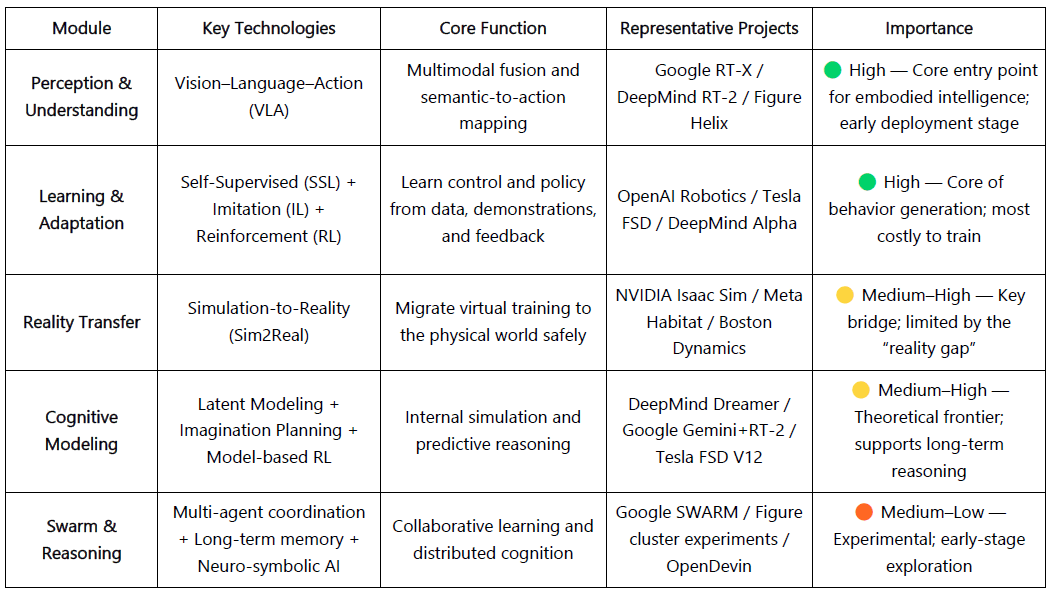

Il Stack Tecnologico Centrale dell'Intelligenza Incarnata

L'AI incarnata può essere concettualizzata come uno stack di intelligenza dal basso verso l'alto, costituendo:

VLA (Fusione della Percezione), RL/IL/SSL (Apprendimento), Sim2Real (Trasferimento nella Realtà), Modello del Mondo (Modellazione Cognitiva) e Sciame & Ragionamento (Intelligenza Collettiva e Memoria).

Percezione & Comprensione: Visione-Linguaggio-Azione (VLA)

Il modello VLA integra Visione, Linguaggio e Azione in un sistema multimodale unificato, consentendo ai robot di comprendere le istruzioni umane e tradurle in operazioni fisiche. Il pipeline di esecuzione include analisi semantica, rilevamento oggetti, pianificazione del percorso e esecuzione delle azioni, completando il ciclo completo di "comprendere la semantica → percepire il mondo → completare il compito." Progetti rappresentativi: Google RT-X, Meta Ego-Exo e Figure Helix, che mostrano progressi nella comprensione multimodale, percezione immersiva e controllo condizionato dal linguaggio.

I sistemi VLA sono ancora in una fase iniziale e affrontano quattro colli di bottiglia fondamentali:

Ambiguità semantica e debole generalizzazione dei compiti: i modelli faticano a interpretare istruzioni vaghe o aperte;

Allineamento instabile visione-azione: gli errori di percezione vengono amplificati durante la pianificazione e l'esecuzione;

Dati multimodali scarsi e non standardizzati: raccolta e annotazione rimangono costose, rendendo difficile costruire volani di dati su larga scala;

Sfide a lungo termine attraverso assi temporali e spaziali: lunghe linee temporali mettono a dura prova pianificazione e memoria, mentre grandi orizzonti spaziali richiedono ragionamento su elementi fuori percezione—cosa che gli attuali VLA mancano a causa di modelli di mondo limitati e inferenza trasversale.

Questi problemi limitano collettivamente la generalizzazione trasversale di VLA e ne limitano la prontezza per il dispiegamento reale su larga scala.

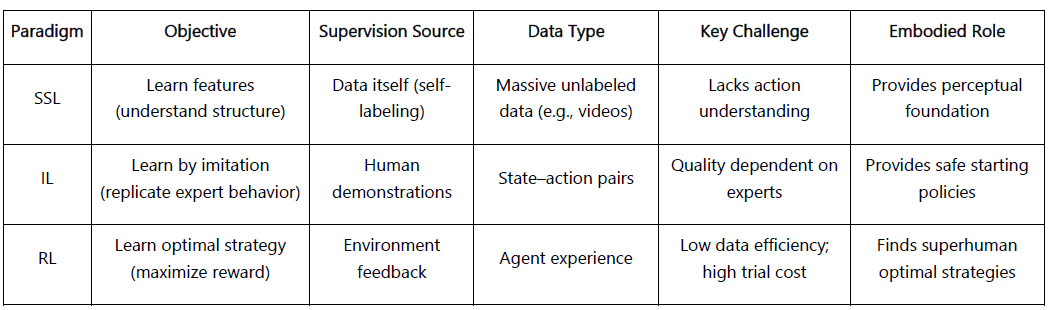

Apprendimento & Adattamento: SSL, IL e RL

Apprendimento Auto-Supervisionato (SSL): Abilita i robot a inferire schemi e leggi fisiche direttamente dai dati di percezione—insegnando loro a "comprendere il mondo."

Apprendimento per Imitazione (IL): Permette ai robot di imitare dimostrazioni umane o di esperti—aiutandoli a "comportarsi come esseri umani."

Apprendimento per Rinforzo (RL): Utilizza loop di feedback di ricompensa-punizione per ottimizzare le politiche—aiutandoli a "imparare attraverso prova e errore."

Nell'AI incarnata, questi paradigmi formano un sistema di apprendimento stratificato: SSL fornisce una base rappresentativa, IL fornisce priorità umane e RL guida l'ottimizzazione delle politiche.

formando congiuntamente il meccanismo centrale dell'apprendimento dalla percezione all'azione.

Sim2Real: Colmare il divario tra Simulazione e Realtà

La Simulazione alla Realtà (Sim2Real) consente ai robot di allenarsi in ambienti virtuali prima del dispiegamento nel mondo reale. Piattaforme come NVIDIA Isaac Sim, Omniverse e DeepMind MuJoCo producono enormi quantità di dati sintetici—riducendo costi e usura sull'hardware.

L'obiettivo è minimizzare il "divario di realtà" attraverso:

Randomizzazione del Dominio: Alterare casualmente illuminazione, attrito e rumore per migliorare la generalizzazione.

Calibrazione Fisica: Utilizzare dati sensoriali reali per regolare la fisica della simulazione per il realismo.

Ritocco Fine Adattivo: Riaddestramento rapido in loco per stabilità in ambienti reali.

Sim2Real forma il ponte centrale per il dispiegamento dell'AI incarnata. Nonostante forti progressi, rimangono sfide riguardo al divario di realtà, ai costi di calcolo e alla sicurezza nel mondo reale. Tuttavia, la Simulazione come Servizio (SimaaS) sta emergendo come un'infrastruttura leggera ma strategica per l'era AI incarnata—tramite modelli di business PaaS (Abbonamento alla Piattaforma), DaaS (Generazione di Dati) e VaaS (Validazione).

Modellazione Cognitiva: Modello del Mondo — Il "Mondo Interiore" del Robot

Un Modello del Mondo serve come il cervello interiore dei robot, consentendo loro di simulare ambienti e risultati internamente—predicendo e ragionando prima di agire. Apprendendo le dinamiche ambientali, consente comportamenti predittivi e proattivi. Progetti rappresentativi: DeepMind Dreamer, Google Gemini + RT-2, Tesla FSD V12, NVIDIA WorldSim.

Le tecniche principali includono:

Modellazione delle Dinamiche Latenti: Compressione di osservazioni ad alta dimensione in stati latenti.

Pianificazione Basata sull'Immaginazione: Prova e errore virtuale per la previsione del percorso.

Apprendimento per Rinforzo Basato su Modello: Sostituzione delle prove nel mondo reale con simulazioni interne.

I Modelli del Mondo segnano la transizione dall'intelligenza reattiva a quella predittiva, sebbene permangano sfide nella complessità del modello, stabilità a lungo termine e standardizzazione.

Intelligenza e Ragionamento di Sciame: Dalla Cognizione Individuale a Quella Collettiva

Collaborazione Multi-Agente e Sistemi di Memoria-Ragionamento rappresentano la prossima frontiera—estendendo l'intelligenza da agenti individuali a collettivi cooperativi e cognitivi.

Sistemi Multi-Agente (MAS): Abilitano la cooperazione distribuita tra più robot tramite framework RL cooperativi (ad es., OpenAI Hide-and-Seek, DeepMind QMIX / MADDPG). Questi si sono dimostrati efficaci nella logistica, nell'ispezione e nel controllo coordinato degli sciami.

Memoria & Ragionamento: Dotare gli agenti di memoria a lungo termine e comprensione causale—cruciali per la generalizzazione cross-task e la pianificazione autonoma. Esempi di ricerca includono DeepMind Gato, Dreamer e Voyager, che abilitano l'apprendimento continuo e il "ricordare il passato, simulare il futuro."

Insieme, questi componenti pongono le basi per robot capaci di apprendimento collettivo, memoria e auto-evoluzione.

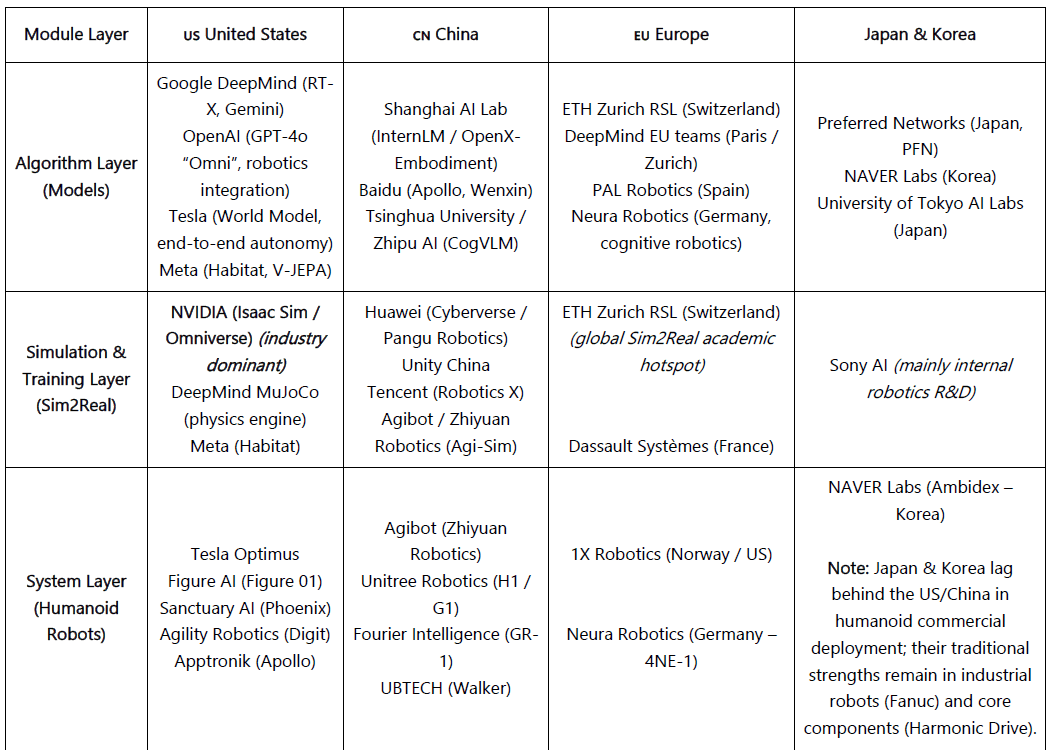

Panorama Globale dell'AI Incarnata: Collaborazione e Competizione

L'industria globale della robotica sta entrando in un'era di competizione cooperativa.

La Cina guida in efficienza della catena di approvvigionamento, produzione e integrazione verticale, con aziende come Unitree e UBTECH che già producono in massa umanoidi. Tuttavia, le sue capacità algoritmiche e di simulazione sono ancora indietro rispetto agli Stati Uniti di diversi anni.

Gli Stati Uniti dominano i modelli e il software AI di frontiera (DeepMind, OpenAI, NVIDIA), eppure questo vantaggio non si estende completamente all'hardware robotico—dove i giocatori cinesi spesso iterano più velocemente e dimostrano prestazioni reali più forti. Questo divario hardware spiega in parte gli sforzi di rimpatrio industriale degli Stati Uniti sotto il CHIPS Act e l'IRA.

Il Giappone rimane il leader globale nei componenti di precisione e nei sistemi di controllo del movimento, sebbene i suoi progressi nella robotica nativa AI siano rimasti conservativi.

La Corea si distingue attraverso l'adozione avanzata della robotica di consumo, guidata da LG, NAVER Labs e un ecosistema di robot di servizio maturo.

L'Europa mantiene una forte cultura ingegneristica, standard di sicurezza e profondità di ricerca; mentre gran parte della produzione si è spostata all'estero, l'Europa continua a eccellere in framework di collaborazione e standardizzazione della robotica.

Insieme, queste forze regionali stanno plasmando l'equilibrio a lungo termine dell'industria globale dell'intelligenza incarnata.

III. Robot × AI × Web3: Visione Narrativa vs. Percorsi Pratici

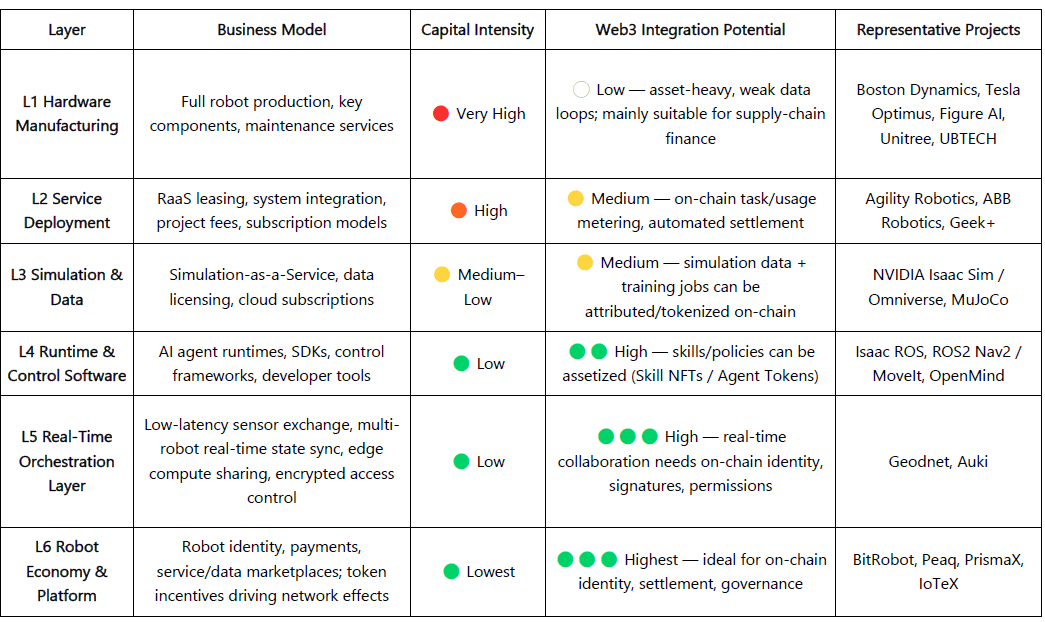

Nel 2025, è emersa una nuova narrativa nel Web3 attorno alla fusione di robotica e AI. Mentre il Web3 è spesso inquadrato come il protocollo di base per un'economia delle macchine decentralizzata, il suo reale valore di integrazione e fattibilità varia notevolmente per strato:

Produzione hardware & layer di servizio: Intensi in capitale con volani di dati deboli; il Web3 attualmente può solo svolgere un ruolo di supporto in casi limite come finanza della catena di approvvigionamento o leasing di attrezzature.

Ecosistema di simulazione & software: Maggiore compatibilità; i dati di simulazione e i lavori di addestramento possono essere messi on-chain per attribuzione, e agenti/moduli di abilità possono essere assetizzati tramite NFT o Token di Agente.

Layer di piattaforma: Reti di lavoro e collaborazione decentralizzate mostrano il maggiore potenziale—il Web3 può unire identità, incentivi e governance per costruire gradualmente un credibile "mercato del lavoro delle macchine," ponendo le basi istituzionali per una futura economia delle macchine.

Visione a lungo termine. Il layer di Orchestrazione e Piattaforma è la direzione più preziosa per integrare Web3 con robotica e AI. Man mano che i robot guadagnano capacità di percezione, linguaggio e apprendimento, stanno evolvendo in attori intelligenti che possono decidere, collaborare e creare valore economico in modo autonomo. Affinché questi "lavoratori intelligenti" partecipino veramente all'economia, devono essere superati quattro ostacoli centrali: identità, fiducia, incentivi e governance.

Identità: Le macchine richiedono identità digitali attribuibili e tracciabili. Con i DID delle macchine, ogni robot, sensore o UAV può coniare una "carta d'identità" unica e verificabile on-chain, legando la proprietà, i registri delle attività e gli ambiti di permesso per consentire interazioni sicure e responsabilità.

Fiducia: Il "lavoro delle macchine" deve essere verificabile, misurabile e quotabile. Utilizzando contratti intelligenti, oracoli e audit—combinati con la Prova di Lavoro Fisico (PoPW), Ambienti di Esecuzione Fidati (TEE) e Prove a Conoscenza Zero (ZKP)—l'esecuzione dei compiti può essere dimostrata autentica e tracciabile, conferendo valore contabile al comportamento delle macchine.

Incentivi: Il Web3 consente liquidazione automatizzata e flusso di valore tra macchine tramite incentivi token, astrazione account e canali di stato. I robot possono utilizzare micropagamenti per affitto di calcolo e condivisione di dati, con staking/slashing per garantire performance; contratti intelligenti e oracoli possono coordinare un mercato di coordinazione delle macchine decentralizzato con un minimo di spedizione umana.

Governance: Man mano che le macchine guadagnano autonomia a lungo termine, il Web3 fornisce governance trasparente e programmabile: le DAO co-decidono i parametri di sistema; multisig e reputazione mantengono sicurezza e ordine. Nel tempo, questo spinge verso la governance algoritmica—gli esseri umani stabiliscono obiettivi e limiti, mentre i contratti mediano gli incentivi e i controlli macchina-a-macchina.

La visione finale del Web3 × Robotica: una rete di valutazione del mondo reale—flotte di robot distribuiti che agiscono come "motori di inferenza del mondo fisico" per testare e confrontare continuamente le prestazioni dei modelli attraverso ambienti complessi e diversificati; e una forza lavoro robotica—robot che eseguono compiti fisici verificabili in tutto il mondo, liquidando guadagni on-chain e reinvestendo valore in aggiornamenti di calcolo o hardware.

Percorso pragmatico oggi. La fusione dell'intelligenza incarnata e del Web3 rimane agli inizi; le economie decentralizzate di intelligenza delle macchine sono per lo più guidate da narrazioni e comunità. Le intersezioni praticabili a breve termine si concentrano in tre aree:

Crowdsourcing di dati & attribuzione — incentivi on-chain e tracciabilità incoraggiano i contributori a caricare dati reali.

Partecipazione globale a lungo termine — micropagamenti transfrontalieri e micro-incentivi riducono il costo della raccolta e distribuzione dei dati.

Finanziarizzazione & innovazione collaborativa — Le strutture DAO possono abilitare l'assetizzazione dei robot, la tokenizzazione dei ricavi e il regolamento macchina-a-macchina.

Complessivamente, l'integrazione della robotica e del Web3 progredirà in fasi: nel breve termine, il focus sarà sulla raccolta di dati e meccanismi di incentivo; nel medio termine, sono attesi progressi nei pagamenti basati su stablecoin, nell'aggregazione di dati a lungo termine e nell'assetizzazione e liquidazione dei modelli RaaS; e nel lungo termine, man mano che gli umanoidi si scalano, il Web3 potrebbe evolversi nella base istituzionale per la proprietà delle macchine, distribuzione dei ricavi e governance, abilitando una vera economia delle macchine decentralizzata.

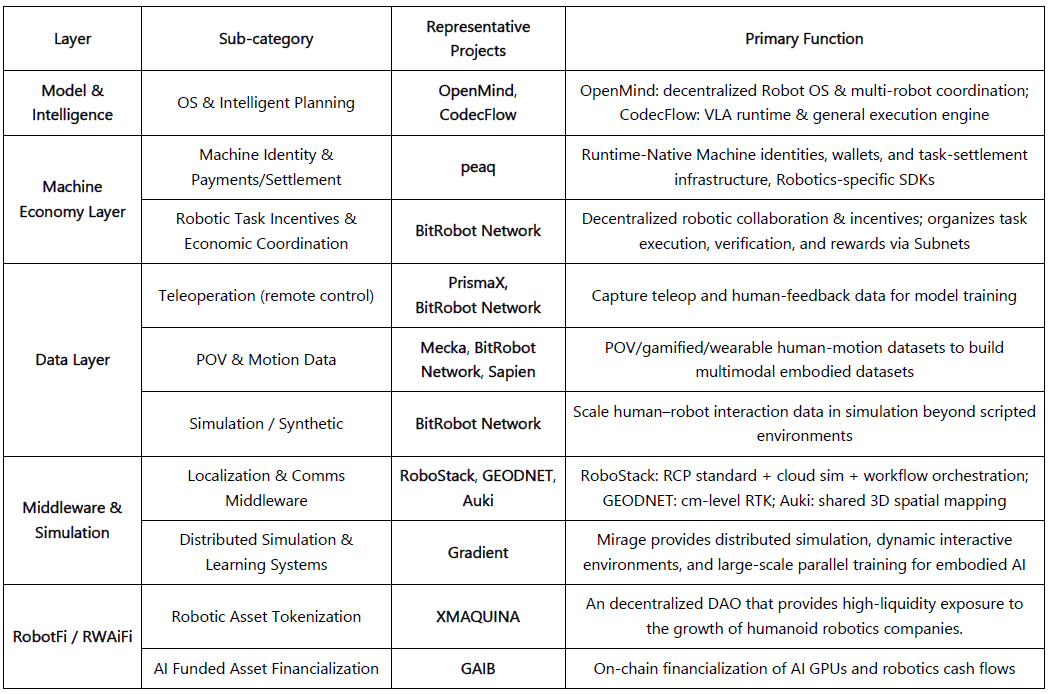

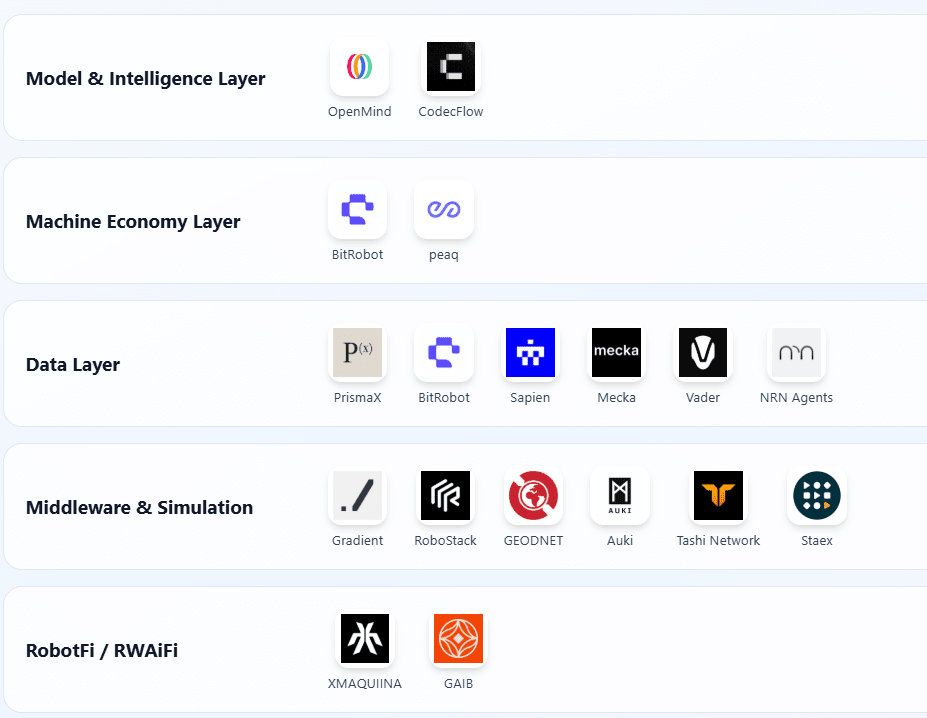

IV. Panorama Robotico Web3 & Casi Curati

Basato su tre criteri—progresso verificabile, apertura tecnica e rilevanza industriale—questa sezione mappa progetti rappresentativi all'intersezione di Web3 × Robotica, organizzati in cinque strati: Modello & Intelligenza, Economia delle Macchine, Raccolta Dati, Percezione & Infrastruttura di Simulazione, e Asset Robotico & Rendimento (RobotFi / RWAiFi). Per rimanere obiettivi, abbiamo rimosso progetti chiaramente guidati dall'hype o insufficientemente documentati; si prega di segnalare eventuali omissioni.

Layer di Modello & Intelligenza

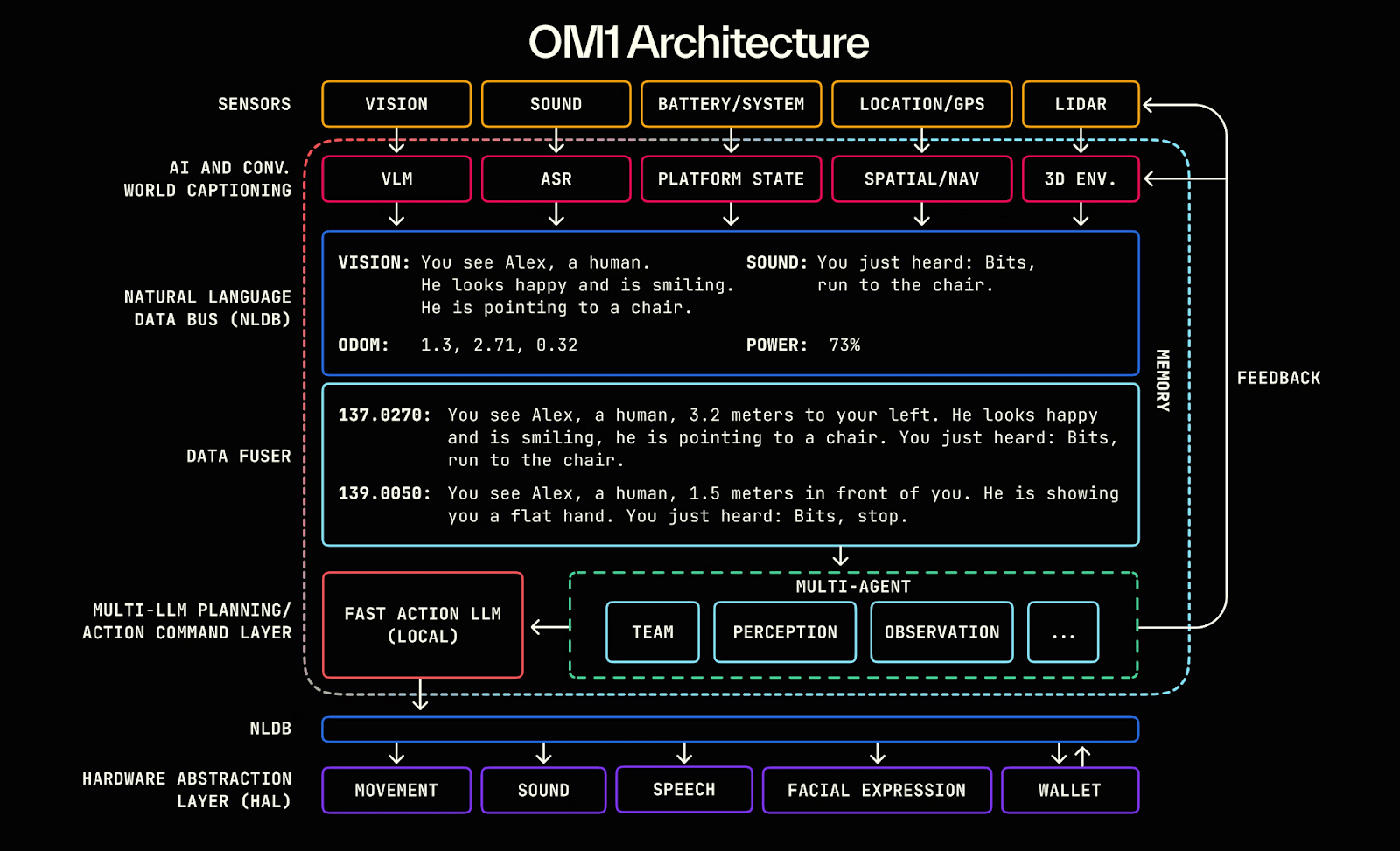

OpenMind — Costruire Android per Robot (https://openmind.org/)

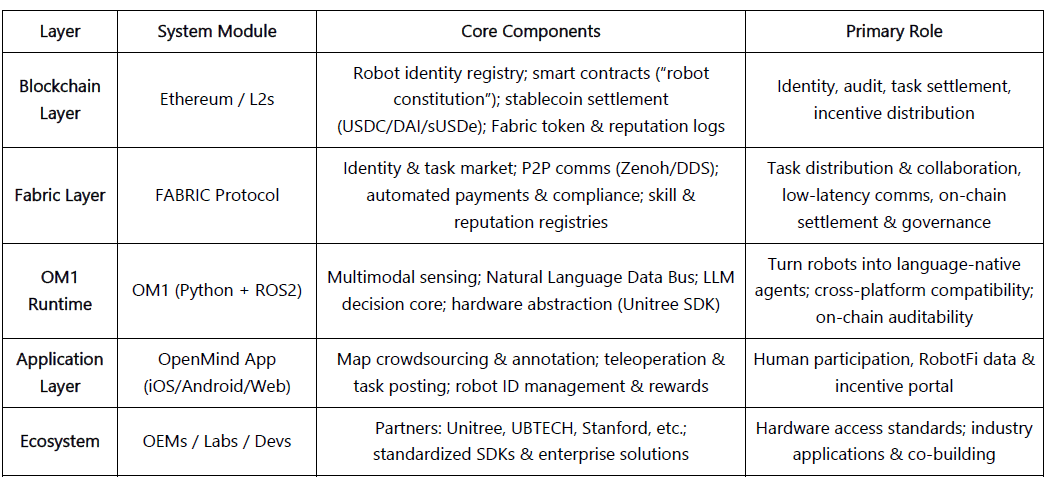

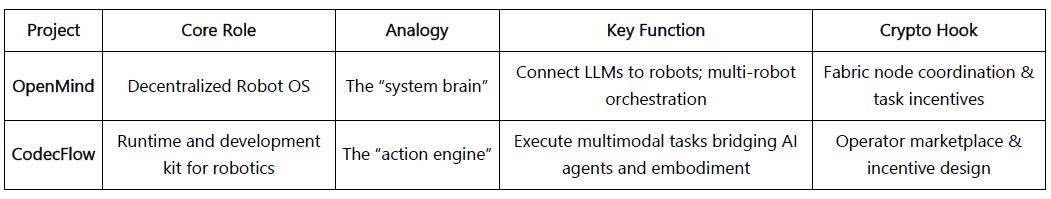

OpenMind è un sistema operativo open-source per Robotica AI incarnata & controllo, mirato a costruire la prima piattaforma di runtime e sviluppo decentralizzata per robot. Due componenti core:

OM1: Un layer runtime modulare e open-source per agenti AI costruito sopra ROS2, che orchestra pipeline di percezione, pianificazione e azione per robot digitali e fisici.

FABRIC: Un layer di coordinazione distribuita che collega calcolo cloud, modelli e robot reali affinché gli sviluppatori possano controllare/addestrare i robot in un ambiente unificato.

OpenMind funge da middleware intelligente tra LLM e il mondo robotico—trasformando l'intelligenza linguistica in intelligenza incarnata e fornendo un'impalcatura dalla comprensione (Linguaggio → Azione) all'allineamento (Blockchain → Regole). Il suo sistema multilivello forma un ciclo di collaborazione completo: gli esseri umani forniscono feedback/etichette tramite l'App OpenMind (dati RLHF); la Rete Fabric gestisce identità, allocazione dei compiti e liquidazione; i robot OM1 eseguono compiti e si conformano a una "costituzione robotica" on-chain per l'audit del comportamento e i pagamenti—completando un ciclo decentralizzato di feedback umano → collaborazione sui compiti → liquidazione on-chain.

Progresso & Valutazione. OpenMind è in una fase iniziale "tecnicamente funzionante, commercialmente non provato". OM1 Runtime è open-source su GitHub con input multimodali e un bus di dati NL per l'analisi linguaggio-azione—originale ma sperimentale. Tessuto e regolamento on-chain sono design a livello di interfaccia finora. I legami dell'ecosistema includono Unitree, UBTECH, TurtleBot e università (Stanford, Oxford, Seoul Robotics) per istruzione/ricerca; nessun lancio industriale finora. L'app è in beta; incentivi/compiti sono all'inizio.

Modello di business: OM1 (open-source) + Fabric (liquidazione) + Skill Marketplace (incentivi). Nessun ricavo finora; si basa su ~$20M di finanziamento iniziale (Pantera, Coinbase Ventures, DCG). Tecnologicamente ambizioso con lungo percorso e dipendenza dall'hardware; se Fabric avrà successo, potrebbe diventare l'"Android dell'AI incarnata."

CodecFlow — Il Motore di Esecuzione per la Robotica (https://codecflow.ai)

CodecFlow è un Layer di Esecuzione decentralizzato per la Robotica su Solana, fornendo ambienti runtime on-demand per agenti AI e sistemi robotici—dando a ciascun agente una "Macchina Istantanea". Tre moduli:

Fabric: Aggregatore di calcolo Cross-cloud e DePIN (Weaver + Shuttle + Gauge) che avvia VM sicure, contenitori GPU o nodi di controllo robotico in pochi secondi.

optr SDK: Un framework Python che astrae connettori hardware, algoritmi di addestramento e integrazione blockchain. Per abilitare la creazione di "Operatori" che controllano desktop, simulatori o robot reali.

Incentivi Token: Incentivi on-chain per i contributori open source, riacquisto dai ricavi e futura economia per il marketplace

Obiettivo: Unificare l'ecosistema robotico frammentato con un unico layer di esecuzione che fornisca ai costruttori astrazione hardware, strumenti di affinamento, infrastruttura di simulazione cloud e economia onchain in modo che possano lanciare e scalare operatori generatori di reddito per robot e desktop.

Progresso & Valutazione. Early Fabric (Go) e optr SDK (Python) sono attivi; web/CLI può avviare istanze di calcolo isolate, integrazione con NRN, ChainLink, peaq. Il Marketplace degli Operatori mira alla fine del 2025, servendo sviluppatori AI, laboratori di robotica e operatori di automazione.

Layer dell'Economia delle Macchine

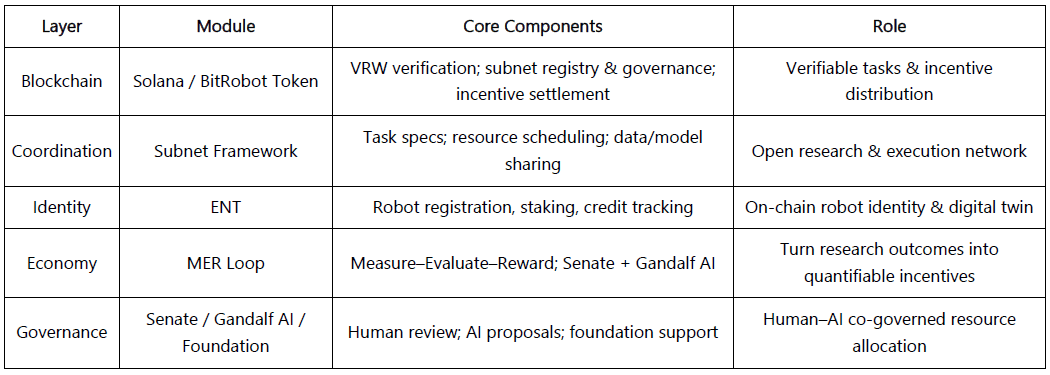

BitRobot — Il Laboratorio di Robotica Aperto al Mondo (https://bitrobot.ai)

Una rete di ricerca e collaborazione decentralizzata per AI incarnata e robotica, co-iniziata da FrodoBots Labs e Protocol Labs. Visione: un'architettura aperta di Subnet + Incentivi + Lavoro Robotico Verificabile (VRW).

VRW: Definire & verificare il reale contributo di ciascun compito robotico.

ENT (Token del Nodo Incarnato): Identità robotica on-chain & responsabilità economica.

Subnet: Organizzare la collaborazione interregionale attraverso ricerca, calcolo, dispositivi e operatori.

Senato + Gandalf AI: Co-governance Umano-AI per incentivi e allocazione della ricerca.

Dal suo whitepaper del 2025, BitRobot ha eseguito più subnet (ad es., SN/01 ET Fugi, SN/05 SeeSaw di Virtuals), abilitando la teleoperazione decentralizzata e la cattura di dati reali, e ha lanciato un fondo da $5M per le Grandi Sfide per stimolare la ricerca globale nello sviluppo di modelli.

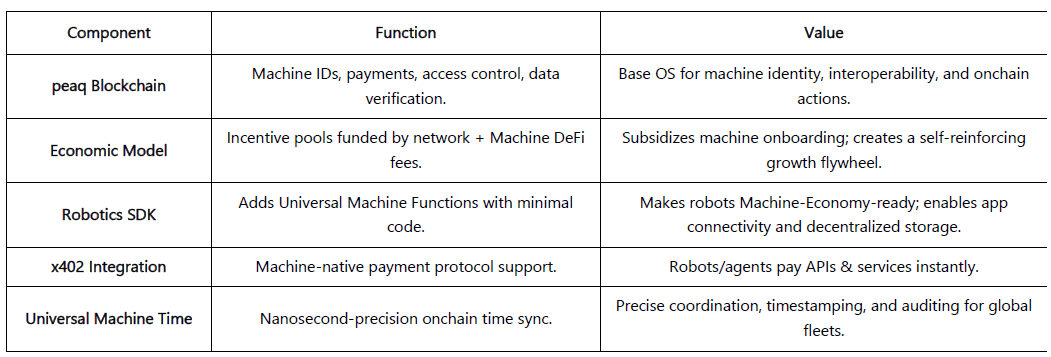

peaq — Il Computer dell'Economia delle Macchine (https://www.peaq.xyz/)

peaq è una catena Layer-1 costruita per l'Economia delle Macchine, fornendo identità delle macchine, portafogli, controllo degli accessi e sincronizzazione temporale (Tempo Universale delle Macchine) per milioni di robot e dispositivi. Il suo SDK per la Robotica consente ai costruttori di rendere i robot "pronti per l'Economia delle Macchine" con solo poche righe di codice, abilitando interoperabilità neutrale rispetto ai fornitori e interazione peer-to-peer.

La rete ospita già la prima fattoria robotica tokenizzata al mondo e oltre 60 applicazioni di macchine nel mondo reale. Il framework di tokenizzazione di peaq consente alle aziende robotiche di raccogliere liquidità per hardware ad alta intensità di capitale e ampliare la partecipazione al di là dei tradizionali acquirenti B2B/B2C. I suoi pool di incentivi a livello di protocollo, finanziati da commissioni di rete, sovvenzionano l'onboarding delle macchine e supportano i costruttori—creando un volano di crescita per i progetti robotici.

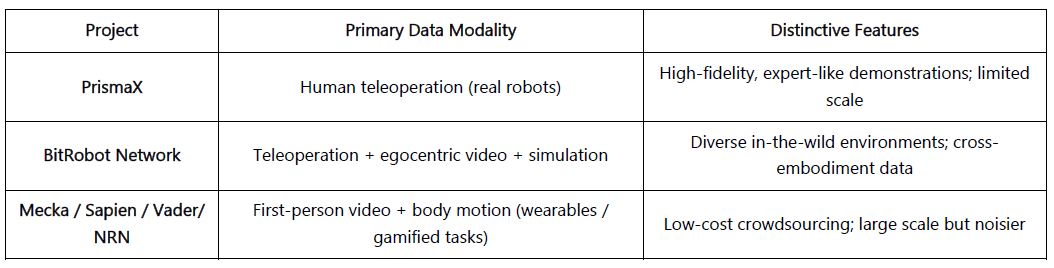

Layer di Dati

Scopo: sbloccare dati reali scarsi e costosi per l'addestramento incarnato tramite teleoperazione (PrismaX, BitRobot Network), cattura in prima persona & movimento (Mecka, BitRobot Network, Sapien, Vader, NRN) e pipeline di simulazione/sintetiche (BitRobot Network) per costruire corpora di addestramento scalabili e generalizzabili.

Nota: Web3 non produce dati migliori rispetto ai giganti del Web2; il suo valore risiede nella ridistribuzione dell'economia dei dati. Con ferrovie per stablecoin + crowdsourcing, incentivi senza permesso e attribuzione on-chain abilitano micro-regolamenti a basso costo, provenienza e condivisione automatica dei ricavi. Il crowdsourcing aperto deve ancora affrontare problemi di controllo qualità e lacune nella domanda degli acquirenti.

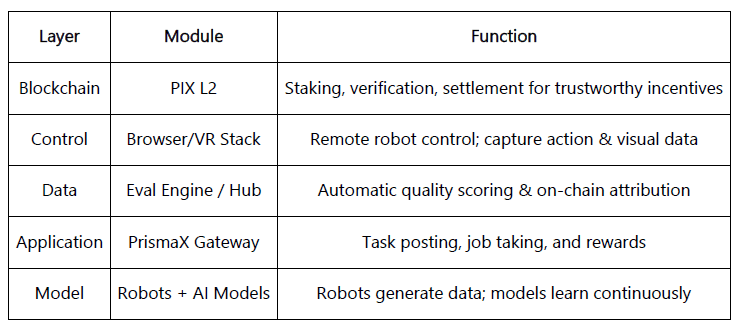

PrismaX (https://gateway.prismax.ai)

Un'economia decentralizzata di teleoperazione & dati per l'AI incarnata—mirando a costruire un mercato globale del lavoro robotico dove operatori umani, robot e modelli AI co-evolvono tramite incentivi on-chain.

Stack di Teleoperazione: Interfaccia Browser/VR + SDK collega braccia robotiche/robot di servizio globali per controllo in tempo reale & cattura dati.

Eval Engine: CLIP + DINOv2 + scoring semantico con flusso ottico per valutare ogni traiettoria e liquidare on-chain.

Completa il ciclo teleoperazione → cattura dati → addestramento modello → liquidazione on-chain, trasformando il lavoro umano in asset di dati.

Progresso & Valutazione. Testnet attivo da agosto 2025 (gateway.prismax.ai). Gli utenti possono teleoperare braccia per compiti di presa e generare dati di addestramento. Eval Engine in esecuzione interna. Posizionamento chiaro e alta completezza tecnica; forte candidato per un protocollo decentralizzato di lavoro e dati per l'era incarnata, ma la scala a breve termine rimane una sfida.

BitRobot Network (https://bitrobot.ai/)

Le subnet di BitRobot Network alimentano la raccolta di dati attraverso video, teleoperazione e simulazione. Con SN/01 ET Fugi gli utenti controllano da remoto i robot per completare compiti, raccogliendo dati di navigazione & percezione in un "gioco Pokemon Go nel mondo reale". Il gioco ha portato alla creazione di FrodoBots-2K, uno dei più grandi set di dati di navigazione uomo-robot aperti, utilizzato da UC Berkeley RAIL e Google DeepMind. SN/05 SeeSaw crowdsources dati video egocentrici tramite iPhone da ambienti reali su larga scala. Altre subnet annunciate RoboCap e Rayvo si concentrano sulla raccolta di dati video egocentrici tramite incarnazioni a basso costo.

Mecka (https://www.mecka.ai)

Mecka è un'azienda di dati robotici che crowdsources video egocentrici, movimento e dimostrazioni di compiti—tramite cattura mobile gamificata e apparecchiature hardware personalizzate—per costruire set di dati multimodali su larga scala per l'addestramento dell'AI incarnata.

Sapien (https://www.sapien.io/)

Una piattaforma di crowdsourcing per dati di movimento umano per alimentare l'intelligenza robotica. Tramite dispositivi indossabili e app mobili, Sapien raccoglie dati sulla postura e sull'interazione umana per addestrare modelli incarnati—costruendo una rete globale di dati di movimento.

Vader (https://www.vaderai.ai)

Vader crowdsources video egocentrici e dimostrazioni di compiti attraverso EgoPlay, un MMO reale dove gli utenti registrano attività quotidiane da una prospettiva in prima persona e guadagnano $VADER. Il suo pipeline ORN converte il materiale grezzo POV in set di dati strutturati e sicuri per la privacy arricchiti con etichette di azione e narrazioni semantiche—ottimizzati per l'addestramento delle politiche umanoidi.

Agenti NRN (https://www.nrnagents.ai/)

Una piattaforma di dati gamificata incarnata-RL che crowdsources dimostrazioni umane attraverso il controllo robotico basato su browser e competizioni simulate. NRN genera traiettorie comportamentali a lungo termine per l'apprendimento per imitazione e RL continuo, utilizzando compiti simili a sport come dati primitivi scalabili per l'allenamento delle politiche sim-to-real.

Raccolta di Dati Incarnati — Confronto dei Progetti

Middleware & Simulazione

Il layer Middleware & Simulazione forma la spina dorsale tra la rilevazione fisica e la decisione intelligente, coprendo localizzazione, comunicazione, mappatura spaziale e simulazione su larga scala. Il campo è ancora agli inizi: i progetti stanno esplorando il posizionamento ad alta precisione, il computing spaziale condiviso, la standardizzazione dei protocolli e la simulazione distribuita, ma non è ancora emerso alcuno standard unificato o ecosistema interoperabile.

Middleware & Infrastruttura Spaziale

Le capacità robotiche core—navigazione, localizzazione, connettività e mappatura spaziale—formano il ponte tra il mondo fisico e la decisione intelligente. Mentre progetti DePIN più ampi (Silencio, WeatherXM, DIMO) ora menzionano "robotica," i progetti di seguito sono quelli più direttamente rilevanti per l'AI incarnata.

RoboStack — Stack Operativo Robotico Cloud-Nativo (https://robostack.io)

Sistemi operativi e di controllo robotici cloud-nativi che integrano ROS2, DDS, e computazione edge. Il suo RCP (Protocollo di Controllo Robotico) mira a rendere i robot chiamabili/orchestrabili come servizi cloud.GEODNET — Rete GNSS Decentralizzata (https://geodnet.com)

Una rete di posizionamento satellitare decentralizzata globale che offre cm-level RTK/GNSS. Con stazioni di base distribuite e incentivi on-chain, fornisce posizionamento ad alta precisione per droni, guida autonoma e robot—diventando il Layer Geo-Infrastruttura dell'economia delle macchine.Auki — Posemesh per il Computing Spaziale (https://www.auki.com)

Una rete decentralizzata di Posemesh che genera mappe 3D condivise in tempo reale tramite sensori e calcolo crowdsourced, abilitando AR, navigazione robotica e collaborazione multi-dispositivo—infra chiave che fonde AR × Robotica.Rete Tashi — Coordinamento Mesh in Tempo Reale per Robot (https://tashi.network)

Una rete mesh decentralizzata che consente consenso sotto i 30 ms, scambio di sensori a bassa latenza e sincronizzazione dello stato multi-robot. Il suo SDK MeshNet supporta SLAM condiviso, coordinamento di sciami e aggiornamenti di mappe robusti per AI incarnata in tempo reale.Staex — Connettività Decentralizzata & Telemetria (https://www.staex.io)

Uno strato di connettività e gestione dei dispositivi decentralizzato di Deutsche Telekom R&D, fornendo comunicazione sicura, telemetria fidata e routing dispositivo-cloud. Staex consente alle flotte di robot di scambiare dati in modo affidabile e interoperare tra operatori.

Simulazione Distribuita & Sistemi di Apprendimento

Gradient – Verso un'Intelligenza Aperta(https://gradient.network/)

Gradient è un laboratorio di R&D AI dedicato alla costruzione di Intelligenza Aperta, abilitando addestramento distribuito, inferenza, verifica e simulazione su un'infrastruttura decentralizzata. Il suo attuale stack tecnologico include Parallax (inferenza distribuita), Echo (apprendimento per rinforzo distribuito e addestramento multi-agente) e Gradient Cloud (soluzioni AI per imprese).

Nella robotica, Gradient sta sviluppando Mirage — una piattaforma di simulazione distribuita e apprendimento robotico progettata per costruire modelli di mondo generalizzabili e politiche universali, supportando ambienti interattivi dinamici e addestramento parallelo su larga scala. Mirage è previsto rilasciare il suo framework e modello a breve, e il team è stato in discussioni con NVIDIA riguardo a possibili collaborazioni.

Asset Robotico & Rendimento (RobotFi / RWAiFi)

Questo layer converte i robot da strumenti produttivi in asset finanziabili attraverso la tokenizzazione, la distribuzione dei ricavi e la governance decentralizzata, formando l'infrastruttura finanziaria dell'economia delle macchine.

XmaquinaDAO — AI Fisica DAO (https://www.xmaquina.io)

XMAQUINA è un ecosistema decentralizzato che fornisce esposizione globale e liquida a società leader nella robotica umanoide e nell'AI incarnata—portando opportunità tradizionalmente riservate al VC onchain. Il suo token DEUS funge da indice liquido e asset di governance, coordinando le allocazioni di tesoreria e la crescita dell'ecosistema. Il DAO Portal e il Machine Economy Launchpad consentono alla comunità di co-proprietare e supportare le nuove iniziative di AI Fisica attraverso asset di macchine tokenizzati e partecipazione strutturata onchain.

GAIB — Il Layer Economico per l'Infrastruttura AI (https://gaib.ai/)

GAIB fornisce un Layer Economico unificato per le infrastrutture AI nel mondo reale come GPU e robot, connettendo il capitale decentralizzato ad asset produttivi di infra AI e rendendo i rendimenti verificabili, componibili e on-chain.

Per la robotica, GAIB non "vende token robot". Invece, finanzia l'equipaggiamento robotico e i contratti operativi (RaaS, raccolta dati, teleoperazione) on-chain—convertendo flussi di cassa reali → asset di rendimento on-chain componibili. Questo include finanziamenti per attrezzature (leasing/pegno), flussi di cassa operativi (RaaS/servizi dati) e diritti sui dati (licenze/contratti), rendendo gli asset robotici e il loro reddito misurabili, quotabili e commerciabili.

GAIB utilizza AID / sAID come portatori di liquidazione/rendimento, sostenuti da controlli di rischio strutturati (sovra-collateralizzazione, riserve, assicurazione). Nel tempo si integra con derivati DeFi e mercati di liquidità per chiudere il ciclo da "asset robotici" a "asset di rendimento componibili." L'obiettivo: diventare la spina dorsale economica dell'intelligenza nell'era AI.

Collegamento Web3 Robotics Stack: https://fairy-build-97286531.figma.site/

V. Conclusione: Sfide Presenti e Opportunità a Lungo Termine

Da una prospettiva a lungo termine, la fusione di Robotica × AI × Web3 mira a costruire un'economia delle macchine decentralizzata (DeRobot Economy), spostando l'intelligenza incarnata da "automazione di singole macchine" a collaborazione in rete che è possedibile, liquidabile e governabile. La logica centrale è un ciclo di auto-rinforzo—"Token → Deployment → Data → Redistribuzione del Valore"—attraverso il quale robot, sensori e nodi di calcolo ottengono proprietà on-chain, transazioni e condividono i proventi.

Detto ciò, a questo stadio, questo paradigma rimane un'esplorazione in fase iniziale, ancora lontano da flussi di cassa stabili e un volano commerciale scalato. Molti progetti sono guidati dalla narrativa con un dispiegamento reale limitato. La produzione e le operazioni robotiche sono intensive in capitale; gli incentivi token da soli non possono finanziare l'espansione delle infrastrutture. Anche se la finanza on-chain è componibile, non ha ancora risolto la valutazione del rischio degli asset reali e la realizzazione dei flussi di cassa. In breve, la "rete di macchine autosostenibili" rimane idealizzata, e il suo modello di business richiede una validazione nel mondo reale.

Layer di Modello & Intelligenza. Questa è la direzione a lungo termine più preziosa. I sistemi operativi per robot open-source rappresentati da OpenMind cercano di rompere ecosistemi chiusi e unificare il coordinamento multi-robot con interfacce linguaggio-azione. La visione tecnica è chiara e sistematicamente completa, ma il carico ingegneristico è massiccio, i cicli di validazione sono lunghi e il feedback positivo a livello industriale deve ancora formarsi.

Layer dell'Economia delle Macchine. Ancora pre-mercato: la base robotica reale è piccola e l'identità basata su DID più le reti di incentivi faticano a formare un ciclo auto-consistente. Siamo ancora lontani da una vera "economia del lavoro delle macchine." Solo dopo che i sistemi incarnati saranno dispiegati su larga scala, gli effetti economici dell'identità on-chain, della liquidazione e delle reti di collaborazione diventeranno evidenti.

Layer di Dati. Le barriere sono relativamente più basse—ed è questo il più vicino alla viabilità commerciale oggi. La raccolta di dati incarnati richiede continuità spaziotemporale e alta precisione nelle semantiche delle azioni, che determinano qualità e riutilizzabilità. Bilanciare la scala del crowd con l'affidabilità dei dati è la sfida centrale. PrismaX offre un modello parzialmente replicabile bloccando prima la domanda B-side e poi distribuendo compiti di cattura/validazione, ma la scala dell'ecosistema e i mercati dei dati richiederanno tempo per maturare.

Layer di Middleware & Simulazione. Ancora in validazione tecnica senza standard unificati e limitata interoperabilità. Le uscite di simulazione sono difficili da standardizzare per il trasferimento nel mondo reale; l'efficienza Sim2Real rimane vincolata.

Layer RobotFi / RWAiFi. Il ruolo del Web3 è principalmente ausiliario—migliorando la trasparenza, la liquidazione e l'efficienza di finanziamento nella finanza della catena di approvvigionamento, nel leasing di attrezzature e nella governance degli investimenti, piuttosto che ridefinire l'economia robotica stessa.

Detto ciò, crediamo che l'intersezione tra Robotica × AI × Web3 segni il punto di partenza del prossimo sistema economico intelligente. Non è solo una fusione di paradigmi tecnici; è anche un'opportunità per ridefinire le relazioni di produzione. Una volta che le macchine possiedono identità, incentivi e governance, la collaborazione uomo-macchina può evolvere da automazione localizzata a autonomia in rete. A breve termine, questo dominio rimarrà guidato da narrazioni e sperimentazioni, ma i framework istituzionali e gli incentivi emergenti stanno ponendo le basi per l'ordine economico di una futura società di macchine. A lungo termine, combinare intelligenza incarnata con il Web3 ridisegnerà i confini della creazione di valore—elevando agenti intelligenti in attori economici possibili, collaborativi e portatori di reddito.

Disclaimer: Questo articolo è stato assistito da strumenti AI (ChatGPT-5 e Deepseek). L'autore ha cercato di correggere e garantire l'accuratezza, ma potrebbero rimanere errori. Nota che i mercati degli asset crypto mostrano spesso divergenza tra fondamentali di progetto e azione del prezzo nel mercato secondario. Questo contenuto è solo per sintesi informativa e scambio accademico/di ricerca e non costituisce consulenza agli investimenti o raccomandazione per acquistare o vendere alcun token.