作者:0xjacobzhao | https://linktr.ee/0xjacobzhao

Ten niezależny raport badawczy został wsparty przez IOSG Ventures, dziękujemy Hansowi (RoboCup Asia-Pacific), Nichanan Kesonpat (1kx), Robertowi Koschigowi (1kx), Amandzie Young (Collab+Currency), Jonathanowi Victorowi (Ansa Research), Lexowi Sokolinowi (Generative Ventures), Jayowi Yu (Pantera Capital), Jeffrey'emu Hu (Hashkey Capital) za cenne sugestie dotyczące tego dokumentu. W trakcie pisania konsultowano się również z projektami OpenMind, BitRobot, peaq, Auki Labs, XMAQUINA, GAIB, Vader, Gradient, Tashi Network i CodecFlow. Dokument stara się być obiektywny i dokładny, ale niektóre opinie mogą zawierać subiektywne osądy, co może prowadzić do pewnych odchyleń, prosimy czytelników o zrozumienie.

I. Panoramiczny widok robotyki: od automatyki przemysłowej do inteligencji humanoidalnej

Tradycyjny łańcuch dostaw w branży robotyki utworzył kompletny, oddolny, warstwowy system, obejmujący cztery główne segmenty: komponenty podstawowe, pośrednie systemy sterowania, kompletną produkcję maszyn oraz integrację aplikacji. Komponenty podstawowe (sterowniki, serwomechanizmy, reduktory, czujniki, akumulatory itp.) napotykają największe bariery technologiczne, wyznaczając dolną granicę ogólnej wydajności i kosztów maszyny. System sterowania to „mózg i móżdżek” robota, odpowiedzialny za podejmowanie decyzji, planowanie i sterowanie ruchem. Kompletna produkcja maszyn odzwierciedla możliwości integracji łańcucha dostaw. Integracja systemów i aplikacji, decydujące o głębokości komercjalizacji, stają się nową podstawową wartością.

Na podstawie scenariuszy zastosowań i form, roboty globalne ewoluują zgodnie ze ścieżką „automatyzacja przemysłowa → inteligencja oparta na scenariuszach → inteligencja ogólnego przeznaczenia”, dzieląc się na pięć głównych typów: roboty przemysłowe, roboty mobilne, roboty usługowe, roboty specjalistyczne i roboty humanoidalne.

Roboty przemysłowe: Obecnie jedyny w pełni rozwinięty sektor, szeroko stosowany w procesach produkcyjnych, takich jak spawanie, montaż, lakierowanie i transport materiałów. Branża stworzyła ustandaryzowany system łańcucha dostaw ze stabilnymi marżami brutto i wyraźnym zwrotem z inwestycji (ROI). Podkategoria robotów współpracujących (coboty) kładzie nacisk na współpracę człowieka z robotem, lekką konstrukcję i łatwość wdrożenia, i odnotowuje najszybszy wzrost. Do reprezentatywnych firm należą: ABB, Fanuc, Yaskawa Electric, KUKA, Universal Robots, JAKA i AUBO.

Roboty mobilne, w tym AGV (automatycznie sterowane pojazdy) i AMR (autonomiczne roboty mobilne), są szeroko stosowane w logistyce, magazynowaniu, dostawach e-commerce i transporcie produkcyjnym, stając się najbardziej dojrzałą kategorią na rynku B2B. Reprezentatywne firmy to Amazon Robotics, Geek+, Quicktron i Locus Robotics.

Roboty usługowe: Skierowane do branż takich jak sprzątanie, gastronomia, hotelarstwo i edukacja, to najszybciej rozwijający się sektor konsumencki. Produkty czyszczące weszły na rynek elektroniki użytkowej, a sektor medyczny i dostaw komercyjnych przyspieszają komercjalizację. Ponadto pojawia się szereg manipulatorów o bardziej uniwersalnym zastosowaniu (takich jak system dwuramienny Dyna) – bardziej elastycznych niż produkty dedykowane konkretnym zadaniom, ale wciąż nieosiągających wszechstronności robotów humanoidalnych. Reprezentatywne firmy to: Ecovacs, Roborock, Pudu Technology, Keenon Robotics, iRobot i Dyna.

Roboty specjalistyczne służą głównie do zastosowań medycznych, wojskowych, budowlanych, morskich i lotniczych. Chociaż wielkość rynku jest ograniczona, marże zysku są wysokie, a bariery wejścia silne. Roboty te w dużej mierze opierają się na zamówieniach rządowych i korporacyjnych i znajdują się w fazie pionowego wzrostu. Typowe projekty obejmują Intuitive Surgical, Boston Dynamics, ANYbotics i NASA Valkyrie.

Roboty humanoidalne są uważane za przyszłą „uniwersalną platformę siły roboczej”. Do reprezentatywnych firm należą Tesla (Optimus), Figure AI (Figure 01), Sanctuary AI (Phoenix), Agility Robotics (Digit), Apptronik (Apollo), 1X Robotics, Neura Robotics, Unitree Robotics, UBTECH i Logic Robotics.

Roboty humanoidalne są obecnie najchętniej obserwowanym, nowatorskim obszarem badań. Ich fundamentalna wartość tkwi w humanoidalnej strukturze, która pozwala im adaptować się do istniejących przestrzeni społecznych, i są postrzegane jako kluczowy element w dążeniu do stworzenia „uniwersalnej platformy pracy”. W przeciwieństwie do robotów przemysłowych, które dążą do maksymalnej wydajności, roboty humanoidalne kładą nacisk na ogólną adaptowalność i zdolność do transferu zadań, co pozwala im wchodzić do fabryk, domów i przestrzeni publicznych bez modyfikowania otoczenia.

Obecnie większość robotów humanoidalnych pozostaje w fazie demonstracji technologii, głównie weryfikując dynamiczną równowagę, chodzenie i możliwości manipulacyjne. Chociaż niektóre projekty rozpoczęły wdrożenia na małą skalę w ściśle kontrolowanych warunkach fabrycznych (takich jak Figure × BMW i Agility Digit), a oczekuje się, że większa liczba producentów (np. 1X) rozpocznie wczesną dystrybucję od 2026 roku, są to nadal ograniczone zastosowania „wąskich scenariuszy i pojedynczych zadań”, a nie rzeczywiste wdrożenie do pracy w warunkach ogólnego przeznaczenia. Ogólnie rzecz biorąc, komercjalizacja na dużą skalę jest nadal odległa o kilka lat. Główne wąskie gardła obejmują: wyzwania związane ze sterowaniem, takie jak koordynacja wielostopniowa i dynamiczna równowaga w czasie rzeczywistym; problemy z zużyciem energii i zasięgiem ograniczone gęstością energii akumulatora i sprawnością napędu; powiązania percepcja-decyzja, podatne na niestabilność i trudne do uogólnienia w otwartych środowiskach; znaczne luki w danych (utrudniające wsparcie szkoleń w zakresie polityki ogólnego przeznaczenia); migracja między ciałami nie została jeszcze pokonana; a łańcuch dostaw sprzętu i krzywa kosztów (szczególnie poza Chinami) nadal stanowią realne bariery, co jeszcze bardziej utrudnia osiągnięcie wdrożeń na dużą skalę przy niskich kosztach.

Oczekuje się, że przyszła ścieżka komercjalizacji będzie przebiegać przez trzy etapy: w perspektywie krótkoterminowej będzie koncentrować się głównie na modelu Demo-as-a-Service, opierając się na projektach pilotażowych i dotacjach; w perspektywie średnioterminowej ewoluuje w kierunku modelu Robotics-as-a-Service (RaaS), budując ekosystem zadań i umiejętności; a w perspektywie długoterminowej będzie koncentrować się na chmurze obliczeniowej dla pracowników i inteligentnych usługach subskrypcyjnych, przenosząc wartość z produkcji sprzętu na oprogramowanie i sieci usług. Ogólnie rzecz biorąc, roboty humanoidalne znajdują się w krytycznym okresie przejściowym od demonstracji do samouczenia się. To, czy uda im się pokonać trzy przeszkody: kontrolę, koszty i algorytmy, zadecyduje o tym, czy będą w stanie rzeczywiście osiągnąć ucieleśnioną inteligencję.

II. AI × Roboty: Świt ery ucieleśnionej inteligencji

Tradycyjna automatyzacja opiera się głównie na programowaniu wstępnym i sterowaniu potokowym (takim jak architektura DSOP percepcji-planowania-sterowania), które może działać niezawodnie tylko w ustrukturyzowanych środowiskach. Rzeczywistość jest jednak znacznie bardziej złożona i dynamiczna. Następna generacja ucieleśnionej sztucznej inteligencji (SI) przyjmuje inny paradygmat: dzięki dużym modelom i uczeniu się zunifikowanej reprezentacji, umożliwia robotom „rozumienie, przewidywanie i działanie” w różnych scenariuszach. Ucieleśniona SI kładzie nacisk na dynamiczne sprzężenie ciała (sprzętu), mózgu (modelu) i środowiska (interakcji); robot jest nośnikiem, a inteligencja jest rdzeniem.

Sztuczna inteligencja generatywna należy do dziedziny inteligencji opartej na języku, doskonale rozumiejąc symbole i semantykę; ucieleśniona sztuczna inteligencja należy do dziedziny świata realnego, opanowując percepcję i działanie. Te dwa elementy odpowiadają odpowiednio „mózgowi” i „ciele”, reprezentując dwie równoległe linie ewolucji sztucznej inteligencji. Z perspektywy hierarchii inteligencji, ucieleśniona sztuczna inteligencja stoi wyżej niż sztuczna inteligencja generatywna, ale jej dojrzałość wciąż znacznie odstaje. LLM (Limited Learning Machines) opiera się na ogromnych ilościach danych językowych dostępnych w internecie, tworząc wyraźną zamkniętą pętlę „dane → moc obliczeniowa → wdrożenie”; podczas gdy inteligencja robotyczna wymaga danych pierwszoosobowych, multimodalnych i powiązanych z działaniem – w tym trajektorii zdalnego sterowania, wideo pierwszoosobowego, map przestrzennych i sekwencji operacyjnych. Dane te nie występują naturalnie i muszą być generowane poprzez rzeczywistą interakcję lub symulację o wysokiej wierności, co czyni je znacznie rzadszymi i droższymi. Chociaż dane symulowane i syntetyczne są pomocne, nie mogą zastąpić rzeczywistych czujników – wrażeń ruchowych. Właśnie dlatego firmy takie jak Tesla i Figure muszą budować własne, zdalnie sterowane fabryki danych, a w Azji Południowo-Wschodniej powstały zewnętrzne fabryki adnotacji danych. Krótko mówiąc: LLM uczy się na podstawie istniejących danych, podczas gdy roboty muszą je „tworzyć” poprzez interakcję ze światem fizycznym. W ciągu najbliższych 5–10 lat oba systemy zostaną głęboko zintegrowane w modelu Wizja–Język–Działanie oraz architekturze Ucieleśnionego Agenta – LLM będzie odpowiedzialny za zaawansowane procesy poznawcze i planowanie, a robot za realizację zadań w świecie rzeczywistym, tworząc dwukierunkową, zamkniętą pętlę danych i działań oraz wspólnie rozwijając sztuczną inteligencję od „inteligencji językowej” do prawdziwej inteligencji ogólnej (AGI).

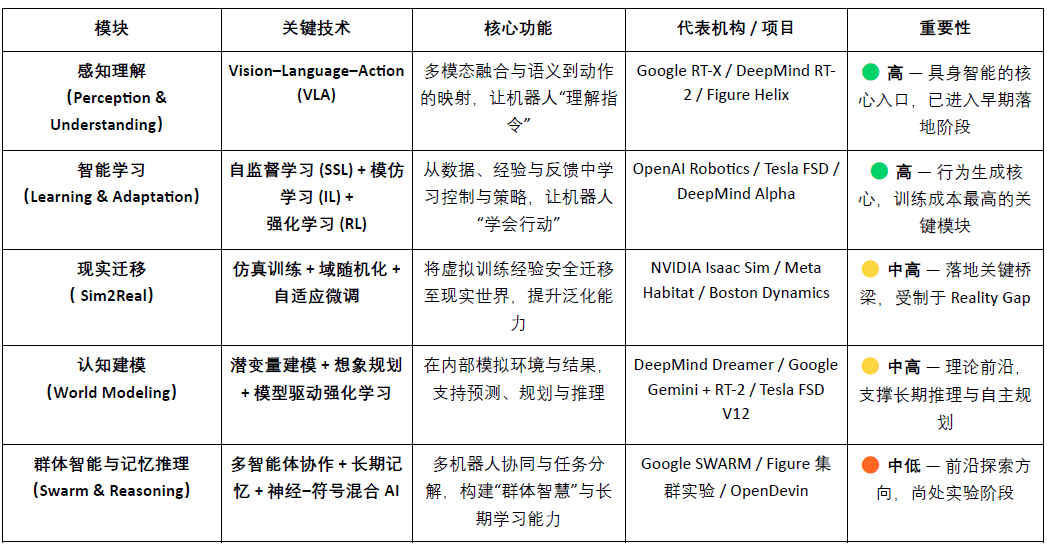

Podstawowy system technologiczny inteligencji ucieleśnionej można postrzegać jako oddolny stos inteligencji: VLA (fuzja percepcyjna), RL/IL/SSL (inteligentne uczenie się), Sim2Real (transfer rzeczywistości), World Model (modelowanie poznawcze) oraz Swarm & Reasoning (współpraca wieloagentowa i rozumowanie pamięciowe). Spośród nich VLA i RL/IL/SSL to „silniki” inteligencji ucieleśnionej, determinujące jej wdrożenie i komercjalizację; Sim2Real i World Model to kluczowe technologie łączące wirtualne szkolenia z rzeczywistymi działaniami; a Swarm & Reasoning reprezentują wyższy poziom ewolucji grupowej i metapoznawczej.

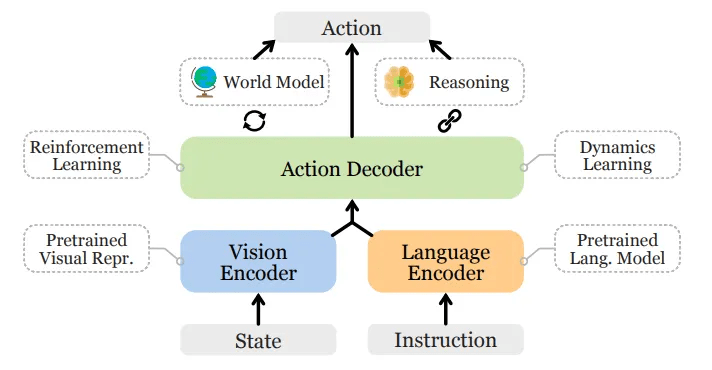

Rozumienie percepcyjne: model Wizja-Język-Działanie

Model VLA integruje trzy kanały – wizję, język i działanie – umożliwiając robotom rozumienie intencji płynących z języka ludzkiego i przekładanie ich na konkretne działania. Jego proces realizacji obejmuje analizę semantyczną, rozpoznawanie celów (lokalizowanie obiektów docelowych na podstawie bodźców wizualnych) oraz planowanie ścieżki i wykonywanie działań, tworząc w ten sposób zamkniętą pętlę „rozumienia semantyki – postrzegania świata – realizacji zadania”, co stanowi kluczowy przełom w dziedzinie ucieleśnionej inteligencji. Obecnie realizowane projekty obejmują Google RT-X, Meta Ego-Exo i Figure Helix, prezentujące przełomowe kierunki rozwoju, takie jak rozumienie międzymodalne, percepcja immersyjna i sterowanie oparte na języku.

Ogólna architektura modelu Wizja-Język-Działanie

Obecnie VLA znajduje się dopiero na wczesnym etapie rozwoju i zmaga się z czterema głównymi wąskimi gardłami:

1) Niejednoznaczność semantyczna i słaba generalizacja zadań: Model ma trudności ze zrozumieniem niejednoznacznych i otwartych instrukcji;

2) Niestabilna zgodność między wizją a działaniem: Błędy percepcyjne są wzmacniane podczas planowania i wykonywania ścieżki;

3) Dane multimodalne są rzadkie i brakuje im standardowych specyfikacji: wysokie koszty gromadzenia i adnotacji utrudniają utworzenie koła zamachowego danych na dużą skalę;

4) Wyzwania związane z osią czasu i przestrzeni w zadaniach długotrwałych: Długi okres realizacji zadania prowadzi do niewystarczających możliwości planowania i zapamiętywania, podczas gdy duży zakres przestrzenny wymaga od modelu rozumowania o rzeczach „poza polem widzenia”. Obecny model VLA nie posiada stabilnego modelu świata ani możliwości rozumowania międzyprzestrzennego.

Wszystkie te problemy łącznie ograniczają zdolność VLA do uogólniania scenariuszy i wdrażania na szeroką skalę.

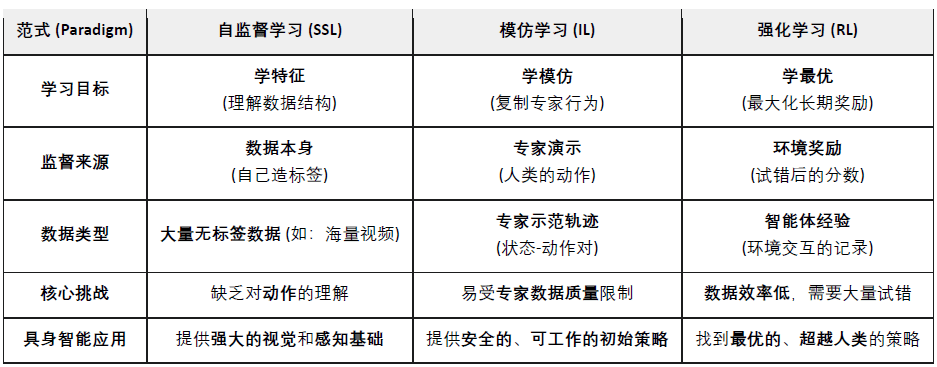

Inteligentne uczenie się: uczenie się przez samonadzorowanie (SSL), uczenie przez naśladowanie (IL) i uczenie przez wzmacnianie (RL)

Uczenie się pod nadzorem: automatyczne wyodrębnianie cech semantycznych z danych percepcyjnych, umożliwiające robotom „rozumienie świata”. Jest to równoznaczne z nauką maszyn obserwacji i reprezentacji.

Uczenie się przez imitację: Polega na szybkim opanowaniu podstawowych umiejętności poprzez naśladowanie demonstracji ludzkich lub przykładów eksperckich. W zasadzie polega na uczeniu maszyn, aby zachowywały się jak ludzie.

Uczenie przez wzmacnianie: Poprzez mechanizm nagrody i kary roboty optymalizują swoje strategie działania poprzez ciągłe próby i błędy. W istocie polega to na uczeniu maszyn rozwoju poprzez próby i błędy.

W ucieleśnionej sztucznej inteligencji (SI), samonadzorowane uczenie się (SSL) ma na celu umożliwienie robotom przewidywania zmian stanu i praw fizyki za pomocą danych percepcyjnych, a tym samym zrozumienia przyczynowej struktury świata. Uczenie się przez wzmacnianie (RL) jest głównym motorem kształtowania inteligencji, napędzającym roboty do opanowywania złożonych zachowań, takich jak chodzenie, chwytanie i unikanie przeszkód, poprzez interakcję z otoczeniem i optymalizację metodą prób i błędów opartą na sygnałach nagrody. Uczenie się przez naśladowanie (IL) przyspiesza ten proces poprzez demonstrację, umożliwiając robotom szybkie przyswajanie wiedzy o działaniach. Obecnie dominującym podejściem jest połączenie tych trzech elementów w celu zbudowania hierarchicznej struktury uczenia się: SSL zapewnia fundament reprezentacji, IL zapewnia wiedzę a priori, a RL napędza optymalizację strategii w celu zrównoważenia wydajności i stabilności, tworząc razem kluczowy mechanizm ucieleśnionej SI, od zrozumienia do działania.

Migracja rzeczywistości: Sim2Real – skok od symulacji do rzeczywistości

Sim2Real (Symulacja do Rzeczywistości) umożliwia trenowanie robotów w środowisku wirtualnym, a następnie przeniesienie ich do świata rzeczywistego. Generuje interaktywne dane na dużą skalę za pomocą środowisk symulacyjnych o wysokiej wierności (takich jak NVIDIA Isaac Sim & Omniverse i DeepMind MuJoCo), znacznie redukując koszty szkolenia i zużycie sprzętu. Podstawową zasadą Sim2Real jest wypełnienie luki między symulacją a rzeczywistością, a jej główne metody obejmują:

Randomizacja domeny: losowo dostosowuje parametry, takie jak oświetlenie, tarcie i hałas podczas symulacji, aby poprawić zdolność modelu do generalizacji;

Kalibracja spójności fizycznej: wykorzystuje rzeczywiste dane z czujników do korygowania silnika symulacji i zwiększania realizmu fizycznego;

Adaptacyjne dostrajanie: wykonuje szybkie ponowne szkolenie w środowisku rzeczywistym w celu osiągnięcia stabilnego transferu.

Sim2Real stanowi centralne ogniwo we wdrażaniu ucieleśnionej inteligencji, umożliwiając modelom AI naukę zamkniętej pętli „percepcja-decyzja-kontrola” w bezpiecznym i niedrogim świecie wirtualnym. Sim2Real jest dojrzałym narzędziem do szkolenia symulacyjnego (np. NVIDIA Isaac Sim, MuJoCo), ale jego transfer do świata rzeczywistego jest wciąż ograniczony przez lukę rzeczywistości (Reality Gap), wysoką moc obliczeniową i koszty adnotacji oraz niewystarczającą generalizację i bezpieczeństwo w środowiskach otwartych. Niemniej jednak, Simulation-as-a-Service (SimaaS) staje się najlżejszą, a jednocześnie najbardziej wartościową strategicznie infrastrukturą w erze ucieleśnionej inteligencji, z modelami biznesowymi obejmującymi platformę jako usługę (PaaS), dane jako usługę (DaaS) i bezpieczeństwo jako usługę (VaaS).

Modelowanie poznawcze: model świata – „świat wewnętrzny” robota

Model świata to „wewnętrzny mózg” ucieleśnionej inteligencji, umożliwiający robotom wewnętrzną symulację środowiska i konsekwencji swoich działań, co pozwala im na przewidywanie i wnioskowanie. Ucząc się dynamicznych praw środowiska, model konstruuje przewidywalną reprezentację wewnętrzną, pozwalając agentowi na „wstępne odegranie” wyniku przed jego wykonaniem, ewoluując od biernego wykonawcy do aktywnego wnioskowania. Reprezentatywne projekty obejmują DeepMind Dreamer, Google Gemini + RT-2, Tesla FSD V12 i NVIDIA WorldSim. Typowe ścieżki techniczne obejmują:

Modelowanie dynamiki utajonej: kompresja wielowymiarowej percepcji do przestrzeni stanów utajonych;

Planowanie oparte na wyobraźni: wirtualne próby i błędy oraz przewidywanie ścieżki w ramach modelu;

Uczenie wzmacniające oparte na modelach (RL) zastępuje środowisko rzeczywiste modelem świata, co obniża koszty szkolenia.

Model Świata jest pionierem teorii inteligencji ucieleśnionej i stanowi kluczową ścieżkę dla robotów do przejścia od inteligencji „reaktywnej” do „predykcyjnej”. Nadal jednak napotyka on na ograniczenia, takie jak złożone modelowanie, niestabilne prognozy długoterminowe i brak ujednoliconych standardów.

Inteligencja roju i rozumowanie pamięciowe: od działania indywidualnego do wspólnego poznania

Systemy wieloagentowe oraz pamięć i rozumowanie reprezentują dwa ważne kierunki ewolucji inteligencji ucieleśnionej od „inteligencji indywidualnej” do „inteligencji zbiorowej” i „inteligencji poznawczej”. Razem wspierają one uczenie się w trybie współpracy i długoterminowe zdolności adaptacyjne inteligentnych systemów.

Współpraca wieloagentowa (RL rój/kooperacja):

Odnosi się to do wielu inteligentnych agentów, którzy wspólnie podejmują decyzje i alokują zadania we współdzielonym środowisku poprzez rozproszone lub kooperacyjne uczenie się ze wzmocnieniem. Obszar ten ma solidne podstawy badawcze; na przykład eksperyment OpenAI Hide-and-Seek wykazał spontaniczną współpracę i wyłanianie się strategii wśród wielu agentów, a algorytmy QMIX i MADDPG firmy DeepMind zapewniły ramy współpracy dla scentralizowanego szkolenia i rozproszonego wykonywania zadań. Metody te zostały zastosowane i zweryfikowane w takich scenariuszach, jak harmonogramowanie pracy robotów magazynowych, inspekcja i sterowanie klastrami.

Pamięć i rozumowanie:

Skupienie się na wyposażeniu inteligentnych agentów w pamięć długotrwałą, rozumienie kontekstualne i zdolność do rozumowania przyczynowego jest kluczowym kierunkiem rozwoju transferu międzyzadaniowego i samoplanowania. Typowe badania obejmują DeepMind Gato (zunifikowanego agenta wielozadaniowego, łączącego percepcję, język i kontrolę) oraz serię DeepMind Dreamer (wyobrażeniowe planowanie oparte na modelach świata), a także otwartych agentów ucieleśnionych, takich jak Voyager, które osiągają ciągłą naukę poprzez pamięć zewnętrzną i samorozwój. Systemy te stanowią fundament dla robotów, które potrafią „pamiętać przeszłość i przewidywać przyszłość”.

Globalny krajobraz inteligentnego przemysłu: współpraca i konkurencja współistnieją

Globalny przemysł robotyki znajduje się obecnie w okresie „współpracy i zaostrzonej konkurencji”. Efektywność chińskiego łańcucha dostaw, możliwości Stanów Zjednoczonych w zakresie sztucznej inteligencji, precyzja komponentów w Japonii i europejskie standardy przemysłowe wspólnie kształtują długoterminowy krajobraz globalnego przemysłu robotyki.

Stany Zjednoczone utrzymują wiodącą pozycję w dziedzinie najnowocześniejszych modeli i oprogramowania AI (DeepMind, OpenAI, NVIDIA), ale ta przewaga nie obejmuje również sprzętu robotycznego. Chińscy producenci mają przewagę w szybkości iteracji i wydajności w warunkach rzeczywistych. Stany Zjednoczone promują odbudowę przemysłu poprzez ustawę CHIPS Act i ustawę o redukcji inflacji IRA (Inflation Reduction Act).

Chiny osiągnęły wiodącą pozycję w dziedzinie komponentów, zautomatyzowanych fabryk i robotów humanoidalnych dzięki produkcji na dużą skalę, integracji pionowej i inicjatywom politycznym. Ich potencjał sprzętowy i w zakresie łańcucha dostaw jest imponujący, a firmy takie jak Unitree Robotics i UBTECH już osiągnęły masową produkcję i rozszerzają swój zasięg na warstwę inteligentnego podejmowania decyzji. Jednak nadal istnieje znaczna różnica między Chinami a Stanami Zjednoczonymi w zakresie algorytmów i symulacji szkoleniowych.

Japonia od dawna utrzymuje monopol na produkcję precyzyjnych komponentów i technologii sterowania ruchem, a jej system przemysłowy jest solidny. Jednak integracja modeli sztucznej inteligencji jest wciąż na wczesnym etapie, a tempo innowacji jest stosunkowo powolne.

Korea Południowa wyróżnia się w popularyzacji robotów konsumenckich — na czele z takimi firmami jak LG i NAVER Labs — i posiada dojrzały i solidny ekosystem robotów usługowych.

Europa ma ugruntowane systemy inżynieryjne i standardy bezpieczeństwa. Firmy takie jak 1X Robotics nadal aktywnie działają w obszarze badań i rozwoju, ale niektóre procesy produkcyjne zostały zlecone na zewnątrz, a nacisk innowacji przesuwa się w kierunku współpracy i standaryzacji.

III. Roboty × AI × Web3: Wizja narracyjna i realistyczna ścieżka

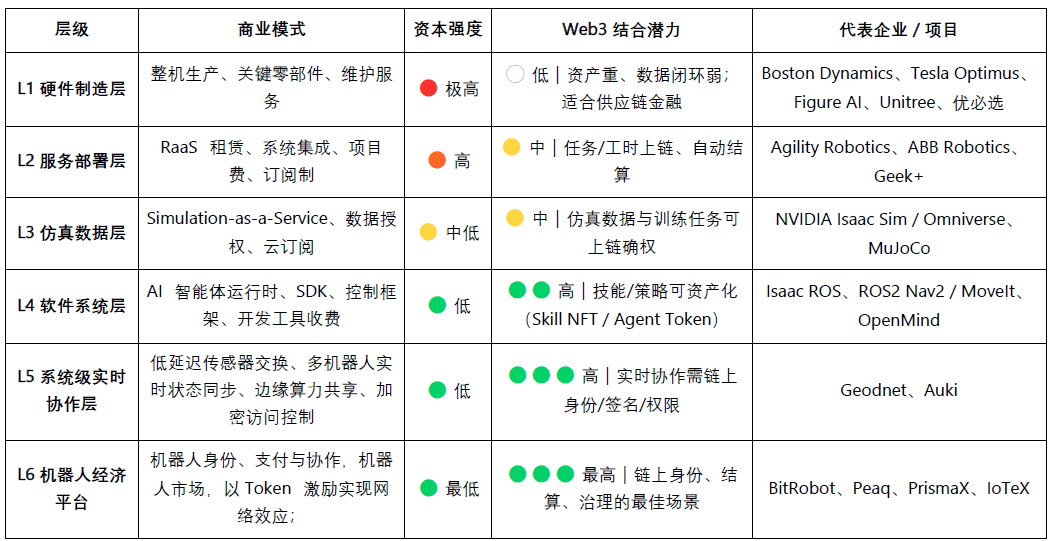

W 2025 roku w branży Web3 pojawiła się nowa narracja, łącząca robotykę i sztuczną inteligencję. Chociaż Web3 jest uważany za podstawowy protokół zdecentralizowanej gospodarki maszynowej, jego wartość i wykonalność w łączeniu różnych warstw pozostają wyraźnie zróżnicowane:

Produkcja sprzętu i usługi wymagają dużych nakładów kapitałowych i charakteryzują się słabymi pętlami danych, dlatego technologia Web3 może obecnie pełnić jedynie rolę pomocniczą w obszarach peryferyjnych, takich jak finansowanie łańcucha dostaw czy leasing sprzętu.

Ekosystem symulacji i oprogramowania jest w wysokim stopniu kompatybilny, dane symulacyjne i zadania szkoleniowe można rejestrować w blockchain, a inteligentni agenci i moduły umiejętności można zarządzać zasobami za pomocą NFT lub tokenów agentów.

Na poziomie platform największy potencjał wykazują zdecentralizowane sieci pracy i współpracy — Web3 może stopniowo budować godny zaufania „rynek pracy maszynowej” poprzez zintegrowany mechanizm tożsamości, zachęt i zarządzania, kładąc tym samym instytucjonalne podwaliny pod przyszłą gospodarkę maszynową.

Z długoterminowej perspektywy, warstwy współpracy i platformy stanowią najcenniejsze obszary integracji Web3 z robotyką i sztuczną inteligencją. W miarę jak roboty stopniowo nabywają zdolności percepcji, języka i uczenia się, ewoluują w inteligentne jednostki zdolne do autonomicznego podejmowania decyzji, współpracy i tworzenia wartości ekonomicznej. Jednak aby ci „inteligentni pracownicy” mogli prawdziwie uczestniczyć w systemie gospodarczym, muszą pokonać cztery podstawowe przeszkody: tożsamość, zaufanie, zachęty i zarządzanie.

Na poziomie tożsamości maszyny muszą posiadać weryfikowalne i możliwe do śledzenia cyfrowe tożsamości. Dzięki Machine DID każdy robot, czujnik lub dron może wygenerować unikalną i weryfikowalną „kartę identyfikacyjną” w blockchainie, wiążącą jego własność, rejestry zachowań i zakres uprawnień, umożliwiając w ten sposób bezpieczną interakcję i rozliczalność.

W warstwie zaufania kluczem jest zapewnienie weryfikowalności, mierzalności i wyceny „pracy maszyn”. Wykorzystując inteligentne kontrakty, wyrocznie i mechanizmy audytu, w połączeniu z Proof of Physical Work (PoPW), Trusted Execution Environments (TEE) i Zero-Knowledge Proofs (ZKP), można zagwarantować autentyczność i identyfikowalność procesu wykonywania zadań, co nadaje maszynom wartość ekonomiczną.

Na poziomie zachęt, Web3 umożliwia automatyczne rozliczanie i transfer wartości między maszynami poprzez system zachęt tokenowych, abstrakcję kont i kanały stanu. Roboty mogą realizować leasing mocy obliczeniowej i współdzielenie danych poprzez mikropłatności, a także zapewniać realizację zadań poprzez mechanizmy stakingu i kar; z pomocą inteligentnych kontraktów i wyroczni można również stworzyć zdecentralizowany „rynek współpracy maszyn”, który nie wymaga ręcznego planowania.

Na poziomie zarządzania, gdy maszyny uzyskają długoterminową autonomię, Web3 zapewnia przejrzyste i programowalne ramy zarządzania: zarządzanie DAO dla współdzielonych parametrów systemu decyzyjnego oraz mechanizmy wielopodpisów i reputacji dla utrzymania bezpieczeństwa i porządku. W dłuższej perspektywie doprowadzi to społeczeństwo maszyn do etapu „zarządzania algorytmicznego” – gdzie ludzie wyznaczają cele i granice, a maszyny utrzymują bodźce i równowagę poprzez kontrakty.

Ostateczna wizja konwergencji Web3 i robotyki: sieć ewaluacyjna w świecie rzeczywistym — „silnik wnioskowania w świecie rzeczywistym” złożony z rozproszonych robotów, nieustannie testujących i porównujących możliwości modeli w zróżnicowanych i złożonych scenariuszach fizycznych; oraz rynek pracy robotów — roboty wykonujące weryfikowalne zadania w świecie rzeczywistym na całym świecie, zarabiające na rozliczeniach w łańcuchu i reinwestujące tę wartość w moc obliczeniową lub modernizację sprzętu.

Z praktycznego punktu widzenia, integracja inteligencji ucieleśnionej i Web3 jest wciąż na wczesnym etapie badań, a zdecentralizowane gospodarki oparte na inteligencji maszynowej pozostają w dużej mierze na poziomie rozwoju narracyjnego i opartego na społecznościach. Realne i potencjalnie realne kierunki integracji w rzeczywistości leżą głównie w następujących trzech aspektach:

(1) Crowdsourcing danych i potwierdzenie własności – Web3 zachęca uczestników do przesyłania rzeczywistych danych za pomocą mechanizmów zachęt i śledzenia w łańcuchu;

(2) Globalny udział o długim ogonie – transgraniczne mikropłatności i mechanizmy mikrozachęt skutecznie obniżają koszty gromadzenia i dystrybucji danych;

(3) Finansjalizacja i innowacja oparta na współpracy – Model DAO może promować aktywację robotów, wydawanie certyfikatów przychodów i mechanizm rozliczeń między maszynami.

Ogólnie rzecz biorąc, w krótkiej perspektywie nacisk zostanie położony głównie na gromadzenie danych i warstwę zachęt; w średniej perspektywie spodziewany jest przełom w obszarach „płatności stablecoin + agregacja danych long-tail” oraz warstwy aktywów RaaS i rozliczeń; w długiej perspektywie, jeśli roboty humanoidalne staną się powszechne, Web3 może stać się instytucjonalną podstawą dla własności maszyn, dystrybucji przychodów i zarządzania, promując kształtowanie się prawdziwie zdecentralizowanej gospodarki maszynowej.

IV. Mapa ekosystemu robotów Web3 i wybrane przypadki

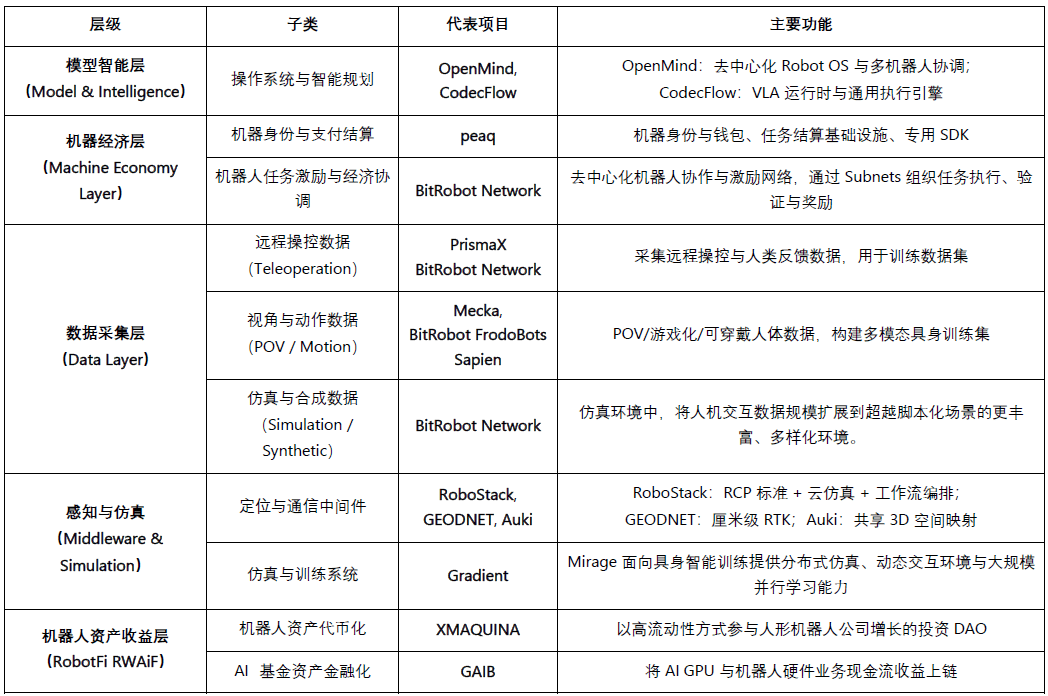

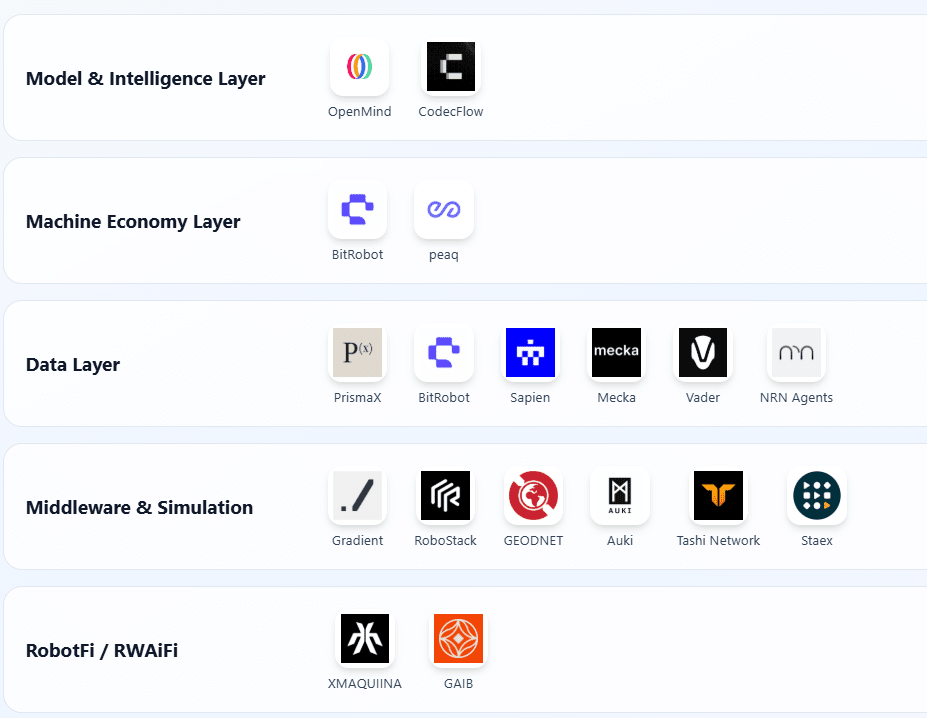

W oparciu o trzy kryteria – weryfikowalny postęp, otwartość technologiczną i znaczenie dla branży – stworzyliśmy listę reprezentatywnych projektów Web3 × Robotics i podzieliliśmy je na pięć warstw: warstwa inteligencji modelu, warstwa ekonomii maszyn, warstwa pozyskiwania danych, warstwa podstawowa percepcji i symulacji oraz warstwa przychodów z zasobów robotów. Aby zachować obiektywizm, usunęliśmy projekty, które wyraźnie „płyną na fali” lub nie zawierają wystarczających informacji; wszelkie pominięcia są mile widziane.

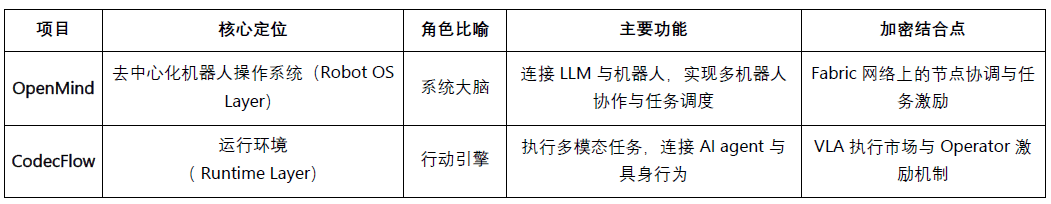

Warstwa modelu i inteligencji

Openmind – Tworzenie Androida dla robotów (https://openmind.org/)

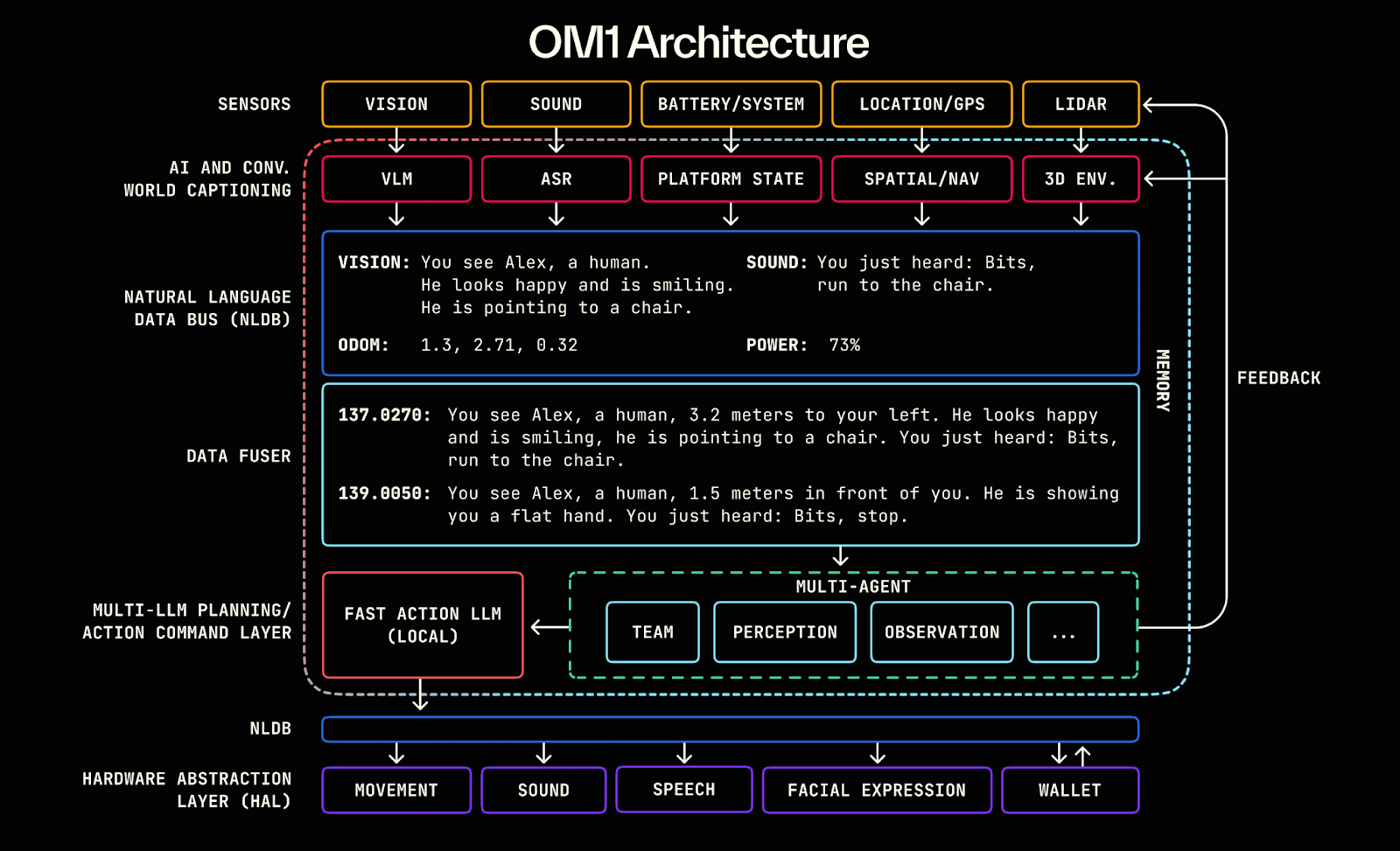

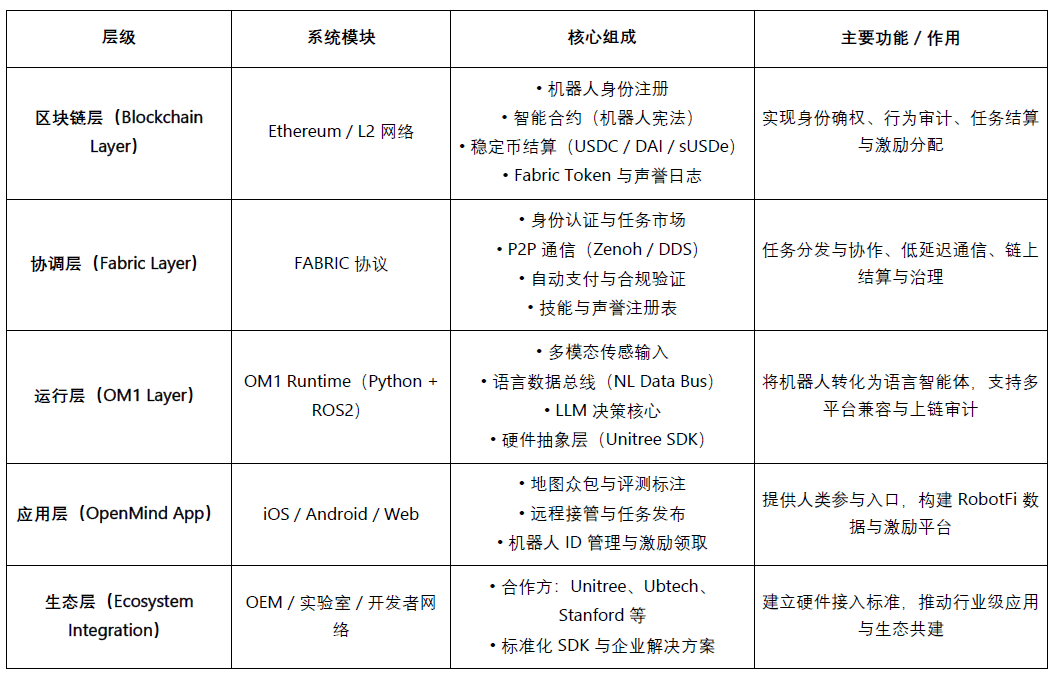

OpenMind to system operacyjny typu open source (Robot OS) do ucieleśnionej sztucznej inteligencji (AI) i sterowania robotami, którego celem jest stworzenie pierwszego na świecie zdecentralizowanego środowiska uruchomieniowego i platformy programistycznej dla robotów. Rdzeń projektu składa się z dwóch głównych komponentów:

OM1: Modułowa, otwartoźródłowa warstwa wykonawcza sztucznej inteligencji zbudowana na bazie ROS2, służąca do koordynowania procesów percepcji, planowania i działania dla robotów cyfrowych i fizycznych;

FABRIC: Warstwa koordynująca strukturę łączy moc obliczeniową chmury, modele i rzeczywiste roboty, umożliwiając programistom sterowanie i szkolenie robotów w ujednoliconym środowisku.

W swojej istocie OpenMind działa jako inteligentna warstwa pośrednicząca między Modelem Dużego Języka (LLM) a światem robotyki, prawdziwie przekształcając inteligencję językową w inteligencję ucieleśnioną i konstruując inteligentne ramy od zrozumienia (Język → Działanie) do dostosowania (Blockchain → Reguły). Wielowarstwowy system OpenMind tworzy pełną pętlę współpracy: ludzie przekazują informacje zwrotne i adnotacje (dane RLHF) za pośrednictwem aplikacji OpenMind; sieć Fabric Network obsługuje uwierzytelnianie, przydzielanie zadań i koordynację rozliczeń; a roboty OM1 wykonują zadania i postępują zgodnie z „konstytucją robota” blockchaina, aby ukończyć audyt zachowań i płatności, realizując w ten sposób zdecentralizowaną sieć współpracy maszyn, w której ludzkie informacje zwrotne → współpraca nad zadaniami → rozliczenia on-chain.

Postęp projektu i ocena rzeczywistości

OpenMind jest na wczesnym etapie „technicznej wykonalności, ale jeszcze nieopłacalności komercyjnej”. System bazowy OM1 Runtime został udostępniony jako open source w serwisie GitHub, może działać na wielu platformach i obsługuje multimodalne wprowadzanie danych. Zapewnia on zrozumienie zadań od języka do działania za pomocą magistrali danych języka naturalnego (NLDB). Jest on bardzo oryginalny, ale wciąż w fazie eksperymentalnej. Sieć Fabric i rozliczenia on-chain zakończyły dopiero projektowanie warstwy interfejsu.

W zakresie ekosystemu, projekt nawiązał współpracę z firmami open-hardware, takimi jak Unitree, Ubtech i TurtleBot, a także z uniwersytetami takimi jak Stanford, Oxford i Seoul Robotics, głównie w celu walidacji edukacyjnej i badawczej, bez jak dotąd zastosowań przemysłowych. Aplikacja została uruchomiona w wersji beta, ale funkcje motywacyjne i zadaniowe są wciąż na wczesnym etapie rozwoju.

Pod względem modelu biznesowego, OpenMind zbudował trójwarstwowy ekosystem składający się z OM1 (system open source), Fabric (protokół rozliczeniowy) i Skill Marketplace (warstwa motywacyjna). Obecnie firma nie generuje przychodów i opiera się na finansowaniu na wczesnym etapie w wysokości około 20 milionów dolarów (od Pantera, Coinbase Ventures i DCG). Ogólnie rzecz biorąc, choć technologia firmy jest wiodąca, komercjalizacja i rozwój ekosystemu wciąż znajdują się na wczesnym etapie. Jeśli Fabric zostanie pomyślnie wdrożony, ma potencjał, aby stać się „Androidem ery inteligentnej”, ale proces ten jest długotrwały, ryzykowny i w dużym stopniu zależny od sprzętu.

CodecFlow – silnik wykonawczy dla robotyki (https://codecflow.ai)

CodecFlow to zdecentralizowany protokół warstwy wykonawczej (Fabric) oparty na sieci Solana, zaprojektowany w celu zapewnienia środowiska uruchomieniowego na żądanie dla agentów AI i systemów robotycznych, umożliwiając każdemu agentowi posiadanie „natychmiastowej maszyny”. Rdzeń projektu składa się z trzech głównych modułów:

Fabric: Warstwa agregacji mocy obliczeniowej między chmurami (Weaver + Shuttle + Gauge), która może w ciągu kilku sekund generować bezpieczne maszyny wirtualne, kontenery GPU lub węzły sterujące robotami do zadań AI;

optr SDK: Inteligentna platforma wykonywania agentów (interfejs Python) do tworzenia „operatorów” mogących obsługiwać roboty stacjonarne, symulowane lub rzeczywiste;

Zachęty w postaci tokenów: Warstwa zachęt i płatności w łańcuchu bloków, która łączy dostawców usług obliczeniowych, twórców inteligentnych agentów i użytkowników zadań zautomatyzowanych, tworząc zdecentralizowany rynek mocy obliczeniowej i zadań.

Głównym celem CodecFlow jest stworzenie „zdecentralizowanej podstawy wykonawczej dla sztucznej inteligencji i operatorów robotów”, umożliwiającej bezpieczne działanie dowolnego inteligentnego agenta w dowolnym środowisku (Windows / Linux / ROS / MuJoCo / kontroler robota), co pozwoli na uzyskanie uniwersalnej architektury wykonawczej od planowania mocy obliczeniowej (Fabric) → środowisko systemowe (warstwa systemowa) → percepcja i działanie (operator VLA).

Postęp projektu i ocena rzeczywistości

Wydano już wczesne wersje frameworka Fabric (Go) i zestawu SDK optr (Python), umożliwiające uruchamianie izolowanych instancji obliczeniowych w środowiskach webowych lub wiersza poleceń. Oczekuje się, że Operator Marketplace, pozycjonowany jako zdecentralizowana warstwa wykonawcza dla mocy obliczeniowej AI, zostanie uruchomiony do końca 2025 roku.

Naszymi głównymi klientami są twórcy sztucznej inteligencji, zespoły badawcze zajmujące się robotyką i firmy zajmujące się automatyzacją.

Warstwa ekonomii maszynowej

BitRobot – Otwarte Laboratorium Robotyki na Świecie (https://bitrobot.ai)

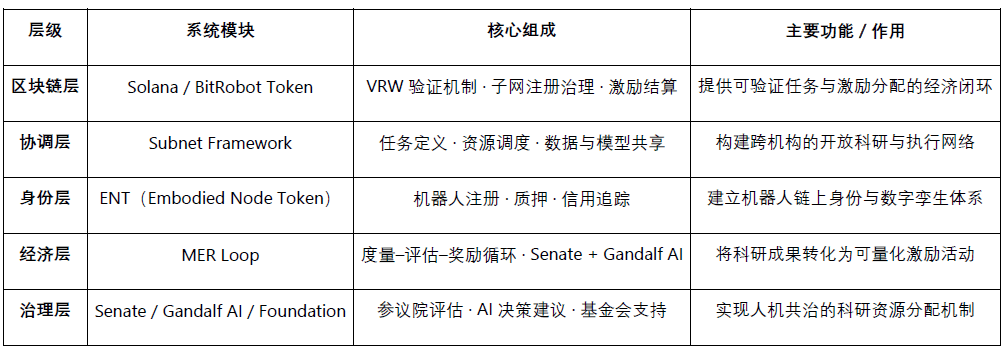

BitRobot to zdecentralizowana sieć badań i współpracy (Open Robotics Lab) zajmująca się rozwojem ucieleśnionej sztucznej inteligencji (EMBOD) i robotyki, zainicjowana wspólnie przez FrodoBots Labs i Protocol Labs. Jej główną wizją jest wykorzystanie otwartej architektury „podsieci + mechanizmów motywacyjnych + weryfikowalnej pracy (VRW)”, z następującymi podstawowymi funkcjami:

Określ i zweryfikuj prawdziwy wkład każdego zadania robotycznego za pomocą standardu VRW (Verifiable Robotic Work);

Nadaj botom tożsamość łańcuchową i odpowiedzialność ekonomiczną za pośrednictwem ENT (Embodied Node Token);

Organizowanie współpracy międzyregionalnej pomiędzy badaczami, mocą obliczeniową, sprzętem i operatorami poprzez podsieci;

Osiągnięcie opartego na bodźcach podejmowania decyzji i zarządzania badaniami naukowymi poprzez „współrządzenie człowiek-maszyna” za pośrednictwem Senatu i sztucznej inteligencji Gandalfa.

Od czasu wydania białej księgi w 2025 r. firma BitRobot obsługiwała wiele podsieci (takich jak SN/01 ET Fugi i SN/05 SeeSaw firmy Virtuals Protocol), aby osiągnąć zdecentralizowane zdalne sterowanie i gromadzenie danych w warunkach rzeczywistych. Uruchomiła również fundusz Grand Challenges o wartości 5 mln dolarów w celu promowania globalnego konkursu badawczego w zakresie opracowywania modeli.

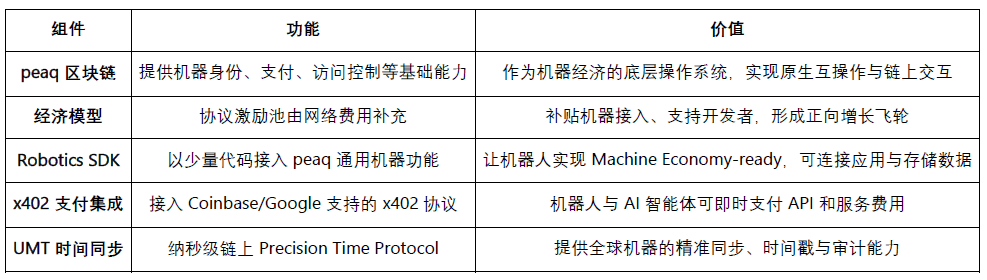

peaq – Gospodarka rzeczy (https://www.peaq.network)

PeaQ to blockchain warstwy 1 zaprojektowany specjalnie z myślą o gospodarce maszynowej, oferujący milionom robotów i urządzeń podstawowe funkcje, takie jak identyfikacja maszyn, portfele on-chain, kontrola dostępu oraz synchronizacja czasu na poziomie nanosekund (Universal Machine Time). Jego pakiet Robotics SDK umożliwia programistom tworzenie robotów „gotowych do gospodarki maszynowej” przy minimalnej ilości kodu, zapewniając interoperacyjność i interakcję między dostawcami i systemami.

Obecnie Peaq uruchomił pierwszą na świecie tokenizowaną farmę robotyki i obsługuje ponad 60 rzeczywistych aplikacji robotycznych. Jego platforma tokenizacji pomaga firmom robotycznym pozyskiwać fundusze na kapitałochłonny sprzęt i rozszerza uczestnictwo z tradycyjnego modelu B2B/B2C na poziom szerszej społeczności. Dzięki puli zachęt na poziomie protokołu, zasilanej opłatami sieciowymi, Peaq dofinansowuje dostęp do nowych urządzeń i wspiera deweloperów, tworząc ekonomiczne koło zamachowe, które przyspiesza rozwój projektów robotyki i fizycznej sztucznej inteligencji.

Warstwa pozyskiwania danych

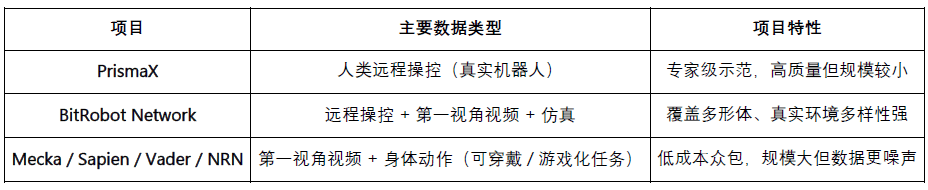

Celem projektu jest rozwiązanie problemu niedoboru i wysokich kosztów wysokiej jakości danych rzeczywistych w szkoleniach z zakresu inteligencji ucieleśnionej. System gromadzi i generuje dane dotyczące interakcji człowiek-komputer za pośrednictwem wielu kanałów, w tym zdalnego sterowania (PrismaX, BitRobot Network), perspektywy pierwszoosobowej i przechwytywania ruchu (Mecka, BitRobot Network, Sapien, Vader, NRN) oraz danych symulacyjnych i syntetycznych (BitRobot Network), zapewniając skalowalną i uogólnialną podstawę szkoleniową dla modeli robotów.

Należy wyjaśnić, że Web3 nie jest ekspertem w „produkcji danych” – giganci Web2 znacznie przewyższają każdy projekt DePIN pod względem sprzętu, algorytmów i wydajności gromadzenia danych. Jego prawdziwa wartość tkwi w przekształcaniu dystrybucji danych i mechanizmów motywacyjnych. Oparty na modelu „sieci płatności stablecoin + crowdsourcing”, zapewnia niskie koszty, niskie kwoty rozliczeń, możliwość śledzenia wkładów oraz automatyczny podział zysków poprzez niewymagający zezwoleń system motywacyjny i mechanizm potwierdzania własności w łańcuchu bloków. Jednak otwarty crowdsourcing nadal napotyka wyzwania związane z jakością i zamykaniem popytu – jakość danych jest bardzo zróżnicowana, brakuje skutecznej weryfikacji i stabilnych nabywców.

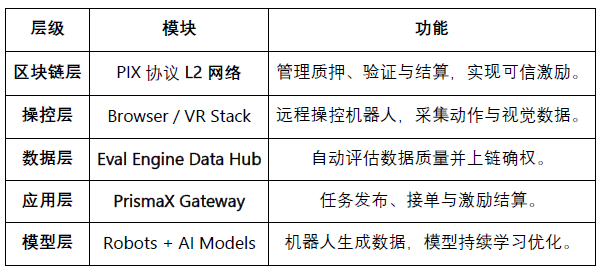

PrismaX (https://gateway.prismax.ai)

PrismaX to zdecentralizowana sieć telekontroli i gospodarki danymi dla Embodied AI, której celem jest zbudowanie „globalnego rynku pracy robotów”, gdzie ludzcy operatorzy, urządzenia robotyczne i modele AI współewoluują poprzez system zachęt on-chain. Rdzeń projektu składa się z dwóch głównych komponentów:

Teleoperation Stack — system zdalnego sterowania (interfejs przeglądarki/VR + SDK), który łączy ramiona robotyczne i roboty usługowe na całym świecie, umożliwiając sterowanie ludźmi w czasie rzeczywistym i zbieranie danych;

Eval Engine – silnik oceny i weryfikacji danych (CLIP + DINOv2 + semantyczna ocena przepływu optycznego) – generuje wynik jakości dla każdej trajektorii operacji i ustala go w blockchainie.

PrismaX przekształca ludzkie działania w dane uczenia maszynowego za pomocą zdecentralizowanego mechanizmu motywacyjnego, tworząc zamkniętą pętlę od zdalnego sterowania → gromadzenia danych → trenowania modeli → rozliczeń on-chain, realizując w ten sposób gospodarkę o obiegu zamkniętym, w której „praca ludzka jest zasobem danych”.

Postępy projektu i ocena w warunkach rzeczywistych: PrismaX uruchomił wersję beta (gateway.prismax.ai) w sierpniu 2025 roku, umożliwiając użytkownikom zdalne sterowanie ramieniem robota w celu przeprowadzania eksperymentów chwytania i generowania danych treningowych. Silnik ewaluacyjny jest już uruchomiony wewnętrznie. Ogólnie rzecz biorąc, PrismaX demonstruje wysoki poziom wdrożenia technicznego i wyraźnie pozycjonuje się jako kluczowe oprogramowanie pośredniczące łączące „operacje ludzkie × model sztucznej inteligencji × rozliczenia oparte na blockchainie”. Jego długoterminowy potencjał tkwi w staniu się „zdecentralizowanym protokołem pracy i danych dla ery ucieleśnionej inteligencji”, ale nadal stoi przed wyzwaniami związanymi ze skalowaniem w perspektywie krótkoterminowej.

Sieć BitRobot(https://bitrobot.ai/)

Sieć BitRobot wykorzystuje swoje podsieci do gromadzenia danych z wielu źródeł, w tym wideo, zdalnego sterowania i symulacji. Sieć SN/01 ET Fugi umożliwia użytkownikom zdalne sterowanie robotami w celu wykonywania zadań, gromadząc dane nawigacyjne i percepcyjne w interakcji „w stylu Pokémon Go w realnym świecie”. To podejście doprowadziło do powstania zbioru danych FrodoBots-2K, jednego z największych obecnie dostępnych, otwartych zbiorów danych nawigacyjnych człowiek-robot, z którego korzystają takie instytucje jak UC Berkeley RAIL i Google DeepMind. Sieć SN/05 SeeSaw (Virtual Protocol) wykorzystuje iPhone'y do crowdsourcingu danych wideo z widoku pierwszoosobowego w rzeczywistych warunkach. Inne opublikowane podsieci, takie jak RoboCap i Rayvo, koncentrują się na gromadzeniu danych wideo z widoku pierwszoosobowego za pomocą niedrogich urządzeń fizycznych.

Mekka (https://www.mecka.ai)

Mecka to firma zajmująca się danymi robotycznymi, która wykorzystuje mobilne zbieranie danych w formie gier oraz dostosowany sprzęt do tworzenia oddolnych filmów z perspektywy pierwszej osoby, danych o ruchu człowieka i demonstracji zadań. W ten sposób tworzy obszerne, multimodalne zbiory danych, które wspomagają szkolenie modeli inteligencji ucieleśnionej.

Sapien (https://www.sapien.io/)

Sapien to platforma crowdsourcingowa skupiająca się na „danych o ruchu człowieka napędzających inteligencję robotów”. Gromadzi ona dane o ruchach, postawach i interakcjach człowieka za pomocą urządzeń noszonych i aplikacji mobilnych, aby trenować ucieleśnione inteligentne modele. Projekt ma na celu zbudowanie największej na świecie sieci danych o ruchu człowieka, dzięki czemu naturalne zachowania człowieka staną się podstawowym źródłem danych do uczenia się i generalizacji robotów.

Vader (https://www.vaderai.ai)

Vader korzysta z crowdsourcingu filmów z perspektywy pierwszej osoby i demonstracji zadań za pośrednictwem swojej aplikacji MMO, EgoPlay: użytkownicy rejestrują codzienne czynności z perspektywy pierwszej osoby i zdobywają nagrody $VADER. Jego system danych ORN konwertuje surowe nagrania z perspektywy pierwszej osoby na ustrukturyzowane zbiory danych chroniące prywatność, zawierające etykiety działań i opisy semantyczne, które można bezpośrednio wykorzystać do szkolenia polityk dotyczących robotów humanoidalnych.

Agenci NRN (https://www.nrnagents.ai/)

Platforma danych RL z elementami grywalizacji, która gromadzi dane demonstracyjne od ludzi poprzez sterowanie robotem za pomocą przeglądarki i symulowane zawody. NRN generuje długie trajektorie zachowań poprzez zadania „konkurencyjne” w celu uczenia się przez naśladowanie i ciągłego wzmacniania, a także służy jako skalowalny prymityw danych do wspierania szkolenia z symulacji w zakresie rzeczywistej polityki.

Porównanie projektów wdrożonej inteligentnej warstwy pozyskiwania danych

Percepcja i symulacja (oprogramowanie pośredniczące i symulacja)

Warstwa percepcji i symulacji zapewnia robotom podstawową infrastrukturę łączącą świat fizyczny z inteligentnym podejmowaniem decyzji, w tym takie funkcje, jak lokalizacja, komunikacja, modelowanie przestrzenne i szkolenie symulacyjne. Służy ona jako „szkielet warstwy pośredniej” do budowy inteligentnych systemów ucieleśnionych na dużą skalę. Obecnie ta dziedzina znajduje się we wczesnej fazie eksploracyjnej, a różne projekty opracowują zróżnicowane rozwiązania w takich obszarach, jak precyzyjne pozycjonowanie, współdzielone obliczenia przestrzenne, standaryzacja protokołów i symulacja rozproszona. Nie powstał jeszcze ujednolicony standard ani interoperacyjny ekosystem.

Oprogramowanie pośredniczące i infrastruktura przestrzenna

Podstawowe możliwości robotyki – nawigacja, lokalizacja, łączność i modelowanie przestrzenne – tworzą kluczowy most łączący świat fizyczny z inteligentnym podejmowaniem decyzji. Podczas gdy szersze projekty DePIN (Silencio, WeatherXM, DIMO) zaczynają odnosić się do „robotyki”, poniższe projekty są najbardziej bezpośrednio związane z inteligencją ucieleśnioną.

RoboStack – chmurowy stos operacyjny robotów (https://robostack.io)

RoboStack to chmurowe oprogramowanie pośredniczące do obsługi robotów, które umożliwia planowanie zadań robotów w czasie rzeczywistym, zdalne sterowanie i międzyplatformową interoperacyjność zadań robotów za pośrednictwem protokołu RCP (Robot Context Protocol). Zapewnia ono także symulację w chmurze, koordynację przepływu pracy i możliwości dostępu agentów.

GEODNET – Zdecentralizowana sieć GNSS (https://geodnet.com)

GEODNET to globalna, zdecentralizowana sieć GNSS, która zapewnia precyzyjne pozycjonowanie RTK z dokładnością do centymetra. Dzięki rozproszonym stacjom bazowym i systemom zachęt on-chain, zapewnia ona „warstwę odniesienia geograficznego” w czasie rzeczywistym dla dronów, pojazdów autonomicznych i robotów.

Auki – Posemesh do obliczeń przestrzennych (https://www.auki.com)

Firma Auki zbudowała zdecentralizowaną sieć przetwarzania przestrzennego Posemesh, która generuje trójwymiarowe mapy otoczenia w czasie rzeczywistym za pomocą czujników i węzłów obliczeniowych pozyskiwanych z crowdsourcingu, zapewniając wspólny punkt odniesienia dla rozszerzonej rzeczywistości (AR), nawigacji robotów i współpracy między wieloma urządzeniami. Jest to kluczowa infrastruktura łącząca przestrzeń wirtualną ze scenariuszami ze świata rzeczywistego, napędzając konwergencję rozszerzonej rzeczywistości (AR) i robotyki.

Tashi Network — sieć współpracy w czasie rzeczywistym dla robotów (https://tashi.network)

Zdecentralizowana sieć mesh działająca w czasie rzeczywistym, która osiąga konsensus poniżej 30 ms, wymianę czujników z niskim opóźnieniem i synchronizację stanu wielu robotów. MeshNet SDK obsługuje współdzielony SLAM, współpracę roju i solidne aktualizacje map, zapewniając wysokowydajną warstwę współpracy w czasie rzeczywistym dla ucieleśnionej sztucznej inteligencji.

Staex — zdecentralizowana sieć łączności i telemetrii (https://www.staex.io)

Zdecentralizowana warstwa łączności, której źródłem jest dział badawczo-rozwojowy Deutsche Telekom, zapewnia bezpieczną komunikację, zaufaną telemetrię i możliwości routingu między urządzeniami a chmurą. Dzięki temu floty robotów mogą niezawodnie wymieniać się danymi i współpracować z różnymi operatorami.

Rozproszony system symulacji i uczenia się

Gradient – W stronę otwartej inteligencji (https://gradient.network/)

Gradient to laboratorium sztucznej inteligencji o nazwie „Open Intelligence”, którego celem jest umożliwienie rozproszonego szkolenia, wnioskowania, walidacji i symulacji w oparciu o zdecentralizowaną infrastrukturę. Aktualny zestaw technologii Gradient obejmuje Parallax (rozproszone wnioskowanie), Echo (rozproszone uczenie ze wzmocnieniem i szkolenie wieloagentowe) oraz Gradient Cloud (rozwiązanie AI zorientowane na przedsiębiorstwa). W robotyce platforma Mirage zapewnia rozproszoną symulację, dynamiczne środowiska interaktywne oraz możliwości uczenia masowo równoległego do szkolenia w zakresie inteligencji ucieleśnionej, przyspieszając szkolenie i wdrażanie modeli świata i ogólnych zasad. Mirage bada potencjalną współpracę z firmą NVIDIA w zakresie swojego silnika Newton Engine.

Warstwa przychodów z zasobów robotów (RobotFi / RWAiFi)

Ta warstwa koncentruje się na kluczowych krokach transformacji robotów z „produktywnych narzędzi” w „aktywa finansotwórcze”, budując infrastrukturę finansową dla gospodarki maszynowej poprzez tokenizację aktywów, dystrybucję zysków i zdecentralizowane zarządzanie. Reprezentatywne projekty obejmują:

XmaquinaDAO – DAO fizycznej sztucznej inteligencji (https://www.xmaquina.io)

XMAQUINA to zdecentralizowany ekosystem, który zapewnia użytkownikom z całego świata wysoce płynny dostęp do wiodących robotów humanoidalnych i firm zajmujących się ucieleśnioną sztuczną inteligencją, wprowadzając na blockchain możliwości, które wcześniej były dostępne tylko dla funduszy venture capital. Token XMAQUINA, DEUS, służy zarówno jako płynny indeks aktywów, jak i narzędzie zarządzania, koordynując alokację środków i rozwój ekosystemu. Poprzez portal DAO i platformę Machine Economy Launchpad, społeczność może wspólnie utrzymywać i wspierać powstające projekty fizycznej sztucznej inteligencji (Physical AI) poprzez tokenizowany i ustrukturyzowany udział w zasobach maszynowych w łańcuchu bloków.

GAIB – Warstwa ekonomiczna infrastruktury AI (https://gaib.ai/)

GAIB stawia sobie za cel zapewnienie jednolitej warstwy ekonomicznej dla fizycznej infrastruktury AI, takiej jak procesory GPU i roboty, łącząc zdecentralizowany kapitał z rzeczywistymi zasobami infrastruktury AI w celu zbudowania weryfikowalnego, komponowalnego i dochodowego inteligentnego systemu ekonomicznego.

W sektorze robotyki GAIB nie „sprzedaje tokenów robotów”, lecz finansuje sprzęt robotyczny i kontrakty operacyjne (RaaS, gromadzenie danych, teleoperacja itp.) w oparciu o blockchain, przekształcając „rzeczywisty przepływ gotówki w kompozytowe aktywa generujące przychody w ramach łańcucha bloków”. System ten obejmuje finansowanie sprzętu (leasing/staking finansowy), przepływy pieniężne z działalności operacyjnej (RaaS/usługi danych) oraz przychody z przepływu danych (licencje/kontrakty), dzięki czemu zasoby robotów i ich przepływy pieniężne są mierzalne, wyceniane i zbywalne.

GAIB wykorzystuje AID/sAID jako swój instrument rozliczeniowy i zwrotny, zapewniając stabilne zyski poprzez ustrukturyzowane mechanizmy kontroli ryzyka (nadzabezpieczenie, rezerwy i ubezpieczenie). Utrzymuje również długoterminowy dostęp do instrumentów pochodnych DeFi i rynków płynności, tworząc zamkniętą pętlę finansową od „aktywów robotycznych” do „aktywów o łącznym dochodzie”. Celem GAIB jest stanie się ekonomicznym kręgosłupem inteligencji w erze sztucznej inteligencji.

Mapa ekosystemu robotów Web3: https://fairy-build-97286531.figma.site/

V. Podsumowanie i perspektywy: obecne wyzwania i długoterminowe szanse

W długoterminowej perspektywie integracja robotyki, sztucznej inteligencji i technologii Web3 ma na celu zbudowanie zdecentralizowanej gospodarki maszynowej (DeRobot Economy), która przekształci ucieleśnioną inteligencję z „automatyzacji pojedynczej maszyny” w sieciową współpracę opartą na „własności, rozliczeniach i zarządzaniu”. Jej sednem jest stworzenie samoczynnie krążącego mechanizmu poprzez „token → wdrożenie → dane → redystrybucję wartości”, umożliwiającego robotom, czujnikom i węzłom obliczeniowym uzyskanie własności, transakcji i podziału zysków.

Jednak z praktycznego punktu widzenia, model ten jest wciąż na wczesnym etapie eksploracji, daleki od osiągnięcia stabilnego przepływu środków pieniężnych i szeroko zakrojonej pętli biznesowej. Większość projektów pozostaje na poziomie narracji, z ograniczonym faktycznym wdrożeniem. Produkcja i konserwacja robotów to branże kapitałochłonne, a same zachęty w postaci tokenów nie są w stanie wesprzeć rozbudowy infrastruktury; chociaż modele finansowe oparte na łańcuchu bloków oferują kompozycyjność, nie rozwiązały jeszcze problemów z wyceną ryzyka i realizacją zwrotu z aktywów rzeczywistych. Dlatego też tak zwana „sieć samoobsługowych maszyn” pozostaje w pewnym sensie idealistyczna, a jej model biznesowy wymaga weryfikacji w warunkach rzeczywistych.

Warstwa Modelu i Inteligencji jest obecnie najcenniejszym obszarem długoterminowego rozwoju. Systemy operacyjne robotów typu open source, takie jak OpenMind, dążą do przełamania zamkniętych ekosystemów i ujednolicenia współpracy wielu robotów oraz interfejsów językowo-akcyjnych. Choć ich wizja technologiczna jest jasna, a systemy kompletne, nakład pracy inżynieryjnej jest ogromny, cykl weryfikacji długi, a na poziomie przemysłowym nie udało im się jeszcze uzyskać pozytywnego feedbacku.

Warstwa gospodarki maszynowej jest wciąż w początkowej fazie rozwoju. W rzeczywistości liczba robotów jest ograniczona, a tożsamości DID (Distributed Identification) i sieci motywacyjne nie utworzyły jeszcze spójnego cyklu. Wciąż jesteśmy daleko od prawdziwej „gospodarki opartej na pracy maszynowej”. Dopiero po wdrożeniu na szeroką skalę ucieleśnionej inteligencji ekonomiczne efekty sieci tożsamości, rozliczeń i współpracy w łańcuchu staną się naprawdę widoczne.

Warstwa akwizycji danych ma najniższą barierę wejścia, ale obecnie jest najbliższa komercyjnej opłacalności. Akwizycja danych w ramach ucieleśnionej inteligencji wymaga niezwykle wysokiego poziomu ciągłości czasoprzestrzennej i semantycznej dokładności działań, co decyduje o ich jakości i możliwości ponownego wykorzystania. Zrównoważenie „skali crowdsourcingu” z „niezawodnością danych” stanowi kluczowe wyzwanie dla branży. PrismaX najpierw koncentruje się na potrzebach B-end, a następnie dystrybuuje zadania związane z gromadzeniem i weryfikacją, zapewniając w pewnym stopniu powtarzalny szablon, jednak skala ekosystemu i handel danymi nadal wymagają czasu na akumulację.

Warstwa pośrednicząca i symulacyjna wciąż znajdują się na etapie weryfikacji technologicznej, brakuje ujednoliconych standardów i interfejsów, a także nie ukształtowały jeszcze interoperacyjnego ekosystemu. Wyniki symulacji są trudne do standaryzacji i przeniesienia do rzeczywistych środowisk, co ogranicza wydajność Sim2Real.

Warstwa dochodu z aktywów (RobotFi/RWAiFi) Web3 pełni głównie rolę pomocniczą w finansowaniu łańcucha dostaw, leasingu sprzętu i zarządzaniu inwestycjami, zwiększając przejrzystość i efektywność rozliczeń, zamiast zmieniać logikę branży.

Oczywiście wierzymy, że połączenie robotyki, sztucznej inteligencji i Web3 nadal stanowi początek kolejnej generacji inteligentnych systemów gospodarczych. To nie tylko fuzja paradygmatów technologicznych, ale także szansa na restrukturyzację relacji produkcyjnych: gdy maszyny będą posiadały tożsamość, bodźce i mechanizmy zarządzania, współpraca człowiek-maszyna przejdzie od częściowej automatyzacji do autonomii sieciowej. W perspektywie krótkoterminowej kierunek ten będzie nadal przede wszystkim narracyjny i eksperymentalny, ale ramy instytucjonalne i motywacyjne, które ustanawia, kładą podwaliny pod porządek ekonomiczny przyszłego społeczeństwa maszyn. W perspektywie długoterminowej połączenie inteligencji ucieleśnionej i Web3 zmieni granice tworzenia wartości – czyniąc inteligentnych agentów prawdziwie identyfikowalnymi, współpracującymi i rentownymi podmiotami gospodarczymi.

Zastrzeżenie: Niniejszy artykuł został napisany przy pomocy narzędzi sztucznej inteligencji ChatGPT-5 i Deepseek. Autor dołożył wszelkich starań, aby zweryfikować i zapewnić prawdziwość i dokładność informacji, jednak pominięcia są nieuniknione. Przepraszamy za wszelkie niedogodności. Szczególnie ważne jest, aby pamiętać, że na rynku kryptowalut często występuje rozbieżność między fundamentami projektu a wynikami cen na rynku wtórnym. Treść niniejszego artykułu ma charakter wyłącznie informacyjny i naukowo-badawczy i nie stanowi porady inwestycyjnej ani nie powinna być traktowana jako rekomendacja kupna lub sprzedaży tokenów.