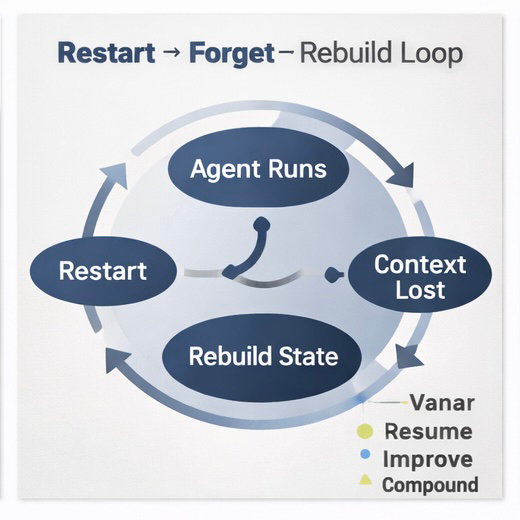

Na semana passada, eu estava testando um agente simples de monitoramento de risco em uma cadeia “de alto desempenho”. No papel, era perfeito: baixas taxas, enorme TPS, painéis suaves. Na prática, após algumas reinicializações, ele esqueceu metade de seu contexto. Consultas de acompanhamento acionaram re-verificações. Os custos de gás multiplicaram-se silenciosamente. No final da noite, eu não estava depurando lógica — eu estava reconstruindo memória. Foi então que percebi: a maioria das cadeias “preparadas para IA” no Web3 não está pronta de forma alguma. Elas são apenas rápidas.

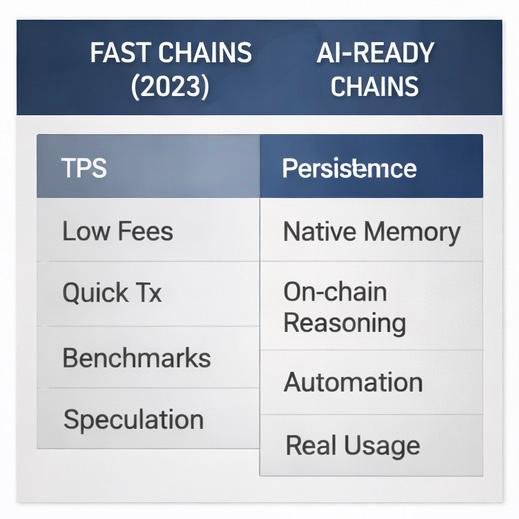

Por anos, blockchains foram otimizadas para uma coisa: transações. Mais TPS, menor latência, trocas mais baratas. Isso funcionou para flipagem DeFi e mintagens de NFT. Não funciona para inteligência. Agentes de IA não vivem em transações únicas; eles vivem em linhas do tempo. Eles coordenam, se adaptam, aprendem com estados passados e dependem da continuidade. No entanto, a maioria das cadeias ainda trata cada execução como um novo começo. Reiniciar, esquecer, reconstruir. Isso não é infraestrutura para inteligência. Isso é infraestrutura para scripts descartáveis.

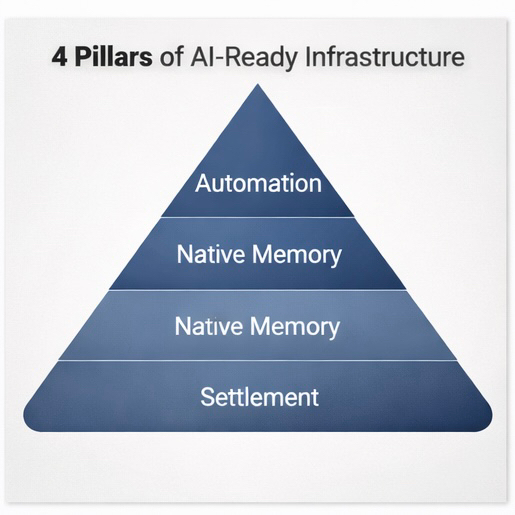

Após testar várias configurações, percebi que a verdadeira prontidão para IA repousa sobre quatro fundamentos. Falhe em um, e o sistema colapsa. Primeiro, memória nativa: sem memória persistente e verificável, os agentes redefinem o contexto infinitamente, a eficiência morre, os custos aumentam e o aprendizado desaparece. Segundo, raciocínio em cadeia: se o raciocínio vive fora da cadeia, você herda latência, lacunas de confiança e decisões opacas, transformando “IA” em um wrapper oracular. Terceiro, automação: agentes que apenas sugerem ações são chatbots, enquanto agentes que executam de forma segura são trabalhadores. Quarto, liquidação: sem um fechamento econômico sem costura, os fluxos de trabalho permanecem teóricos, sem durabilidade ou escala. A maioria das cadeias entrega um, talvez dois. Quase nenhuma entrega todos os quatro.

O que torna o Vanar interessante não é a marca, mas a arquitetura. Em vez de adicionar IA por cima, a pilha é construída em torno dela. O Neutron comprime grandes conjuntos de dados em Seeds compactos e verificáveis, permitindo que os agentes mantenham o contexto histórico em reinicializações e migrações sem reconstruções ou loops de re-obtenção. O Kayon processa consultas em linguagem natural diretamente sobre o contexto armazenado na cadeia, sem APIs opacas ou serviços externos. Flows, atualmente em desenvolvimento, conecta condições a ações de forma nativa, removendo camadas de automação frágeis. E $VANRY vincula a liquidação a cada operação significativa — criação de memória, ciclos de raciocínio e fluxos de trabalho — incorporando o token em uso real em vez de hype.

Quando testei um agente de risco RWA básico no Vanar, algo inesperado aconteceu: parei de me preocupar com reinicializações. Pausei fluxos de trabalho, ajustei a lógica e deixei os agentes inativos — e nada quebrou. Sem perda de contexto, sem backups de pânico, sem reconstruções. Essa mudança psicológica é importante. Quando a memória é confiável, os construtores experimentam mais. Quando a experimentação é segura, os protótipos sobrevivem. E quando os protótipos sobrevivem, os produtos emergem — não por meio de incentivos, mas por meio de confiança.

A maioria dos “tokens de IA” hoje negocia histórias. O Vanar negocia mecânicas. A criação de Seeds, chamadas de raciocínio e fluxos de longa duração queimam gás por meio de operações reais. À medida que os sistemas amadurecem, a demanda cresce organicamente por meio do uso, em vez de campanhas. É por isso que a exposição ao $VANRY aqui parece estrutural, não especulativa. Em uma fase de baixa capitalização em torno da faixa de $20M e perto de $0,006, o mercado está precificando o risco narrativo mais do que o potencial de uso — uma lacuna que raramente dura para sempre.

Ainda classificamos as cadeias por TPS, taxas e latência. Sistemas de IA se preocupam com persistência, confiabilidade, auditabilidade e continuidade. É uma era diferente com um placar diferente. Em 2026, as plataformas dominantes não serão as mais rápidas, mas aquelas onde sistemas inteligentes não esquecem o dia anterior.

Eu parei de me importar com velocidade bruta quando os sistemas não conseguem lembrar.

Com base em meus próprios testes, isso não é teórico. O Vanar transforma demos frágeis em ferramentas que eu realmente usaria diariamente. Menos recuperação, mais melhoria. Menos manutenção, mais acumulação. Se a equipe continuar priorizando a infraestrutura em vez da aparência, “pronta para IA” pode finalmente significar algo mensurável em vez de comercializável.

Você já tentou executar agentes em cadeias “rápidas” versus aquelas com foco em memória? O que quebrou primeiro para você — contexto, custos ou confiança?