Redes de GPU descentralizadas estão se apresentando como uma camada de menor custo para executar cargas de trabalho de IA, enquanto o treinamento dos modelos mais recentes permanece concentrado dentro de centros de dados hiperescaláveis.

O treinamento de IA de fronteira envolve a construção dos maiores e mais avançados sistemas, um processo que requer milhares de GPUs para operar em estreita sincronização.

Esse nível de coordenação torna as redes descentralizadas impraticáveis para o treinamento de IA de alta performance, onde a latência e a confiabilidade da internet não podem igualar o hardware fortemente acoplado em centros de dados centralizados.

A maioria das cargas de trabalho de IA em produção não se assemelha ao treinamento de modelos em larga escala, abrindo espaço para que redes descentralizadas lidem com inferência e tarefas cotidianas.

“O que estamos começando a ver é que muitos modelos de código aberto e outros estão se tornando compactos e otimizados o suficiente para rodar de forma muito eficiente em GPUs de consumo”, disse Mitch Liu, cofundador e CEO da Theta Network, ao Cointelegraph. “Isso está criando uma mudança em direção a modelos de código aberto mais eficientes e abordagens de processamento mais econômicas.”

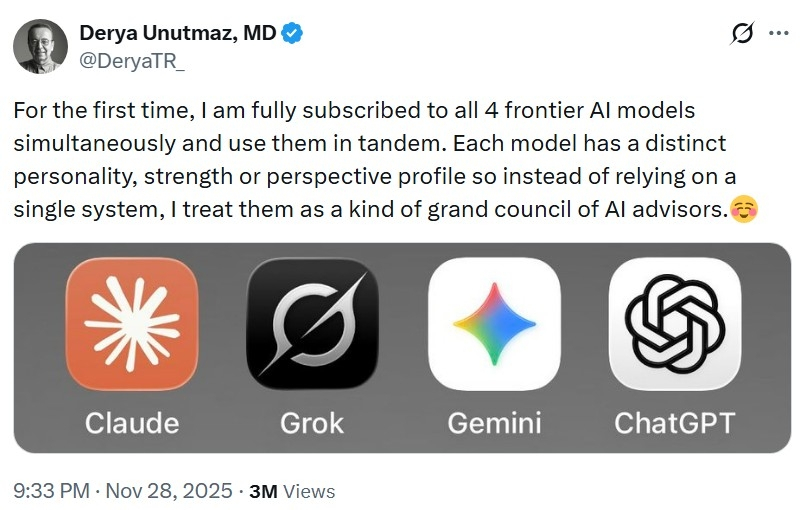

O treinamento de modelos de IA de ponta exige alto poder de processamento de GPUs e permanece concentrado em data centers de hiperescala. Fonte: Derya Unutmaz

O treinamento de modelos de IA de ponta exige alto poder de processamento de GPUs e permanece concentrado em data centers de hiperescala. Fonte: Derya Unutmaz

Do treinamento de IA de ponta à inferência cotidiana.

O treinamento de ponta está concentrado em alguns poucos operadores de hiperescala, já que executar grandes tarefas de treinamento é caro e complexo. O hardware de IA mais recente, como o Vera Rubin da Nvidia, é projetado para otimizar o desempenho em ambientes de data center integrados.

“Você pode pensar no treinamento de modelos de IA de ponta como a construção de um arranha-céu”, disse Nökkvi Dan Ellidason, CEO da empresa de infraestrutura Ovia Systems (antiga Gaimin), ao Cointelegraph. “Em um data center centralizado, todos os trabalhadores estão no mesmo andaime, passando tijolos manualmente.”

Esse nível de integração deixa pouco espaço para a coordenação frouxa e a latência variável típicas de redes distribuídas.

“Para construir o mesmo arranha-céu [em uma rede descentralizada], eles precisam enviar cada tijolo uns aos outros pelo correio, através da internet aberta, o que é extremamente ineficiente”, continuou Ellidason.

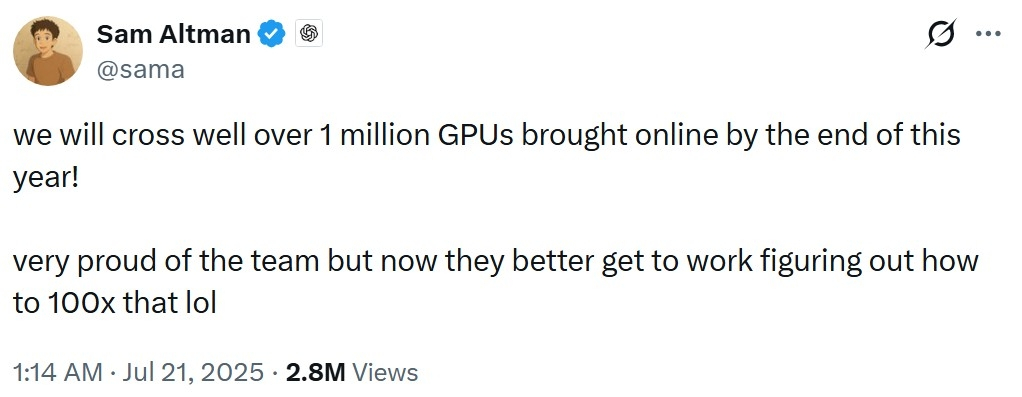

Gigantes da IA continuam a absorver uma parcela crescente do fornecimento global de GPUs. Fonte: Sam Altman

Gigantes da IA continuam a absorver uma parcela crescente do fornecimento global de GPUs. Fonte: Sam Altman

A Meta treinou seu modelo de IA Llama 4 usando um cluster com mais de 100.000 GPUs Nvidia H100. A OpenAI não divulga o tamanho dos clusters de GPUs usados para treinar seus modelos, mas o líder de infraestrutura, Anuj Saharan, afirmou que o GPT-5 foi lançado com o suporte de mais de 200.000 GPUs, sem especificar quanta dessa capacidade foi usada para treinamento, inferência ou outras cargas de trabalho.

Inferência refere-se à execução de modelos treinados para gerar respostas para usuários e aplicativos. Ellidason afirmou que o mercado de IA atingiu um "ponto de inflexão na inferência". Embora o treinamento tenha dominado a demanda por GPUs até 2024, ele estimou que até 70% da demanda será impulsionada por cargas de trabalho de inferência, agentes e previsão em 2026.

“Isso transformou o custo da computação, antes associado à pesquisa, em um custo de utilidade contínuo e escalável”, disse Ellidason. “Assim, o multiplicador de demanda por meio de loops internos torna a computação descentralizada uma opção viável no contexto da computação híbrida.”

Relacionado: Por que a infraestrutura das criptomoedas ainda não alcançou seus ideais

Onde se encaixam, de fato, as redes de GPUs descentralizadas

Redes de GPUs descentralizadas são mais adequadas para cargas de trabalho que podem ser divididas, roteadas e executadas de forma independente, sem exigir sincronização constante entre as máquinas.

“A inferência é um negócio de grande volume, e escala com cada modelo implantado e ciclo de agente”, disse Evgeny Ponomarev, cofundador da plataforma de computação descentralizada Fluence, ao Cointelegraph. “É aí que o custo, a elasticidade e a abrangência geográfica importam mais do que interconexões perfeitas.”

Na prática, isso faz com que GPUs descentralizadas e voltadas para jogos, em ambientes de consumo, sejam mais adequadas para cargas de trabalho de produção que priorizam a taxa de transferência e a flexibilidade em detrimento da coordenação rígida.

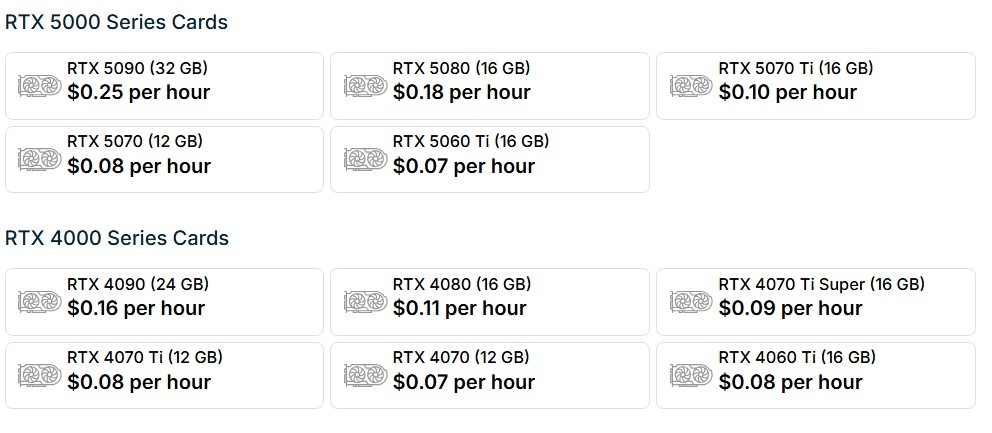

Os baixos preços por hora das GPUs para consumidores ilustram por que as redes descentralizadas priorizam a inferência em vez do treinamento de modelos em larga escala. Fonte: Salad.com

Os baixos preços por hora das GPUs para consumidores ilustram por que as redes descentralizadas priorizam a inferência em vez do treinamento de modelos em larga escala. Fonte: Salad.com

“As GPUs para consumidores, com menos VRAM e conexões de internet doméstica, não fazem sentido para treinamento ou cargas de trabalho altamente sensíveis à latência”, disse Bob Miles, CEO da Salad Technologies — um agregador de GPUs ociosas para consumidores — ao Cointelegraph.

“Hoje, elas são mais adequadas para descoberta de medicamentos por IA, conversão de texto em imagem/vídeo e fluxos de processamento de dados em larga escala — qualquer carga de trabalho sensível a custos, as GPUs para consumidores se destacam pela relação custo-benefício.”

Redes de GPUs descentralizadas também são adequadas para tarefas como coleta, limpeza e preparação de dados para treinamento de modelos. Essas tarefas geralmente exigem amplo acesso à internet aberta e podem ser executadas em paralelo sem grande necessidade de coordenação.

Segundo Miles, esse tipo de trabalho é difícil de executar com eficiência em data centers de hiperescala sem uma extensa infraestrutura de proxy.

Ao atender usuários em todo o mundo, um modelo descentralizado pode ter uma vantagem geográfica, pois pode reduzir as distâncias que as solicitações precisam percorrer e os múltiplos saltos de rede antes de chegar a um centro de dados, o que pode aumentar a latência.

“Em um modelo descentralizado, as GPUs são distribuídas em vários locais ao redor do mundo, geralmente muito mais perto dos usuários finais. Como resultado, a latência entre o usuário e a GPU pode ser significativamente menor em comparação com o roteamento do tráfego para um data center centralizado”, disse Liu, da Theta Network.

A Theta Network enfrenta um processo judicial aberto em Los Angeles em dezembro de 2025 por dois ex-funcionários, que alegam fraude e manipulação de tokens. Liu afirmou que não poderia comentar o assunto por se tratar de um litígio em andamento. A Theta já negou as acusações anteriormente.

Relacionado: Como a negociação de criptomoedas por IA vai definir os papéis humanos

Uma camada complementar na computação de IA

O treinamento de IA de ponta permanecerá centralizado num futuro próximo, mas a computação de IA está migrando para inferência, agentes e cargas de trabalho de produção que exigem uma coordenação mais flexível. Essas cargas de trabalho valorizam a eficiência de custos, a distribuição geográfica e a elasticidade.

“Este ciclo testemunhou o surgimento de muitos modelos de código aberto que não têm a escala de sistemas como o ChatGPT, mas ainda são capazes de rodar em computadores pessoais equipados com GPUs como a RTX 4090 ou 5090”, disse Jieyi Long, cofundador de Liu e chefe de tecnologia da Theta, ao Cointelegraph.

Com esse nível de hardware, os usuários podem executar modelos de difusão, modelos de reconstrução 3D e outras cargas de trabalho relevantes localmente, criando uma oportunidade para que os usuários finais compartilhem seus recursos de GPU, de acordo com Long.

As redes de GPUs descentralizadas não substituem os hiperescaladores, mas estão se tornando uma camada complementar.

À medida que o hardware de consumo se torna mais capaz e os modelos de código aberto se tornam mais eficientes, uma classe crescente de tarefas de IA pode migrar para fora dos centros de dados centralizados, permitindo que modelos descentralizados se encaixem na infraestrutura de IA.

Revista: 6 dispositivos mais estranhos que as pessoas já usaram para minerar Bitcoin e criptomoedas.