Użytkownik sieci społecznościowej X pod pseudonimem Alex Prompter opublikował 14 stycznia ujawnione wewnętrzne dokumenty OpenAI z sensacyjnym twierdzeniem: Ilya Sutskever — jeden z fundatorów firmy i byłym szefem naukowym — allegedly udowodnił fizyczną niemożliwość stworzenia sztucznego inteligencji ogólnego.

Sutskever jest uważany za jednego z wiodących specjalistów w dziedzinie sieci neuronowych na świecie. Brał udział w tworzeniu GPT i był kluczową postacią w rozwoju ChatGPT. W maju 2024 roku opuścił OpenAI, aby założyć swoją własną firmę Safe Superintelligence, poświęconą bezpiecznemu rozwojowi AI.

AGI (Sztuczna Ogólna Inteligencja) to hipotetyczny system sztucznej inteligencji zdolny do wykonywania wszelkich zadań intelektualnych na poziomie człowieka lub przewyższania go. W przeciwieństwie do nowoczesnych wąsko wyspecjalizowanych algorytmów, takich jak ChatGPT czy systemy rozpoznawania obrazów, AGI powinien mieć uniwersalne zdolności poznawcze.

Zasada Landauera: dlaczego zapominanie kosztuje energię

Podstawą spekulacji jest zasada Landauera, odkryta przez fizyka IBM Rolfem Landauera w 1961 roku. Prawo to łączy informacje z fizyką i ustala minimalną energetyczną cenę za usunięcie danych.

Wyobraź sobie pamięć komputera jako zestaw przełączników, z których każdy może znajdować się w pozycji „0” lub „1”. Kiedy usuwamy bit informacji – na przykład wymuszając ustawienie go na „0” niezależnie od poprzedniego stanu – fizycznie niszczymy różnicę między tymi dwoma stanami.

Zgodnie z drugim prawem termodynamiki, całkowita entropia (miara nieporządku) we Wszechświecie nigdy nie może maleć. Usuwanie bitu zmniejsza entropię w komputerze, dlatego aby zachować równowagę, entropia otoczenia musi wzrosnąć. To zwiększenie następuje poprzez wydzielanie ciepła.

Minimalna energia usuwania opisana jest wzorem E ≥ kT ln 2, gdzie k to stała Boltzmanna (1,38×10-23 J/K), T to temperatura w kelwinach, a ln 2 ≈ 0,693 to logarytm naturalny liczby dwa. Przy temperaturze pokojowej (300K) wynosi to zaledwie 2,9×10-21 J na bit – milion miliardów razy mniej energii, potrzebnej do podniesienia pyłku o milimetr.

Krytycznie ważne: zasada działa tylko dla nieodwracalnych operacji usuwania informacji. Logicznie odwracalne operacje, w których każdemu wejściu odpowiada unikalne wyjście, teoretycznie mogą być wykonywane bez wydatków energetycznych.

Od mikro watów do energii Słońca

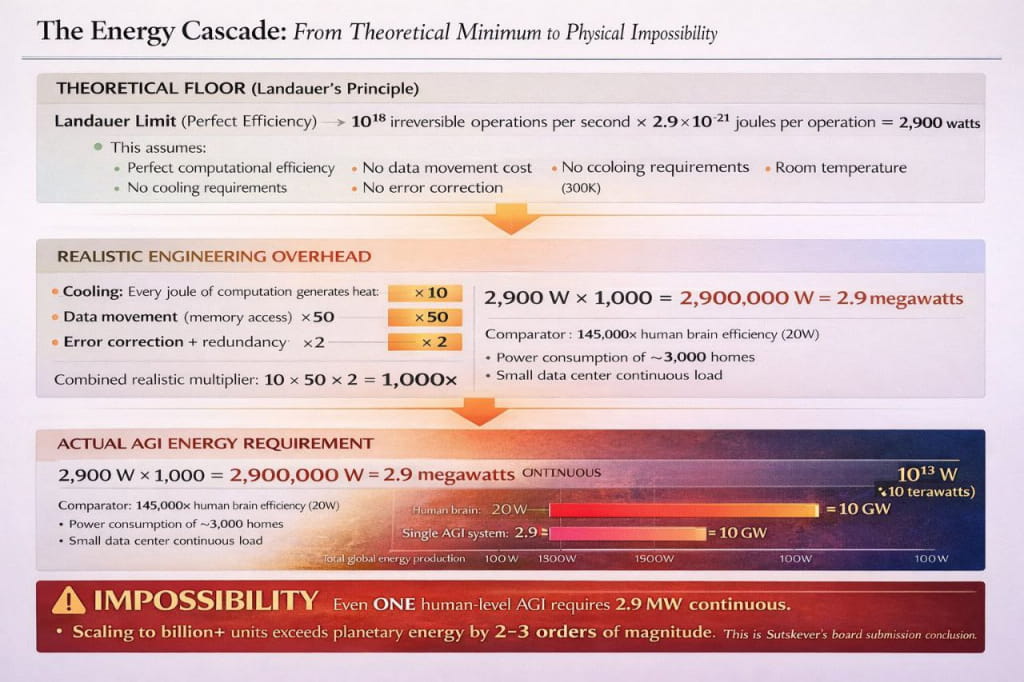

W dołączonych do publikacji profesjonalnie przygotowanych slajdach twierdzi się, że AGI wymaga 1018 nieodwracalnych operacji na sekundę. Mnożąc przez energię Landauera, autorzy uzyskują teoretyczne minimum 2900 W – 145 razy większe zużycie energii ludzkiego mózgu.

Następnie „obliczenia” stają się bardziej skomplikowane. Z uwagi na rzeczywiste ograniczenia inżynieryjne – chłodzenie (zwiększa zużycie 10 razy), przesył danych między procesorem a pamięcią (50 razy), korekcja błędów (2 razy) – autorzy oszustwa uzyskują 2,9 MW dla jednego systemu AGI. To zużycie energii małego miasta w celu symulacji jednego ludzkiego umysłu.

Ale główną „bombą” jest skalowanie. Zgodnie z fałszywymi dokumentami, dla obsługi całej ludzkości potrzebne będą miliardy systemów AGI. Autorzy twierdzą, że doprowadzi to do zużycia energii 1021 W – milion razy więcej całej energii produkowanej przez ludzkość, i rzekomo przekracza zasoby energetyczne całego Układu Słonecznego.

Podejrzanie wysokiej jakości fałszywka

Do publikacji dołączone są profesjonalnie wyglądające dokumenty: prezentacje z wykresami, rzekomo wewnętrzna korespondencja rady dyrektorów OpenAI, zrzuty ekranu z Slacka z dyskusjami kierownictwa. W „dokumentach” twierdzi się, że Sam Altman przyznawał słuszność obliczeniom Sutskevera, ale nazywał je „technicznie poprawnymi, ale strategicznie niewłaściwymi”.

Przepis na oszustwo: fakt naukowy × „realistyczne” współczynniki = absurdalny wynik

Przepis na oszustwo: fakt naukowy × „realistyczne” współczynniki = absurdalny wynik

Fałszywe materiały zawierają nawet szczegółową chronologię rzekomego kryzysu, który miał miejsce w listopadzie 2023 roku w radzie dyrektorów OpenAI z powodu ograniczeń termodynamicznych. Jakość fałszywki zdradza jej sztuczne pochodzenie: zbyt wiele pieczątek „CONFIDENTIAL”, profesjonalny design prezentacji i wiarygodne, ale sfabrykowane wewnętrzne korespondencje.

Naukowa krytyka

Oświadczenia Alex Prompter natychmiast wywołały krytykę ekspertów. Analityk Roko nazwał pomysł o niemożności AGI „najbardziej idiotyczną rzeczą o AI, jaką kiedykolwiek czytał”.

Specjalista TokyoL7G wyjaśnił fundamentalny błąd: „Ludzki mózg działa przy mocy około 20 W. Nie dlatego, że narusza termodynamikę, ale dlatego, że jest niezwykle efektywnym asynchronicznym systemem”.

Ekspert 9DATTM wskazał na błędy metodologiczne: niewłaściwe równanie granicy Landauera z wymaganiami inteligencji, ignorowanie kompresji algorytmicznej i możliwości energooszczędnych obliczeń odwracalnych.

Rzeczywistość zużycia energii AI

Nowoczesne systemy AI naprawdę wymagają kolosalnych nakładów energetycznych, ale jest to związane z niedoskonałością istniejących technologii, a nie z fundamentalnymi ograniczeniami fizycznymi. Szkolenie GPT-3 wymagało około 1300 MWh, centra danych dla AI zużywają megawaty nieprzerwanie – to zużycie energii całych miast.

Jednak ludzki mózg dowodzi możliwości wysokoefektywnych obliczeń: 86 miliardów neuronów przetwarzających skomplikowane informacje przy zużyciu zaledwie 20 W. Zasada Landauera nie przeszkadza w tworzeniu energooszczędnych architektur – ustanawia jedynie teoretyczne minimum dla nieodwracalnych operacji usuwania.

Brak potwierdzeń

Ani Ilya Sutskever, ani OpenAI nie potwierdzili istnienia takich badań. Publiczne wypowiedzi Sutskevera z maja 2024 roku wyrażają pewność w osiągalności AGI z naciskiem na bezpieczeństwo. Strona jego nowej firmy Safe Superintelligence koncentruje się na tworzeniu bezpiecznego AI bez wzmiankowania o barierach termodynamicznych.

Przedstawione materiały to wyrafinowana dezinformacja oparta na niepoprawnym zastosowaniu zasad fizycznych i ekstrapolacji wątpliwych założeń do absurdu. Fałszywka demonstruje rosnącą wyrafinowanie fałszywych przecieków w erze AI, ale społeczność naukowa jednogłośnie odrzuca takie pseudonaukowe spekulacje na temat energetycznej niemożności stworzenia efektywnej sztucznej inteligencji.

Opinia AI

Analiza historycznych wzorców dezinformacji pokazuje interesującą zasadę: najbardziej efektowne naukowe oszustwa zawsze wykorzystują rzeczywiste zasady fizyczne. Zimna synteza z 1989 roku również opierała się na prawdziwych reakcjach jądrowych, ale z fałszywymi danymi. Zasada Landauera odgrywa tutaj rolę idealnego „hak” – jest wystarczająco skomplikowana, aby większość nie mogła jej zweryfikować, ale wystarczająco fundamentalna, aby brzmieć przekonywująco.

Makroekonomiczny kontekst tworzenia takich fałszywek zasługuje na uwagę. Przemysł AI przeżywa okres maksymalnych inwestycji i oczekiwań – klasyczną fazę bańki, kiedy jakiekolwiek wątpliwości w technologicznej osiągalności mogą zrujnować miliardowe inwestycje. Taki atak informacyjny potencjalnie może wpłynąć na notowania giełdowe gigantów technologicznych. Zostaje pytanie: komu opłaca się podważać wiarę w AGI właśnie teraz?